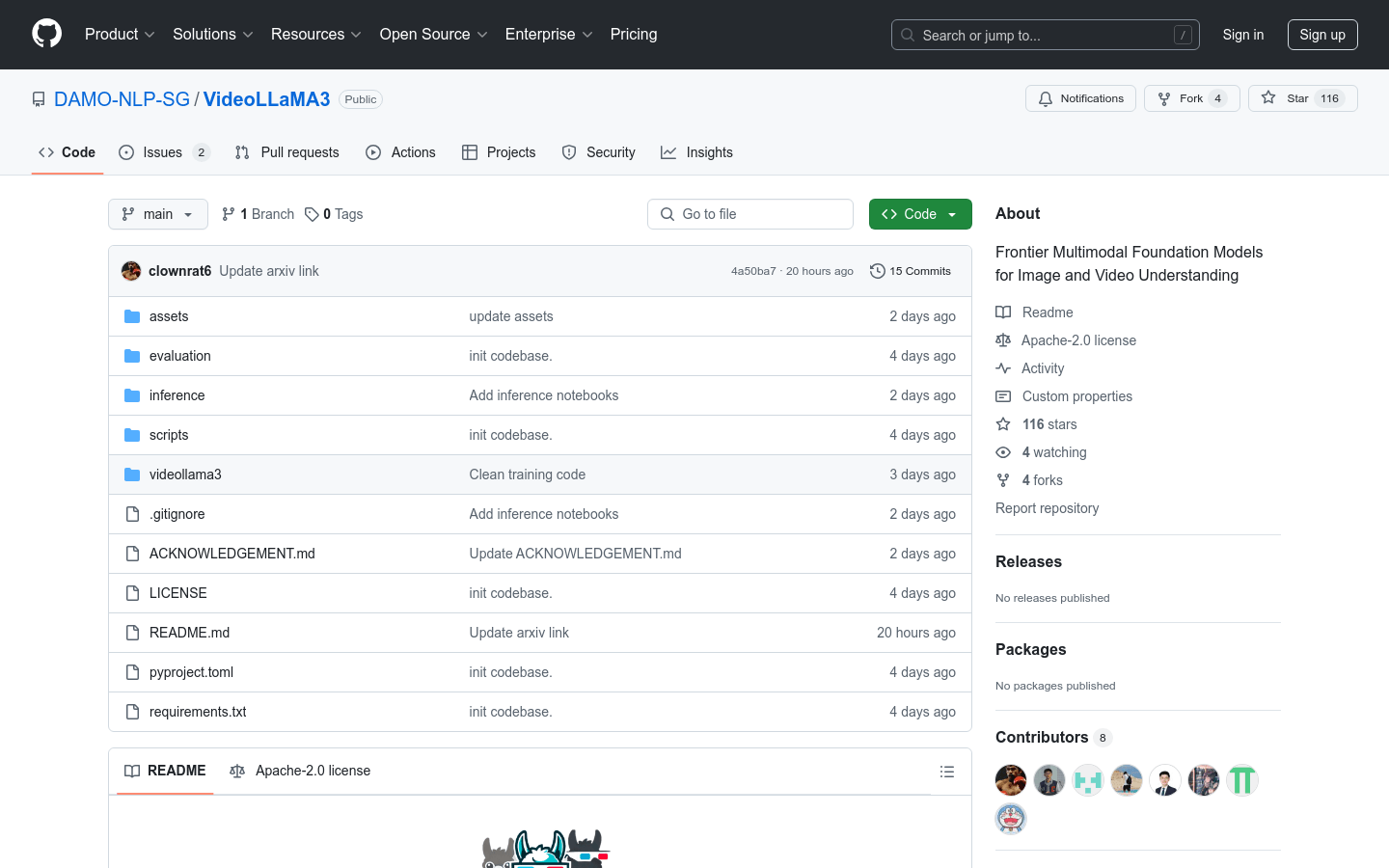

VideoLLaMA3

VideoLLaMA3 es un modelo base multimodal de vanguardia, especializado en la comprensión de imágenes y videos.

VideoLLaMA3 Situación del tráfico más reciente

Total de visitas mensuales

521149929

Tasa de rebote

35.96%

Páginas promedio por visita

6.1

Duración promedio de la visita

00:06:29