Le laboratoire de recherche IA indépendant et à but non lucratif français Kyutai a lancé Moshi, un modèle de base multimodale natif en temps réel révolutionnaire. Ce modèle innovant imite et surpasse, sur certains points, les fonctionnalités présentées par OpenAI avec GPT-4o en mai dernier.

Accès au produit :https://top.aibase.com/tool/moshi-chat

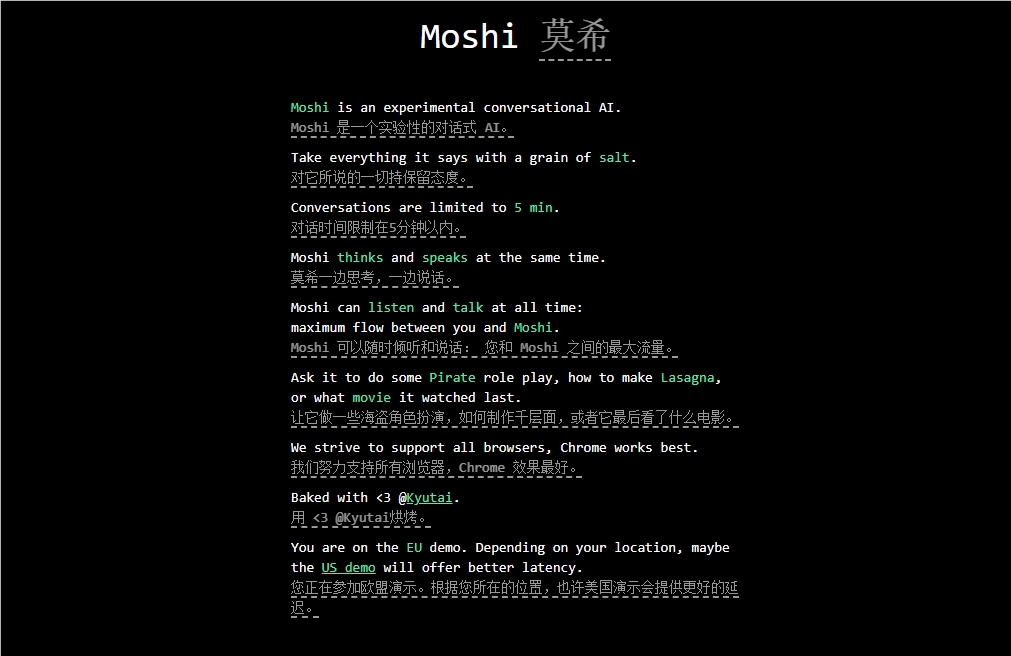

Moshi est conçu pour comprendre et exprimer les émotions, et possède la capacité de converser avec différents accents (y compris le français). Il peut simultanément écouter et générer de l'audio et de la voix, tout en maintenant une communication textuelle fluide. Il est capable d'exprimer une large gamme d'émotions humaines, environ 70 nuances émotionnelles et stylistiques.

Une caractéristique remarquable de Moshi est sa capacité à traiter deux flux audio simultanément, lui permettant d'écouter et de parler en même temps. Cette interaction en temps réel est rendue possible grâce à un pré-entraînement conjoint sur du texte et de l'audio, utilisant des données textuelles synthétiques générées par Helium, le modèle linguistique de 7 milliards de paramètres développé par Kyutai.

Le processus d'ajustement fin de Moshi a impliqué 100 000 dialogues synthétiques de style conversationnel convertis via la technologie de synthèse vocale (TTS). La voix du modèle a été entraînée sur des données synthétiques générées par un autre modèle TTS, atteignant un temps de latence impressionnant de 200 millisecondes.

Il est important de noter que Kyutai a également développé une version plus légère de Moshi, capable de fonctionner sur un MacBook ou un GPU grand public, rendant ainsi le modèle accessible à un plus large public.

Points clés : 🔍 Kyutai lance Moshi, un modèle IA de base multimodale natif en temps réel.

🔍 Moshi possède la capacité de comprendre et d'exprimer les émotions et prend en charge plusieurs accents.

🔍 Ce modèle, finement ajusté et entraîné, présente des performances efficaces et un potentiel d'applications diversifiées.