En mai, IBM a publié en open source le modèle linguistique Granite13B, conçu pour les applications d'entreprise. Aujourd'hui, Armand Ruiz, vice-président des produits de la plateforme IA d'IBM, a rendu public le contenu complet du jeu de données de 6,48 To utilisé pour entraîner Granite13B.

Ce jeu de données, après un prétraitement rigoureux, a été réduit à 2,07 To, soit une diminution de 68 %. Ruiz souligne que cette étape est cruciale pour garantir un jeu de données de haute qualité, impartial, éthique et conforme à la législation, répondant ainsi aux exigences des applications d'entreprise.

Le jeu de données est soigneusement constitué de plusieurs sources, notamment :

- arXiv : plus de 2,4 millions de prépublications scientifiques.

- Common Crawl : base de données de crawl web ouverte.

- DeepMind Mathematics : paires de questions-réponses mathématiques.

- Free Law : opinions juridiques du domaine public provenant des tribunaux américains.

- GitHub Clean : données de code provenant de CodeParrot.

- Hacker News : actualités en informatique et entrepreneuriat de 2007 à 2018.

- OpenWeb Text : version open source du corpus Web Text d'OpenAI.

- Project Gutenberg (PG-19) : livres électroniques gratuits axés sur les œuvres anciennes.

- Pubmed Central : articles sur la biomédecine et les sciences de la vie.

- SEC Filings : documents de dépôt 10-K/Q de la Securities and Exchange Commission (SEC) américaine (1934-2022).

- Stack Exchange : contenu généré par les utilisateurs du réseau Stack Exchange.

- USPTO : brevets américains délivrés de 1975 à mai 2023.

- Webhose : conversion de contenu web non structuré en données lisibles par machine.

- Wikimedia : huit projets Wikimedia en anglais.

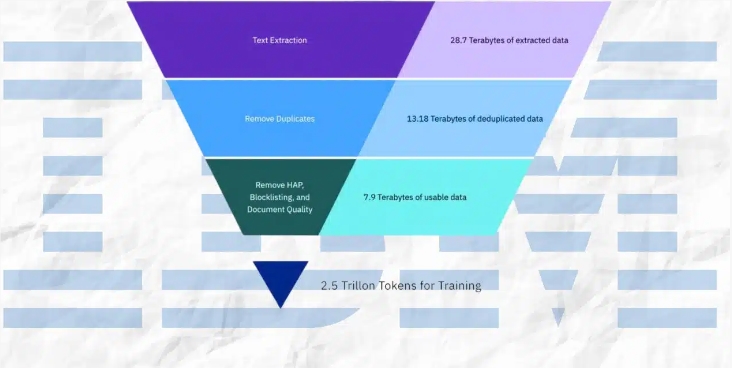

Le processus de prétraitement comprend l'extraction de texte, la déduplication, la reconnaissance linguistique, la segmentation des phrases, l'annotation de la haine, des abus et des grossièretés, l'annotation de la qualité des documents, l'annotation du masquage des URL, le filtrage et la tokenisation.

Ces étapes impliquent l'annotation et le filtrage basés sur des seuils définis, garantissant ainsi la qualité optimale du jeu de données final pour l'entraînement du modèle.

IBM a publié quatre versions du modèle de code Granite, avec un nombre de paramètres allant de 3 à 34 milliards. Ces modèles ont été testés sur une série de benchmarks et surpassent d'autres modèles comparables, tels que Code Llama et Llama3, dans de nombreuses tâches.

Points clés :

⭐ IBM a publié le jeu de données complet de 6,48 To utilisé pour entraîner le modèle LLM Granite13B.

⭐ Après un prétraitement rigoureux, le jeu de données a été réduit à 2,07 To, soit une diminution de 68 %.

⭐ IBM a publié quatre versions du modèle de code Granite, avec un nombre de paramètres allant de 3 à 34 milliards.