Groq a récemment lancé sur son site web un moteur LLM incroyablement rapide, permettant aux développeurs d'effectuer des requêtes et des tâches sur des grands modèles linguistiques de manière extrêmement rapide.

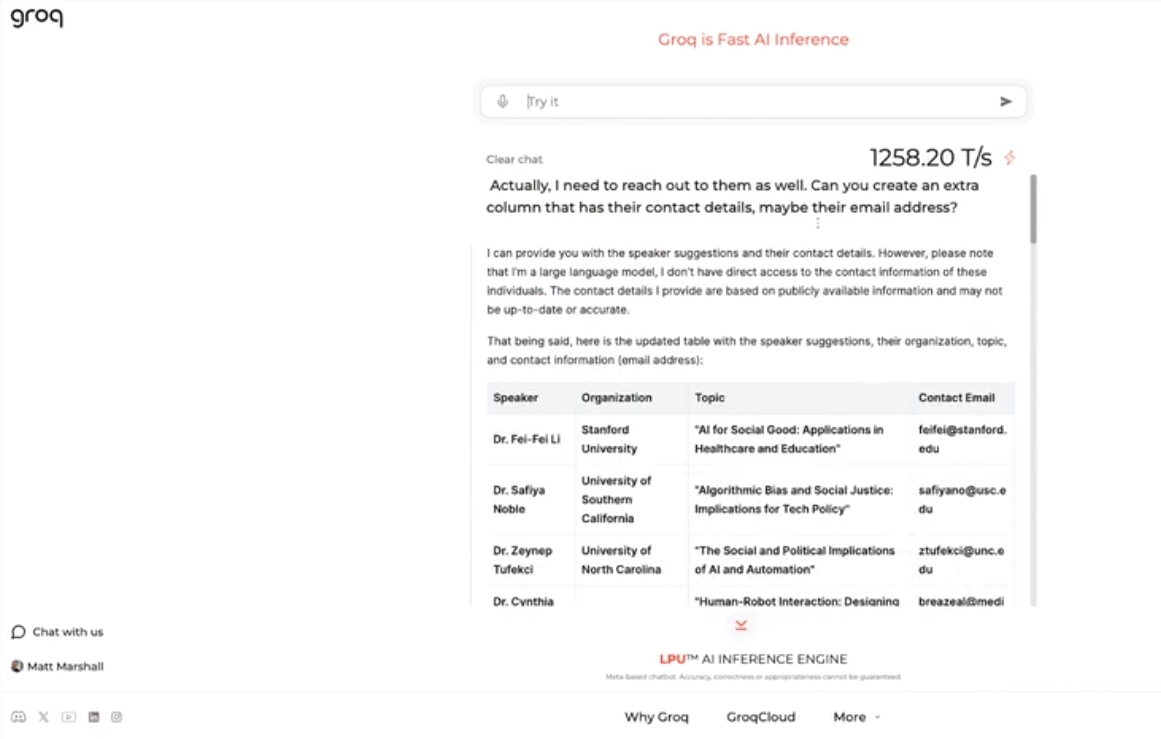

Ce moteur utilise le modèle Llama 3-8b-8192LLM open source de Meta, prend en charge d'autres modèles par défaut, et sa vitesse est époustouflante. Selon les tests, le moteur Groq peut traiter 1256,54 jetons par seconde, surpassant largement les puces GPU de Nvidia et autres. Cette avancée a suscité un vif intérêt auprès des développeurs et du grand public, démontrant la rapidité et la flexibilité des chatbots LLM.

Jonathan Ross, PDG de Groq, a déclaré que l'utilisation des LLM va encore augmenter, car les gens découvriront la simplicité d'utilisation sur le moteur rapide de Groq. Les démonstrations montrent qu'il est facile d'effectuer diverses tâches à cette vitesse, comme générer des annonces d'emploi ou modifier du contenu textuel. Le moteur Groq peut même répondre aux requêtes vocales, démontrant ainsi sa puissance et sa convivialité.

En plus d'offrir un service gratuit de charge de travail LLM, Groq fournit aux développeurs une console leur permettant de migrer facilement les applications construites sur OpenAI vers Groq.

Cette simplicité de migration a attiré un grand nombre de développeurs, plus de 280 000 personnes ayant déjà utilisé les services de Groq. Ross, le PDG, a déclaré que d'ici l'année prochaine, plus de la moitié des calculs d'inférence à l'échelle mondiale seraient exécutés sur les puces Groq, ce qui témoigne du potentiel et des perspectives de la société dans le domaine de l'IA.

Points clés :

🚀 Groq lance un moteur LLM incroyablement rapide, traitant 1256,54 jetons par seconde, dépassant largement la vitesse des GPU

🤖 Le moteur Groq démontre la rapidité et la flexibilité des chatbots LLM, attirant l'attention des développeurs et du grand public

💻 Groq offre un service gratuit de charge de travail LLM, utilisé par plus de 280 000 développeurs, et prévoit que plus de la moitié des calculs d'inférence mondiaux seront exécutés sur ses puces d'ici l'année prochaine