Dans le domaine de l'intelligence artificielle, la puissance de calcul et le temps ont toujours été des facteurs clés limitant le progrès technologique. Cependant, les derniers résultats de recherche de l'équipe DeepMind offrent une solution à ce problème.

Ils ont proposé une nouvelle méthode de filtrage des données appelée JEST, qui permet de réduire considérablement le temps d'entraînement de l'IA et les besoins en puissance de calcul en sélectionnant intelligemment les meilleurs lots de données pour l'entraînement. Il est affirmé que cela permet de réduire le temps d'entraînement de l'IA de 13 fois et de diminuer les besoins en puissance de calcul de 90 %.

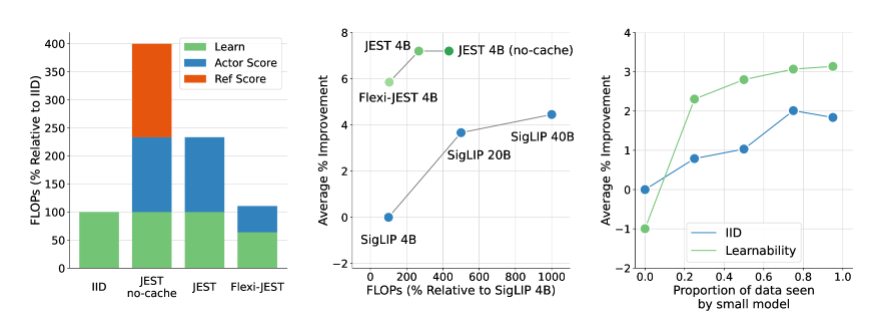

Le cœur de la méthode JEST réside dans la sélection conjointe des meilleurs lots de données, plutôt que des échantillons individuels. Cette stratégie s'est avérée particulièrement efficace pour accélérer l'apprentissage multi-modal. Comparée aux méthodes traditionnelles de filtrage des données d'entraînement à grande échelle, JEST réduit considérablement le nombre d'itérations et d'opérations en virgule flottante, surpassant les méthodes de pointe précédentes même avec seulement 10 % du budget FLOP.

La recherche de l'équipe DeepMind révèle trois conclusions clés : le choix de bons lots de données est plus efficace que le choix individuel de points de données, l'approximation de modèle en ligne peut être utilisée pour filtrer les données plus efficacement, et il est possible de guider les petits ensembles de données de haute qualité pour exploiter les ensembles de données non sélectionnés plus importants. Ces découvertes fournissent une base théorique pour les performances efficaces de la méthode JEST.

JEST fonctionne en s'appuyant sur des recherches antérieures sur la perte RHO, en combinant les pertes du modèle d'apprentissage et du modèle de référence pré-entraîné pour évaluer l'apprenabilité des points de données. Il sélectionne les points de données qui sont relativement faciles pour le modèle pré-entraîné, mais difficiles pour le modèle d'apprentissage actuel, afin d'améliorer l'efficacité et les résultats de l'entraînement.

De plus, JEST utilise une méthode itérative basée sur l'échantillonnage de Gibbs bloqué pour construire progressivement les lots. À chaque itération, un nouveau sous-ensemble d'échantillons est sélectionné en fonction du score d'apprenabilité conditionnelle. Cette méthode s'améliore continuellement en filtrant davantage de données, y compris en utilisant un modèle de référence pré-entraîné uniquement pour évaluer les données.

Cette recherche de DeepMind apporte non seulement une avancée révolutionnaire dans le domaine de l'entraînement de l'IA, mais offre également de nouvelles pistes et méthodes pour le développement futur des technologies d'IA. Avec l'optimisation et l'application futures de la méthode JEST, nous avons de bonnes raisons de croire que le développement de l'intelligence artificielle connaîtra des perspectives encore plus vastes.

Article : https://arxiv.org/abs/2406.17711

Points clés :

🚀 **Révolution de l'efficacité de l'entraînement**: La méthode JEST de DeepMind réduit le temps d'entraînement de l'IA de 13 fois et les besoins en puissance de calcul de 90 %.

🔍 **Filtrage des lots de données**: JEST améliore considérablement l'efficacité de l'apprentissage multi-modal en sélectionnant conjointement les meilleurs lots de données, plutôt que des échantillons individuels.

🛠️ **Méthode d'entraînement innovante**: JEST utilise l'approximation de modèle en ligne et la guidance par des ensembles de données de haute qualité pour optimiser la distribution des données d'entraînement à grande échelle et la capacité de généralisation du modèle.