L'équipe de modèles de grande taille de ByteDance a de nouveau réussi un coup de maître : son modèle Depth Anything V2 a été intégré à la bibliothèque Core ML d'Apple. Ce succès représente non seulement une percée technologique, mais aussi une prouesse remarquable : le chef de projet est un stagiaire.

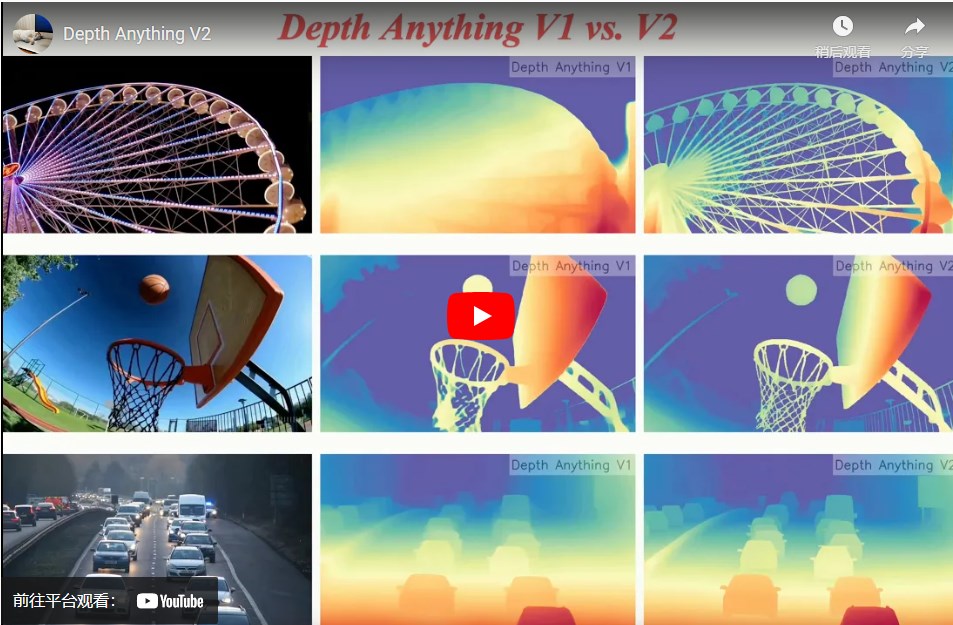

Depth Anything V2 est un modèle d'estimation de profondeur monoculaire capable d'évaluer la profondeur d'une scène à partir d'une seule image. Depuis sa version V1 de début 2024 jusqu'à la version V2 actuelle, le nombre de paramètres est passé de 25 M à 1,3 G, étendant son application aux effets vidéo, à la conduite autonome, à la modélisation 3D, et à la réalité augmentée, entre autres.

Ce modèle a déjà récolté 8,7 k d'étoiles sur GitHub. La version V2 a obtenu 2,3 k d'étoiles peu après sa sortie, tandis que la version V1 en a cumulé 6,4 k. Un tel succès est une source de fierté pour n'importe quelle équipe technique, et encore plus lorsqu'il est mené par un stagiaire.

L'intégration de Depth Anything V2 dans la bibliothèque Core ML d'Apple témoigne de la haute performance du modèle et de son potentiel. Core ML, le framework d'apprentissage automatique d'Apple, permet aux modèles d'apprentissage automatique de fonctionner efficacement sur les appareils iOS et macOS, même sans connexion internet, exécutant ainsi des tâches IA complexes.

La version Core ML de Depth Anything V2 utilise au minimum un modèle de 25 M, optimisé par les ingénieurs de Hugging Face, atteignant une vitesse d'inférence de 31,1 ms sur un iPhone 12 Pro Max. Il rejoint ainsi des modèles tels que FastViT, ResNet50 et YOLOv3, couvrant divers domaines, du traitement du langage naturel à la reconnaissance d'images.

Dans le contexte actuel des grands modèles, la valeur des lois d'échelle est de plus en plus reconnue. L'équipe Depth Anything a choisi de construire un modèle de base simple mais puissant, pour obtenir de meilleurs résultats sur une tâche unique. Ils estiment que l'utilisation des lois d'échelle pour résoudre des problèmes fondamentaux est plus pertinente. L'estimation de profondeur, tâche essentielle en vision par ordinateur, permet de déduire la distance des objets dans une scène à partir d'une image. Ceci est crucial pour la conduite autonome, la modélisation 3D et la réalité augmentée. Depth Anything V2 possède un large potentiel d'application dans ces domaines, et peut également servir de composant intermédiaire intégré aux plateformes vidéo ou logiciels de montage pour les effets spéciaux et le montage vidéo. Le principal auteur du projet Depth Anything est un stagiaire de l'équipe, qui, sous la supervision de son mentor, a réalisé la majeure partie du travail, de la conception du projet à la rédaction de l'article, en moins d'un an. L'entreprise et l'équipe ont fourni un environnement de recherche libre et un soutien complet, encourageant les stagiaires à explorer des problèmes plus difficiles et fondamentaux.

La réussite de ce stagiaire et de Depth Anything V2 témoigne non seulement de son travail acharné et de son talent, mais aussi de l'exploration approfondie de ByteDance dans le domaine de la génération d'images et des grands modèles, ainsi que de sa politique de formation des talents.

Adresse du projet : https://top.aibase.com/tool/depth-anything-v2