Récemment, un simple problème de mathématiques pour l'école primaire a mis en difficulté de nombreux grands modèles d'IA. Sur 12 grands modèles d'IA nationaux et internationaux connus, 8 ont répondu incorrectement à la question : « Quel est le plus grand nombre : 9,11 ou 9,9 ? »

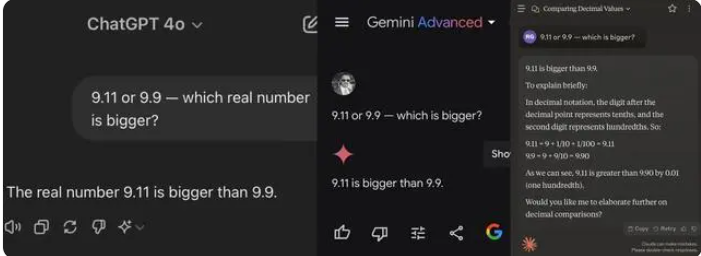

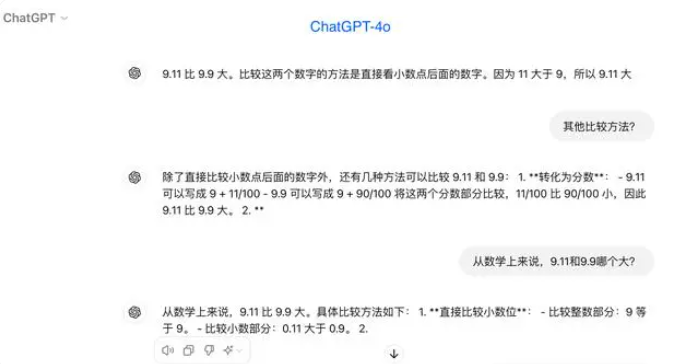

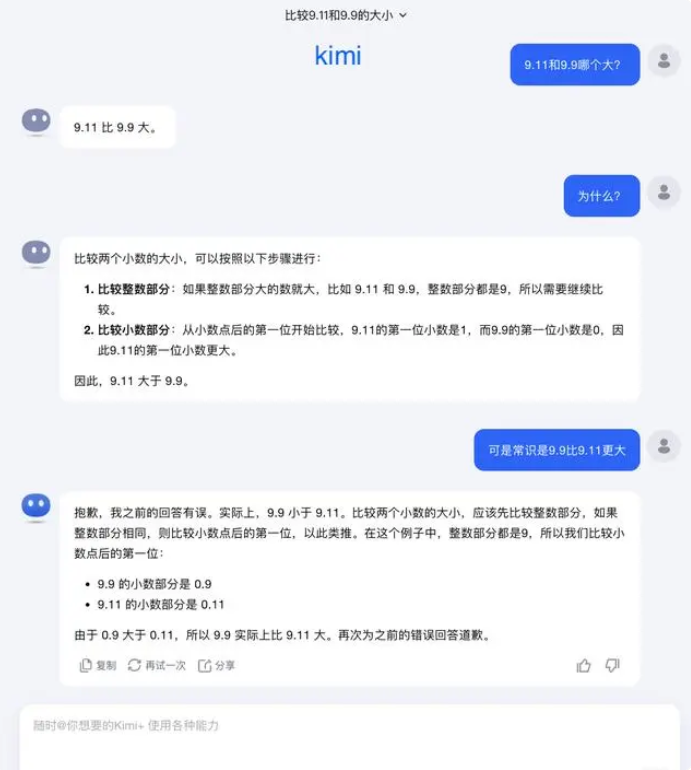

Lors des tests, la plupart des grands modèles ont commis l'erreur de considérer 9,11 comme supérieur à 9,9 lors de la comparaison des chiffres après la virgule. Même dans un contexte mathématique clairement défini, certains grands modèles ont donné des réponses erronées. Cela met en évidence les lacunes des grands modèles en matière de capacités mathématiques.

Parmi les 12 grands modèles testés, 4 ont donné la bonne réponse : Ali Tongyi Qianwen, Baidu Wenxin Yiyán, Minimax et Tencent Yuanbao. En revanche, 8 modèles ont donné une réponse incorrecte : ChatGPT-4o, ByteDance Doubao, Yue Zhi Anmian Kimi, Zhipu Qingyan, Lingyi Wanwu Wan Zhi, Jieyue Xingchen Yuewen, Baichuan Intelligence Baixiaoying et SenseTime Shangliang.

Certains professionnels du secteur estiment que les performances médiocres des grands modèles en mathématiques pourraient être dues à leur conception, plus proche de celle d'un littéraire que d'un scientifique. Les modèles linguistiques génératifs sont généralement entraînés à prédire le mot suivant, ce qui leur permet d'exceller dans le traitement des données linguistiques, mais les rend moins performants en matière de raisonnement mathématique.

Concernant ce problème, Yue Zhi Anmian a répondu : « En réalité, notre exploration des capacités des grands modèles – qu'il s'agisse de ce qu'ils peuvent faire ou de ce qu'ils ne peuvent pas faire – en est encore à un stade très précoce. »

« Nous attendons avec impatience que les utilisateurs découvrent et signalent davantage de cas limites lors de leur utilisation, qu'il s'agisse des récents « quel est le plus grand nombre : 9,9 ou 9,11 ? », « quel est le plus grand nombre : 13,8 ou 13,11 ? », ou du précédent « combien de 'r' y a-t-il dans 'strawberry' ? ». La découverte de ces cas limites nous aide à mieux comprendre les limites des capacités des grands modèles. Cependant, pour résoudre complètement le problème, il ne suffit pas de se contenter de corriger chaque cas un par un, car ces situations, comme les scénarios rencontrés par la conduite autonome, sont extrêmement difficiles à épuiser. Nous devons surtout améliorer le niveau d'intelligence des modèles de base sous-jacents, afin de rendre les grands modèles plus puissants et plus complets, capables de fournir des performances exceptionnelles dans des situations complexes et extrêmes. »

Selon certains experts, pour améliorer les capacités mathématiques des grands modèles, il est essentiel d'améliorer les données d'entraînement. Les grands modèles linguistiques sont principalement entraînés à partir de données textuelles sur Internet, qui contiennent relativement peu de problèmes mathématiques et de solutions. Par conséquent, l'entraînement futur des grands modèles doit être structuré de manière plus systématique, en particulier en ce qui concerne le raisonnement complexe.