Récemment, une équipe de chercheurs de l'École polytechnique fédérale de Lausanne (EPFL) en Suisse a présenté une nouvelle méthode, nommée ViPer (Visual Personalization of Generative Models via Individual Preference Learning), visant à personnaliser la sortie des modèles génératifs en fonction des préférences visuelles de l'utilisateur.

Cette innovation a été présentée lors de la prochaine conférence ECCV 2024. L'équipe souhaite permettre à chaque utilisateur d'obtenir des résultats générés plus conformes à ses goûts, même avec les mêmes invites.

Accès au produit :https://top.aibase.com/tool/viper

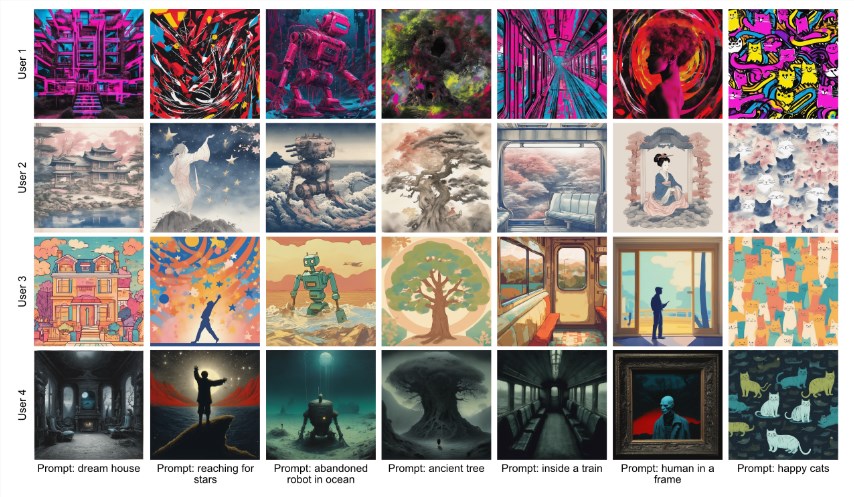

Le fonctionnement de ViPer est très simple. L'utilisateur n'a qu'à fournir une seule fois ses commentaires sur un ensemble d'images. Ces commentaires serviront à extraire ses préférences visuelles. Ainsi, le modèle génératif pourra être personnalisé sans invites complexes, en utilisant ces attributs pour générer des images conformes aux goûts de l'utilisateur.

En termes simples, cela ressemble un peu à la fonctionnalité de personnalisation précédemment lancée par Midjourney ( --personalize). Pour utiliser le modèle personnalisé de Midjourney, l'utilisateur doit avoir liké ou noté au moins 200 images dans les classements par paires. Ces notes et likes aident Midjourney à apprendre les préférences de l'utilisateur, permettant au modèle personnalisé de refléter plus précisément ses goûts.

Le modèle de ce projet a été publié sur la plateforme Hugging Face, et les utilisateurs peuvent facilement le télécharger et l'utiliser. Le modèle VPE de ViPer est finement ajusté pour extraire les préférences individuelles à partir d'une série d'images et de commentaires fournis par l'utilisateur.

De plus, le projet propose un modèle d'indicateur proxy capable de prédire le score de préférence d'une image de requête en fonction des images aimées et n'aimées par l'utilisateur. Cela signifie que l'utilisateur peut mieux comprendre ses goûts potentiels pour de nouvelles images.

Enfin, ViPer fournit un mécanisme de notation par proxy. L'utilisateur peut fournir des images aimées et n'aimées pour calculer la note d'une image de requête. Cette note varie de 0 à 1 ; plus la note est élevée, plus l'utilisateur aime l'image. L'équipe recommande à chaque utilisateur de fournir environ 8 images aimées et 8 images n'aimées pour garantir la précision des résultats.

Points clés :

🌟 ViPer extrait les préférences visuelles individuelles de l'utilisateur grâce à des commentaires uniques, personnalisant ainsi la sortie du modèle génératif.

🖼️ Le modèle de ce projet a été publié sur Hugging Face, et les utilisateurs peuvent facilement le télécharger et l'utiliser.

📊 ViPer fournit un mécanisme de notation par proxy pour aider les utilisateurs à prédire leur degré d'appréciation pour de nouvelles images.