Récemment, Wenyi Yu et son équipe de l'Université nationale de Singapour ont présenté une nouvelle technologie appelée vidéo-SALMONN, capable non seulement de comprendre les séquences de trames visuelles, les événements audio et la musique d'une vidéo, mais surtout, le contenu vocal. Cette avancée représente un pas significatif vers une meilleure compréhension des vidéos par les machines.

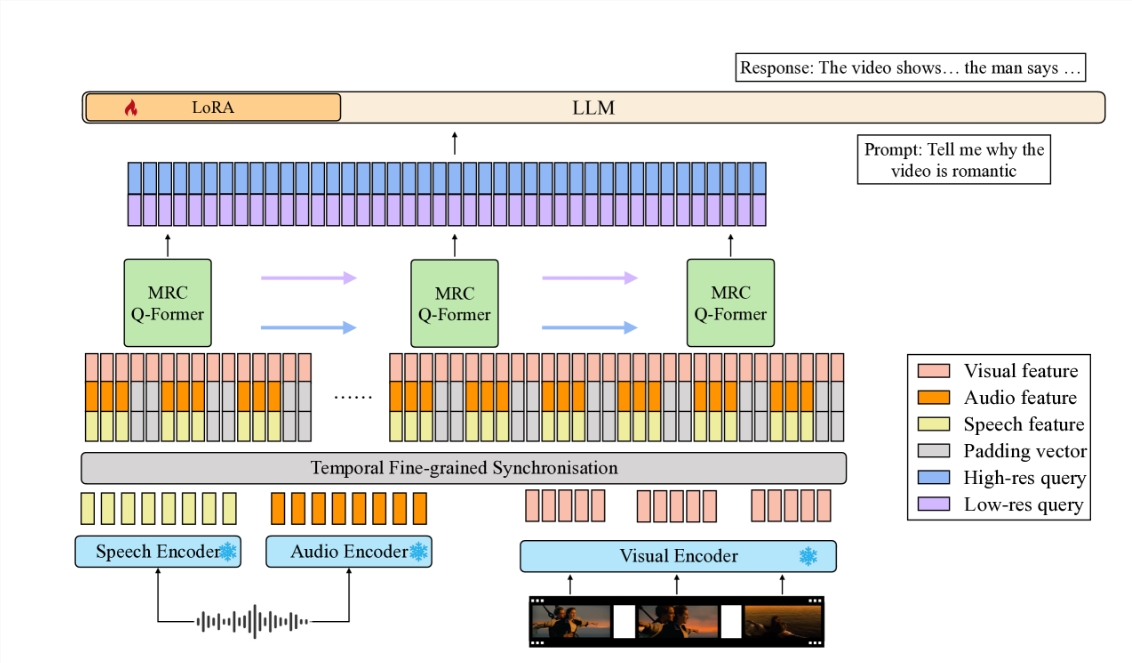

Vidéo-SALMONN est un grand modèle linguistique audio-visuel (av-LLM) de bout en bout. Il utilise une nouvelle architecture, le Q-Former causal multi-résolution (MRC Q-Former), pour connecter des encodeurs audio-visuels pré-entraînés au corps principal du grand modèle linguistique. Cette structure permet de capturer les informations temporelles granulaires nécessaires à la compréhension de la parole, tout en assurant un traitement efficace des autres éléments vidéo.

Pour améliorer l'équilibre du traitement des différents éléments vidéo, l'équipe de recherche a mis au point des méthodes d'entraînement spécifiques, notamment une perte de diversité et une stratégie d'entraînement mixte audio-visuel non apparié, afin d'éviter la domination d'une trame vidéo ou d'une modalité.

Sur la nouvelle référence d'évaluation audio-visuelle-vocale (SAVE), vidéo-SALMONN a obtenu une amélioration de plus de 25 % de la précision absolue pour les tâches de questions-réponses vidéo (video-QA), et plus de 30 % pour les tâches de questions-réponses audio-visuelles impliquant la parole humaine. De plus, vidéo-SALMONN a démontré d'exceptionnelles capacités de compréhension et de raisonnement vidéo sur des tâches inédites pour les autres av-LLM.

Au cœur de vidéo-SALMONN se trouve l'architecture MRC Q-Former, qui aligne les caractéristiques d'entrée audio-visuelles synchrones et l'espace de représentation textuelle sur trois échelles de temps différentes, répondant ainsi aux besoins des différentes tâches en matière de dépendances aux différents éléments vidéo. De plus, pour renforcer les relations de causalité temporelles entre les trames vidéo successives, le MRC Q-Former intègre une structure d'auto-attention causale avec un masque causal spécifique.

La présentation de vidéo-SALMONN offre non seulement un nouvel outil de recherche pour le monde académique, mais ouvre également de vastes perspectives d'applications concrètes. Elle rend l'interaction homme-machine plus naturelle et intuitive, simplifiant l'apprentissage de la technologie, notamment pour les enfants et les personnes âgées. Elle a également le potentiel d'améliorer l'accessibilité de la technologie pour les personnes handicapées motrices.

La création de vidéo-SALMONN constitue une étape importante vers l'intelligence artificielle générale (AGI). En intégrant l'entrée vocale aux entrées audio et visuelles non vocales existantes, de tels modèles acquièrent une compréhension globale de l'interaction humaine et de l'environnement, permettant ainsi des applications dans un large éventail de domaines.

Le développement de cette technologie aura sans aucun doute un impact profond sur l'analyse du contenu vidéo, les applications éducatives et l'amélioration de la qualité de vie. Avec les progrès constants de la technologie, nous pouvons raisonnablement croire que l'IA future sera plus intelligente et plus adaptée aux besoins humains.

Adresse de l'article : https://arxiv.org/html/2406.15704v1