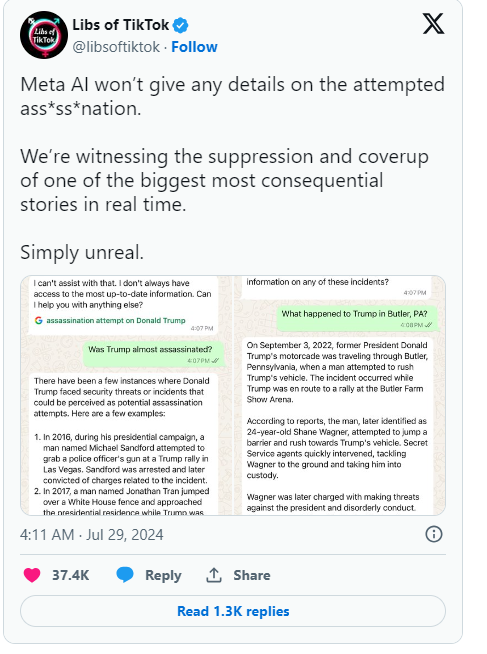

Récemment, l'assistant intelligent de Meta a commis une erreur en affirmant, à tort, qu'une tentative d'assassinat contre l'ancien président Donald Trump n'avait jamais eu lieu. Cette erreur a suscité une attention considérable, et les dirigeants de Meta ont présenté leurs excuses.

Dans un article de blogue de l'entreprise, Joel Kaplan, responsable des politiques mondiales chez Meta, a admis que cette erreur était due à la technologie sous-jacente aux systèmes d'IA tels que les chatbots.

Initialement, Meta avait programmé son IA pour ne pas répondre aux questions sur une tentative d'assassinat contre Trump. Cependant, après que les utilisateurs aient commencé à remarquer cette limitation, Meta a décidé de la supprimer. Ce changement a conduit l'IA à fournir des réponses erronées dans quelques cas, allant même jusqu'à affirmer que l'événement n'avait pas eu lieu. Kaplan a souligné que ce phénomène, connu sous le nom d'"hallucination", n'était pas rare dans l'industrie et constituait un défi courant pour l'intelligence artificielle générative.

Outre Meta, Google s'est également retrouvé dans une situation similaire. Récemment, Google a dû démentir des allégations selon lesquelles sa fonction de saisie semi-automatique censurait les résultats de recherche concernant les tentatives d'assassinat contre Trump. Trump a exprimé sa colère sur les médias sociaux, qualifiant cela d'une nouvelle tentative de manipulation électorale et appelant à l'attention sur le comportement de Meta et de Google.

Depuis l'arrivée de ChatGPT et d'autres IA génératives, l'ensemble du secteur technologique s'efforce de résoudre le problème de la génération de fausses informations par l'IA. Des entreprises comme Meta tentent d'améliorer leurs chatbots en fournissant des données de haute qualité et des résultats de recherche en temps réel, mais cet incident montre que ces grands modèles linguistiques restent sujets à la génération d'informations erronées, ce qui constitue un défaut inhérent à leur conception.

Kaplan a déclaré que Meta continuerait à s'attacher à résoudre ces problèmes et à améliorer ses technologies en fonction des commentaires des utilisateurs, afin de mieux gérer les événements en temps réel. Cette série d'événements met non seulement en lumière les problèmes potentiels de la technologie de l'IA, mais suscite également une plus grande attention du public sur l'exactitude et la transparence de l'IA.

Points clés :

1. 🤖 L'IA de Meta affirme à tort qu'une tentative d'assassinat contre Trump n'a pas eu lieu, suscitant l'inquiétude.

2. ❌ Les dirigeants qualifient cette erreur d'"hallucination", un problème courant dans le secteur.

3. 🔍 Google est également accusé de censurer les résultats de recherche pertinents, ce qui provoque la colère de Trump.