Récemment, la société Zyphra a lancé son nouveau modèle linguistique Zamba2-2.7B, une avancée majeure dans l'histoire des petits modèles linguistiques. Ce nouveau modèle affiche des améliorations significatives en termes de performances et d'efficacité. Entraîné sur un ensemble de données d'environ 3 000 milliards de jetons, il atteint des performances comparables à celles de Zamba1-7B et d'autres modèles 7B de pointe.

Plus surprenant encore, Zamba2-2.7B nécessite beaucoup moins de ressources lors de l'inférence, ce qui en fait une solution efficace pour les applications mobiles.

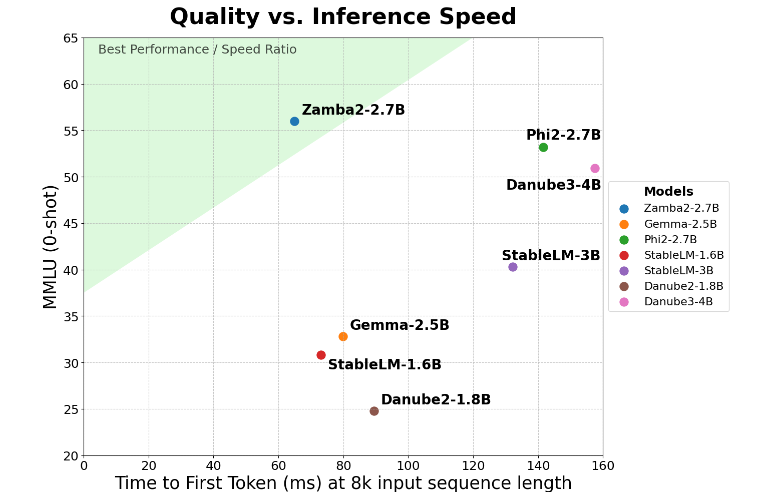

Zamba2-2.7B a doublé la vitesse de génération de la première réponse, un indicateur clé. Il génère donc des réponses initiales plus rapidement que ses concurrents. Ceci est crucial pour les applications nécessitant une interaction en temps réel, telles que les assistants virtuels et les chatbots.

Outre sa vitesse accrue, Zamba2-2.7B se distingue par son excellente gestion de la mémoire. Il réduit de 27 % la consommation de mémoire, ce qui en fait le choix idéal pour un déploiement sur des appareils aux ressources limitées. Cette gestion intelligente de la mémoire garantit un fonctionnement efficace même dans des environnements aux ressources de calcul restreintes, élargissant ainsi son champ d'application à divers appareils et plateformes.

Zamba2-2.7B présente un autre avantage notable : une latence de génération réduite. Comparé à Phi3-3.8B, sa latence est divisée par 1,29, pour des interactions plus fluides. Une faible latence est essentielle pour les applications nécessitant une communication continue et sans heurts, comme les robots de service client et les outils pédagogiques interactifs. Zamba2-2.7B est donc le choix privilégié des développeurs pour améliorer l'expérience utilisateur.

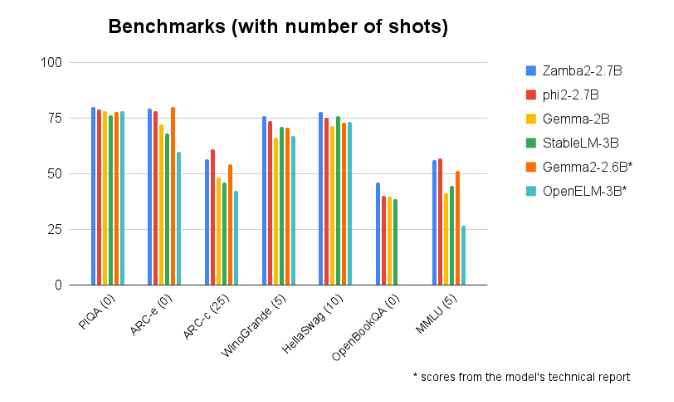

Lors de comparaisons avec d'autres modèles de taille similaire, Zamba2-2.7B a constamment démontré d'excellentes performances. Ses résultats exceptionnels témoignent de l'innovation et des efforts de Zyphra pour faire progresser l'intelligence artificielle. Ce modèle utilise un mécanisme d'attention partagée entrelacée amélioré et est équipé de projecteurs LoRA sur les modules MLP partagés, garantissant une sortie performante pour les tâches complexes.

Accès au modèle : https://huggingface.co/Zyphra/Zamba2-2.7B

Points clés :

🌟 Le modèle Zamba2-2.7B a doublé la vitesse de génération de la première réponse, idéal pour les applications interactives en temps réel.

💾 Ce modèle réduit de 27 % la consommation de mémoire, adapté aux appareils aux ressources limitées.

🚀 Zamba2-2.7B surpasse les modèles similaires en termes de latence de génération, améliorant ainsi l'expérience utilisateur.