La startup israélienne d'intelligence artificielle aiOla a récemment fait une grande annonce : le lancement d'un nouveau modèle de reconnaissance vocale open source, Whisper-Medusa.

Ce modèle est loin d'être ordinaire. Il est 50 % plus rapide que le célèbre Whisper d'OpenAI ! Il est basé sur Whisper, mais utilise une nouvelle architecture d'« attention multi-têtes » permettant de prédire un nombre de jetons bien supérieur à celui du produit d'OpenAI. De plus, le code et les poids ont été publiés sur Hugging Face sous licence MIT, autorisant ainsi leur utilisation à des fins de recherche et commerciales.

Gill Hetz, vice-président de la recherche chez aiOla, a déclaré que l'open source encouragerait l'innovation et la collaboration au sein de la communauté, conduisant à un modèle plus rapide et plus performant. Ce travail pourrait ouvrir la voie à des systèmes d'intelligence artificielle composites capables de comprendre et de répondre aux questions des utilisateurs en temps quasi réel.

À l'ère où les modèles de base peuvent générer une variété de contenus, une reconnaissance vocale de pointe reste essentielle. Whisper, capable de gérer des discours complexes dans différentes langues et avec différents accents, enregistre plus de 5 millions de téléchargements par mois et sert de support à de nombreuses applications, devenant ainsi la référence en matière de reconnaissance vocale.

Alors, qu'est-ce qui rend Whisper-Medusa d'aiOla si spécial ?

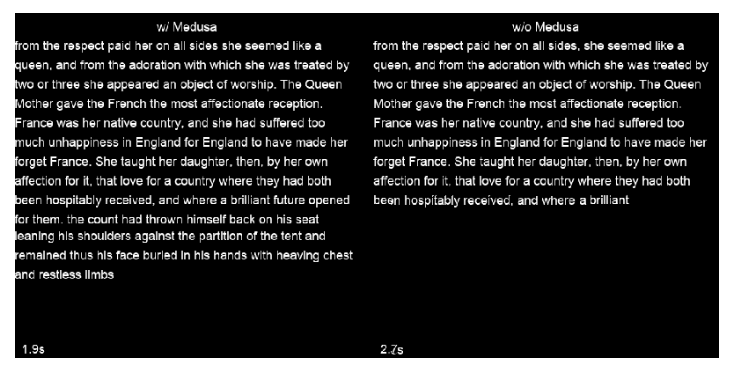

La société a modifié l'architecture de Whisper en ajoutant un mécanisme d'attention multi-têtes, permettant de prédire 10 jetons à la fois, ce qui améliore la vitesse de 50 % sans compromettre la précision. Ce modèle a été entraîné à l'aide d'une méthode d'apprentissage automatique faiblement supervisée, et des versions encore plus performantes sont à venir. Plus important encore, étant donné que le réseau de base de Whisper-Medusa est basé sur Whisper, l'augmentation de la vitesse ne se fait pas au détriment des performances.

Lors de l'entraînement de Whisper-Medusa, aiOla a utilisé une méthode d'apprentissage automatique dite faiblement supervisée. Dans le cadre de ce processus, les composants principaux de Whisper ont été figés, et le modèle a utilisé les transcriptions audio générées par le modèle comme étiquettes pour entraîner le module de prédiction de jetons supplémentaire.

Interrogé sur la question de savoir si des entreprises avaient eu accès à Whisper-Medusa en avant-première, Hetz a déclaré qu'il avait été testé sur des cas d'utilisation de données d'entreprises réelles et qu'il fonctionnait avec précision dans des scénarios réels, permettant aux applications vocales d'être plus réactives à l'avenir. En fin de compte, il estime que l'amélioration de la vitesse de reconnaissance et de transcription permettra de réduire les délais de traitement des applications vocales et ouvrira la voie à des réponses en temps réel.

Points clés :

💥 50 % plus rapide : Whisper-Medusa d'aiOla est considérablement plus rapide que le modèle de reconnaissance vocale Whisper d'OpenAI.

🎯 Précision préservée : L'augmentation de la vitesse est obtenue sans perte de précision par rapport au modèle d'origine.

📈 Fort potentiel : Promesse d'applications vocales plus rapides, plus efficaces et moins coûteuses.