Dans le monde de l'intelligence artificielle, il existe une catégorie particulière de « peintres » : les structures hiérarchiques des modèles Transformer. Ils fonctionnent comme des pinceaux magiques, peignant un monde riche et varié sur la toile du langage. Récemment, un article intitulé « Transformer Layers as Painters » a offert un nouveau point de vue sur le fonctionnement des couches intermédiaires des Transformer.

Les modèles Transformer, les modèles linguistiques les plus populaires actuellement, possèdent des milliards de paramètres. Chaque couche fonctionne comme un peintre, contribuant à la création d'une vaste tapisserie linguistique. Mais comment ces « peintres » collaborent-ils ? Quels sont leurs « pinceaux » et leurs « peintures » ? L'article tente de répondre à ces questions.

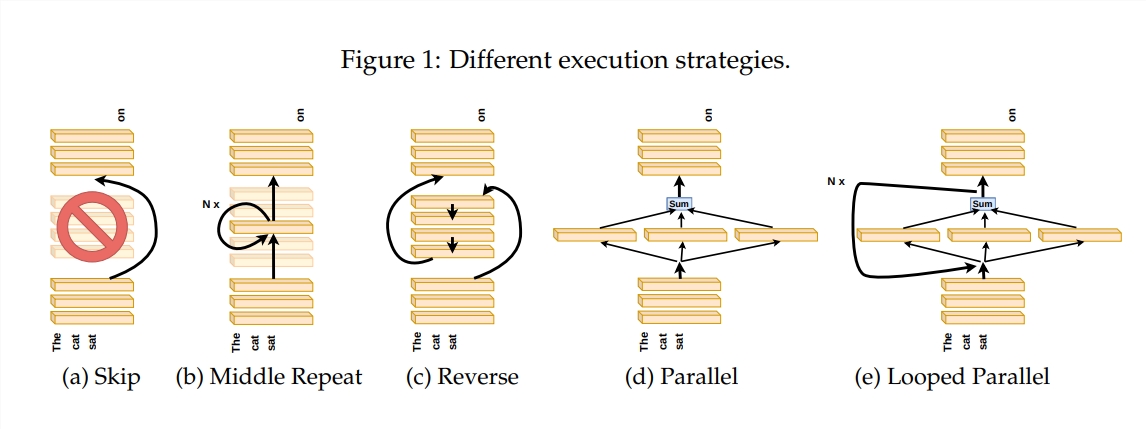

Pour explorer le fonctionnement des couches Transformer, les auteurs ont conçu une série d'expériences, notamment le saut de certaines couches, le changement de l'ordre des couches ou leur exécution parallèle. Ces expériences consistent à imposer différentes règles de peinture aux « peintres » pour voir s'ils peuvent s'adapter.

Dans la métaphore de la « chaîne de peinture », l'entrée est considérée comme une toile, et le processus des couches intermédiaires est comme le passage de la toile sur une chaîne de montage. Chaque « peintre », c'est-à-dire chaque couche du Transformer, modifie l'œuvre en fonction de ses compétences. Cette analogie permet de comprendre le parallélisme et la flexibilité des couches Transformer.

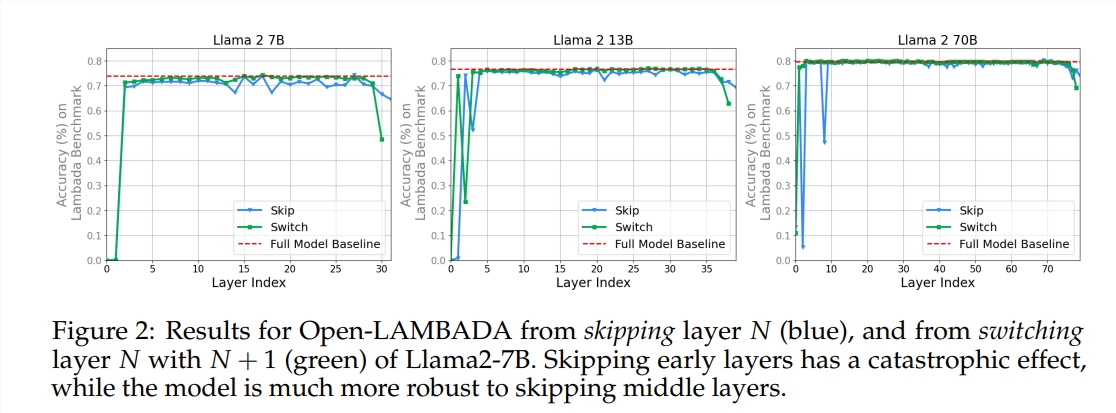

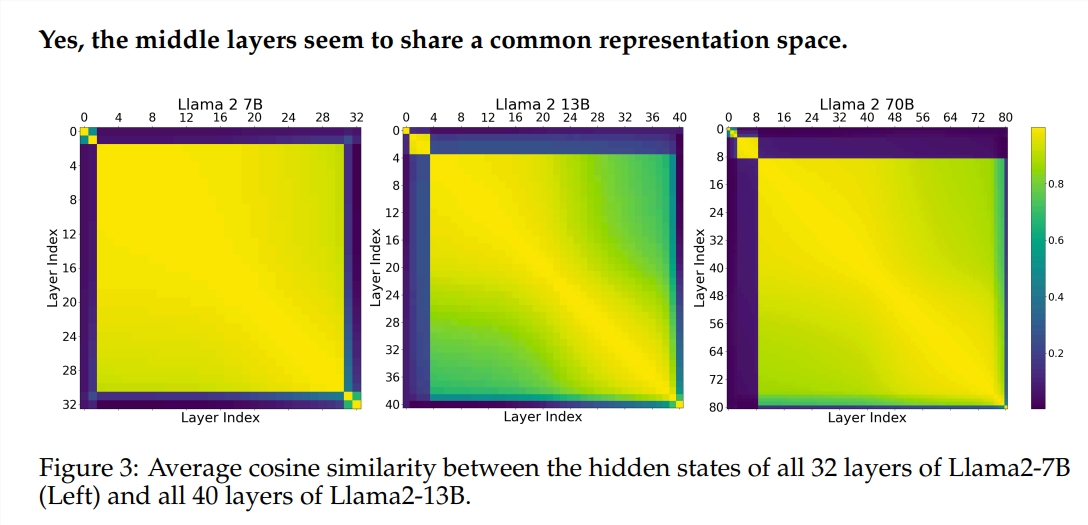

L'expérience a utilisé deux grands modèles linguistiques (LLM) pré-entraînés : Llama2-7B et BERT. Les recherches ont révélé que les « peintres » des couches intermédiaires semblent partager une « palette » commune – l'espace de représentation – différente de celle des couches initiale et finale. Sauter certains « peintres » des couches intermédiaires n'a pas d'impact significatif sur l'œuvre complète, ce qui indique que tous les « peintres » ne sont pas indispensables.

Bien que les « peintres » des couches intermédiaires utilisent la même « palette », ils utilisent leurs propres techniques pour créer des motifs différents sur la toile. La simple répétition des techniques d'un « peintre » particulier rendrait l'œuvre moins attrayante.

Pour les tâches mathématiques et de raisonnement nécessitant une logique rigoureuse, l'ordre de « peinture » est particulièrement important. Pour les tâches reposant sur la compréhension sémantique, l'impact de l'ordre est relativement faible.

Les résultats montrent que les couches intermédiaires des Transformer présentent un certain degré de cohérence, mais ne sont pas redondantes. Pour les tâches mathématiques et de raisonnement, l'ordre des couches est plus important que pour les tâches sémantiques.

L'étude a également révélé que toutes les couches ne sont pas nécessaires, et que les couches intermédiaires peuvent être sautées sans affecter de manière catastrophique les performances du modèle. De plus, bien que les couches intermédiaires partagent le même espace de représentation, elles remplissent des fonctions différentes. Modifier l'ordre d'exécution des couches entraîne une baisse des performances, ce qui montre que l'ordre a un impact important sur les performances du modèle.

De nombreux chercheurs tentent d'optimiser les modèles Transformer, notamment par l'élagage et la réduction du nombre de paramètres. Ces travaux offrent des enseignements précieux pour la compréhension des modèles Transformer.

Adresse de l'article : https://arxiv.org/pdf/2407.09298v1