Dans un monde numérique dominé par les données et les algorithmes, chaque avancée de l'intelligence artificielle repose sur un élément clé : le point de contrôle (Checkpoint). Imaginez que vous entraîniez un grand modèle linguistique capable de comprendre les émotions humaines et de répondre de manière fluide. Ce modèle est extrêmement intelligent, mais aussi très gourmand en ressources ; il nécessite une énorme puissance de calcul pour fonctionner. Si une coupure de courant ou une panne matérielle se produit pendant l'entraînement, les pertes seraient considérables. Le point de contrôle, dans ce cas, agit comme une « machine à remonter le temps », permettant de revenir à un état sûr précédent et de poursuivre la tâche inachevée.

Cependant, cette « machine à remonter le temps » nécessite une conception minutieuse. Des scientifiques de ByteDance et de l'Université de Hong Kong, dans leur article « ByteCheckpoint : A Unified Checkpointing System for LLM Development », nous présentent un système de points de contrôle révolutionnaire : ByteCheckpoint. Il ne s'agit pas simplement d'un outil de sauvegarde, mais d'un véritable atout pour améliorer considérablement l'efficacité de l'entraînement des grands modèles linguistiques.

Tout d’abord, il est nécessaire de comprendre les défis auxquels sont confrontés les grands modèles linguistiques (LLM). Ces modèles sont « grands » car ils doivent traiter et mémoriser une quantité massive d'informations, ce qui entraîne des coûts d'entraînement élevés, une consommation importante de ressources et une faible tolérance aux pannes. En cas de défaillance, cela peut entraîner une perte de temps considérable et compromettre le travail effectué.

Le système de points de contrôle est comme une « capture d'écran » du modèle, qui enregistre régulièrement son état pendant l'entraînement. Ainsi, en cas de problème, il est possible de restaurer rapidement l'état le plus récent et de minimiser les pertes. Cependant, les systèmes de points de contrôle existants, lorsqu'ils traitent des modèles de grande taille, sont souvent inefficaces en raison des goulots d'étranglement liés aux E/S (entrées/sorties).

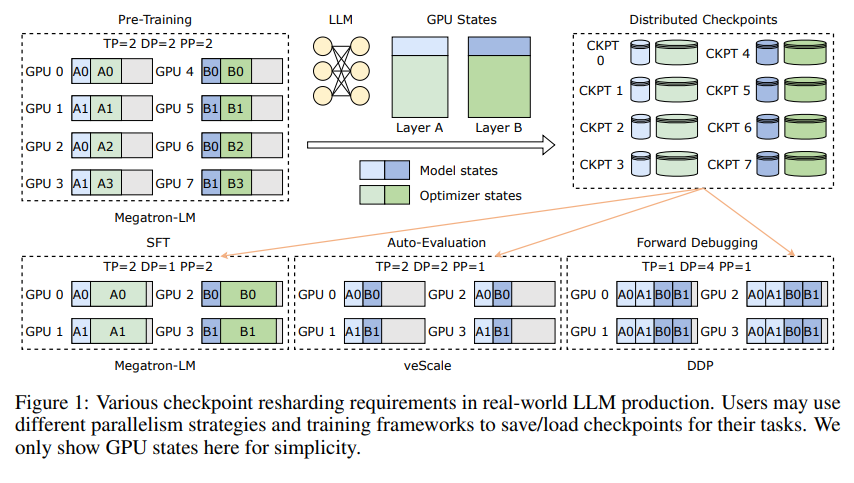

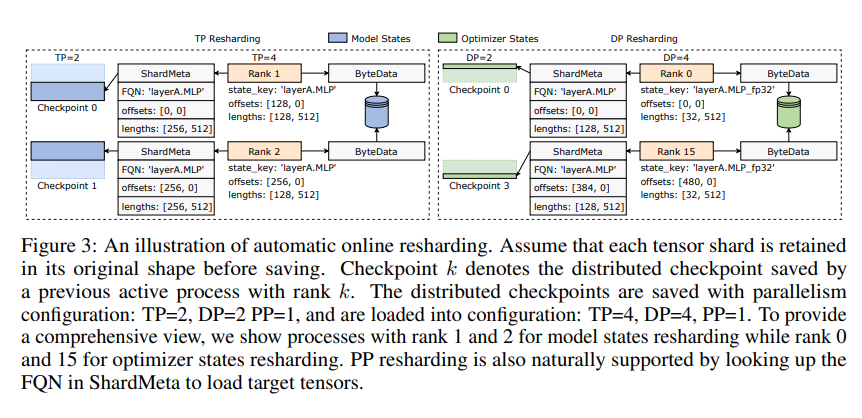

L'innovation de ByteCheckpoint réside dans son architecture de stockage novatrice, qui sépare les données et les métadonnées, permettant une gestion plus flexible des points de contrôle dans différentes configurations parallèles et différents frameworks d'entraînement. De plus, il prend en charge le repartitionnement automatique des points de contrôle en ligne, ce qui permet d'ajuster dynamiquement les points de contrôle pour s'adapter à différents environnements matériels sans interrompre l'entraînement.

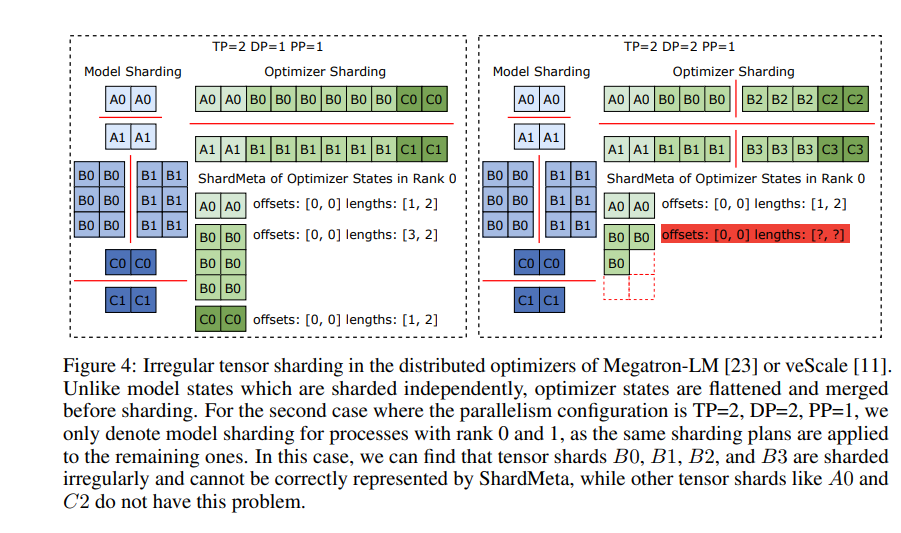

ByteCheckpoint introduit également une technologie clé : la fusion asynchrone des tenseurs. Cela permet de traiter efficacement les tenseurs distribués inégalement sur différents GPU, garantissant l'intégrité et la cohérence du modèle lors du repartitionnement des points de contrôle.

Pour améliorer la vitesse de sauvegarde et de chargement des points de contrôle, ByteCheckpoint intègre également une série de mesures d'optimisation des performances d'E/S, telles qu'un pipeline de sauvegarde/chargement précis, un pool de mémoire Ping-Pong, une sauvegarde équilibrée de la charge de travail et un chargement sans redondance, réduisant ainsi considérablement les temps d'attente pendant l'entraînement.

Des tests ont montré que, comparé aux méthodes traditionnelles, ByteCheckpoint améliore la vitesse de sauvegarde et de chargement des points de contrôle de dizaines, voire de centaines de fois, améliorant ainsi considérablement l'efficacité de l'entraînement des grands modèles linguistiques.

ByteCheckpoint n'est pas seulement un système de points de contrôle, mais aussi un assistant précieux pour l'entraînement des grands modèles linguistiques, une clé pour une formation IA plus efficace et plus stable.

Adresse de l'article : https://arxiv.org/pdf/2407.20143