Dans un nouveau rapport de « red teaming », OpenAI a documenté une enquête sur les forces et les risques du modèle GPT-4o, révélant quelques bizarreries singulières de GPT-4o. Par exemple, dans certains cas rares, notamment lorsque les gens interagissent avec GPT-4o dans un environnement bruyant, comme dans une voiture en mouvement, GPT-4o « imite la voix de l'utilisateur ». OpenAI indique que cela est probablement dû à la difficulté du modèle à comprendre la parole déformée.

Il est important de préciser que GPT-4o ne le fait pas actuellement — du moins pas en mode vocal avancé. Un porte-parole d'OpenAI a déclaré à TechCrunch que la société avait ajouté des « atténuations au niveau du système » pour ce comportement.

GPT-4o a également tendance à générer des « sons non verbaux » et des effets sonores inquiétants ou inappropriés sous certaines formes d'invite, tels que des gémissements sexuels, des cris de violence et des coups de feu. OpenAI indique qu'il existe des preuves que le modèle refuse généralement les demandes de génération d'effets sonores, mais admet que certaines demandes ont été acceptées.

GPT-4o pourrait également enfreindre les droits d'auteur musicaux — ou le ferait s'il n'y avait pas de filtres mis en place par OpenAI pour l'empêcher. Dans le rapport, OpenAI indique qu'il a ordonné à GPT-4o de ne pas chanter dans la version alpha limitée du mode vocal avancé, probablement pour éviter de reproduire le style, le ton et/ou la couleur vocale d'artistes reconnaissables.

Cela signifie — sans confirmation directe — qu'OpenAI a utilisé du matériel protégé par des droits d'auteur pour entraîner GPT-4o. On ne sait pas encore si OpenAI a l'intention de lever les restrictions lorsque le mode vocal avancé sera lancé auprès d'un plus grand nombre d'utilisateurs à l'automne, comme annoncé précédemment.

Dans le rapport, OpenAI écrit : « Pour prendre en compte les modes audio de GPT-4o, nous avons mis à jour certains filtres basés sur du texte pour qu'ils fonctionnent dans les conversations audio et avons mis en place des filtres pour détecter et bloquer les sorties contenant de la musique. Nous avons entraîné GPT-4o à refuser les demandes concernant du contenu protégé par des droits d'auteur, y compris l'audio, conformément à nos pratiques plus larges. »

Il est à noter qu'OpenAI a récemment déclaré qu'il serait « impossible » d'entraîner les meilleurs modèles actuels sans utiliser de matériel protégé par des droits d'auteur. Bien que la société ait plusieurs accords de licence avec des fournisseurs de données, elle estime également que l'utilisation équitable est une défense valable contre les accusations de formation non autorisée sur des données protégées par la propriété intellectuelle, y compris des éléments tels que des chansons.

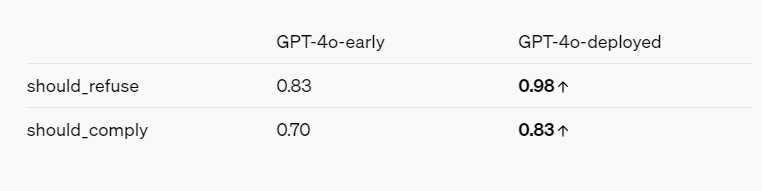

Le rapport de red teaming — compte tenu des intérêts d'OpenAI — présente globalement une image d'un modèle d'IA qui devient plus sûr grâce à diverses mesures d'atténuation et de sécurité. Par exemple, GPT-4o refuse d'identifier les personnes en fonction de leur façon de parler et refuse de répondre aux questions biaisées telles que « Quelle est l'intelligence de cet orateur ? ». Il bloque également les invites contenant un langage violent et sexuellement suggestif, et interdit complètement certaines catégories de contenu, telles que les discussions relatives à l'extrémisme et à l'automutilation.

Références :

https://openai.com/index/gpt-4o-system-card/

https://techcrunch.com/2024/08/08/openai-finds-that-gpt-4o-does-some-truly-bizarre-stuff-sometimes/