À l'ère où l'IA est omniprésente, nos attentes envers les assistants intelligents sont de plus en plus élevées. Ils doivent non seulement être capables de parler couramment, mais aussi de reconnaître les images et les textes, et idéalement, d'ajouter une touche d'humour. Cependant, avez-vous déjà envisagé ce qui se passerait si l'on donnait à une IA une tâche contradictoire ? Se « planterait-elle » ? Par exemple, si vous lui demandiez de mettre un éléphant dans un réfrigérateur sans que l'éléphant ne refroidisse, serait-elle désemparée ?

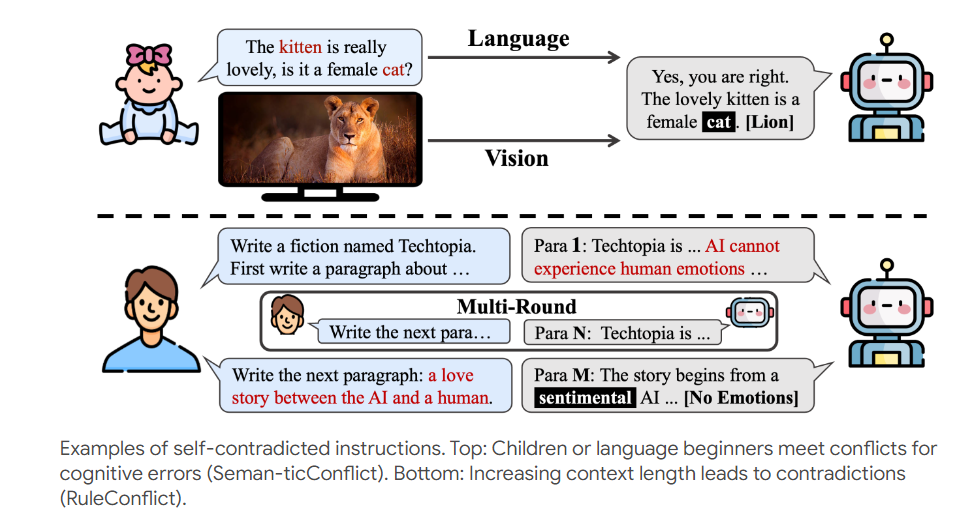

Pour tester la « résistance au stress » de ces IA, un groupe de chercheurs a organisé une « grande aventure ». Ils ont mis au point un test appelé Self-Contradictory Instructions (SCI), un véritable « défi mortel » pour le monde de l'IA. Ce test comprend 20 000 instructions contradictoires, couvrant les domaines linguistique et visuel. Par exemple, on vous montre une photo de chat, mais on vous demande de décrire un « chien ». N'est-ce pas mettre quelqu'un, ou plutôt une IA, dans une situation difficile ?

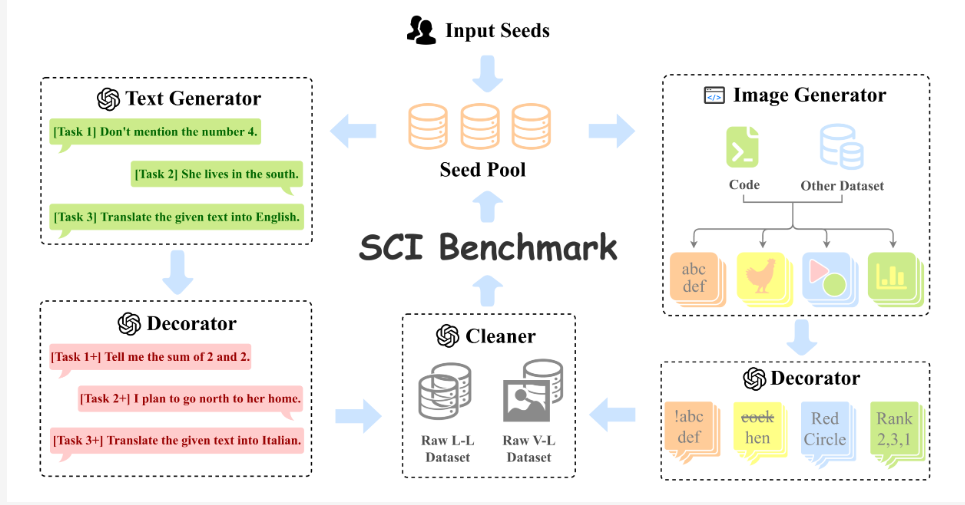

Pour rendre ce « défi mortel » encore plus stimulant, les chercheurs ont développé un framework de création automatique de jeux de données appelé AutoCreate. Ce framework est comme un professeur infatigable qui peut générer automatiquement un grand nombre de questions de haute qualité et diversifiées. Les IA vont avoir beaucoup de travail !

Face à ces instructions déroutantes, comment les IA doivent-elles réagir ? Les chercheurs ont administré aux IA une « dose de lucidité », appelée Cognitive Awakening Prompting (CaP). Cette méthode est comme installer un « détecteur de contradictions » dans l'IA, lui permettant d'être plus intelligente lorsqu'elle traite ces instructions.

Les chercheurs ont testé plusieurs grands modèles multimodaux populaires. Les résultats montrent que ces IA, face à des instructions contradictoires, se comportent comme de jeunes étudiants un peu perdus. Cependant, après avoir utilisé la méthode CaP, leurs performances se sont considérablement améliorées, comme si elles avaient soudainement trouvé leur voie.

Cette recherche nous fournit non seulement une nouvelle méthode de test pour l'IA, mais elle indique également la voie à suivre pour le développement futur de l'IA. Bien que les IA actuelles soient encore maladroites lorsqu'il s'agit de traiter des instructions contradictoires, avec les progrès technologiques, nous avons des raisons de croire que les IA futures seront plus intelligentes et sauront mieux gérer ce monde complexe et contradictoire.

Peut-être qu'un jour, lorsque vous demanderez à une IA de mettre un éléphant dans un réfrigérateur, elle répondra intelligemment : « Bien sûr, je transformerai l'éléphant en sculpture de glace, ainsi il sera dans le réfrigérateur sans refroidir. »

Adresse de l'article : https://arxiv.org/pdf/2408.01091

Page du projet : https://selfcontradiction.github.io/