Cosine, une start-up d'IA basée à San Francisco, a lancé un nouveau modèle d'IA appelé Genie, spécialement conçu pour aider les développeurs de logiciels. Selon la société, Genie a surperformé ses concurrents lors de tests de référence, démontrant des capacités exceptionnelles.

Cosine a collaboré avec OpenAI pour entraîner une variante de GPT-4o sur des données de haute qualité, obtenant des résultats remarquables lors des tests de référence. L'entreprise affirme que la clé du succès de Genie réside dans sa capacité de « raisonnement codé humain », une capacité qui pourrait ne pas se limiter au développement de logiciels.

Genie prend la tête dans le domaine du SWE

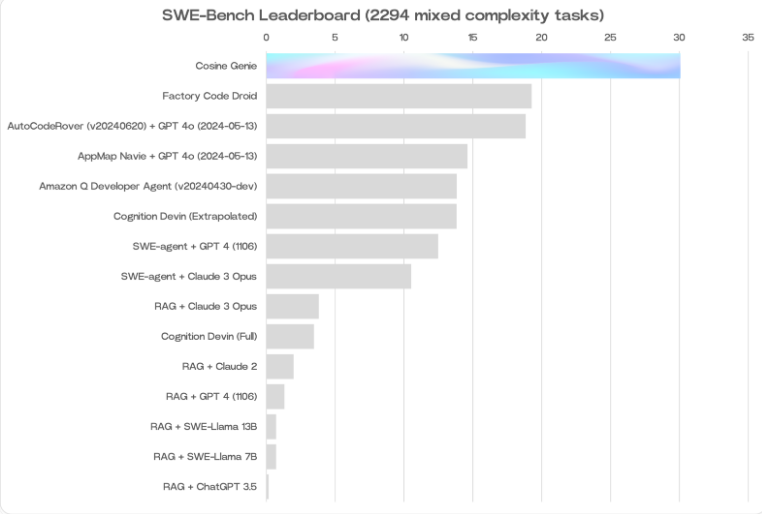

Alistair Pullen, co-fondateur et PDG de Cosine, a révélé que Genie a obtenu un score de 30 % au test SWE-Bench, le score le plus élevé jamais atteint par un modèle d'IA dans ce domaine. Ce résultat surpasse celui d'autres modèles linguistiques axés sur le codage, tels que le modèle d'Amazon (19 %) et Devin de Cognition (13,8 % sur une partie des tests SWE-Bench).

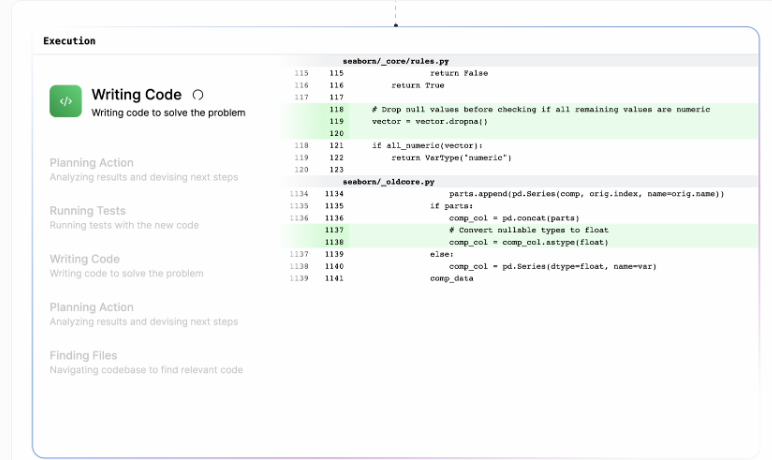

L'architecture de Genie est conçue pour simuler le processus cognitif des développeurs humains. Il est capable de corriger les erreurs, de développer de nouvelles fonctionnalités, de refactoriser le code et d'exécuter diverses tâches de programmation, de manière autonome ou collaborative.

Amélioration par les données synthétiques

Le développement de Genie a utilisé un processus propriétaire, entraînant et affinant une variante non publique de GPT-40 sur des milliards de données de haute qualité. Cosine a passé près d'un an à compiler ces données avec l'aide de développeurs expérimentés. L'ensemble de données comprend 21 % de JavaScript et Python, 14 % de TypeScript et TSX, et 3 % d'autres langages (dont Java, C++ et Ruby).

Les performances exceptionnelles de Genie sont en partie dues à son entraînement d'auto-amélioration. Initialement, le modèle apprenait principalement à partir de codes parfaits et efficaces, mais il était confus par le traitement de ses propres erreurs. Cosine a résolu ce problème en utilisant des données synthétiques : si la solution initialement proposée par Genie était incorrecte, le modèle voyait comment l'améliorer avec le résultat correct. À chaque itération, les solutions de Genie s'amélioraient progressivement, et le nombre de corrections nécessaires diminuait.

Surmonter les limites techniques

Pullen avait déjà perçu dès début 2022 le potentiel des grands modèles linguistiques pour soutenir le développement logiciel humain. Cependant, les technologies de l'époque n'étaient pas encore au niveau pour réaliser la vision de Genie. La capacité de marquage de la fenêtre contextuelle était généralement limitée à 4 000 jetons, un goulot d'étranglement majeur. Aujourd'hui, des modèles tels que Gemini 1.5 Pro peuvent traiter jusqu'à 2 millions de jetons dans une seule invite. Bien que Cosine n'ait pas encore révélé la capacité de marquage spécifique de Genie, cette avancée technologique a sans aucun doute fourni une base solide pour son succès.