À l'ère de l'explosion d'informations, nous utilisons quotidiennement des images et des vidéos pour documenter notre vie et partager notre bonheur. Mais avez-vous déjà envisagé une technologie permettant aux machines de comprendre ces images et vidéos comme les humains, et d'interagir avec nous de manière approfondie ?

Le dernier modèle multimodal générique mPLUG-Owl3 de l'équipe Alibaba, grâce à son efficacité et à sa capacité de compréhension remarquables, nous permet de « regarder » un film de 2 heures en seulement 4 secondes ! Ce n'est pas qu'un simple modèle, c'est un assistant IA capable de voir, d'entendre, de parler et de réfléchir.

mPLUG-Owl3, un nom évoquant une chouette portant des lunettes, intelligent et vigilant. Sa capacité principale est la compréhension de longues séquences d'images. Que ce soit une série de photos ou une vidéo, il peut comprendre le contenu et même l'histoire.

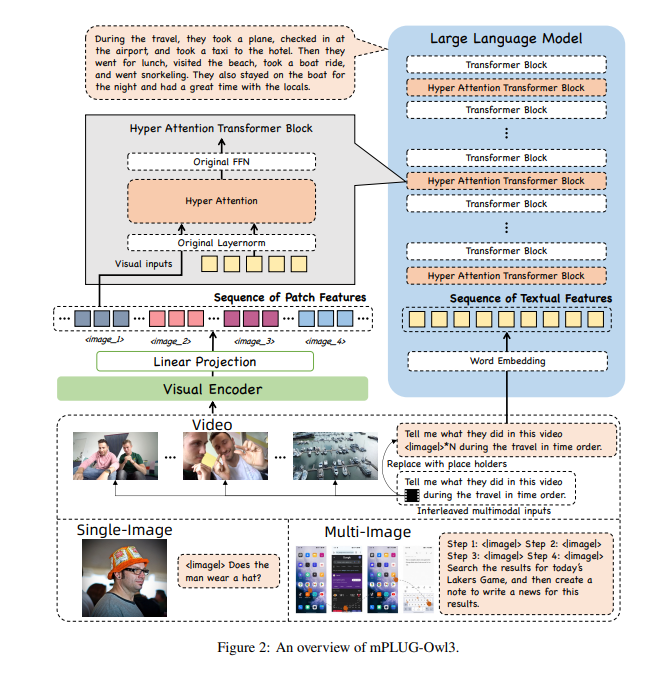

Pour permettre à mPLUG-Owl3 de traiter autant d'informations, les chercheurs lui ont intégré un « super cerveau » : un module d'attention extrême. Ce module est comme le super cerveau de l'IA, capable de traiter simultanément des informations visuelles et linguistiques, permettant à l'IA de comprendre les images et les textes associés.

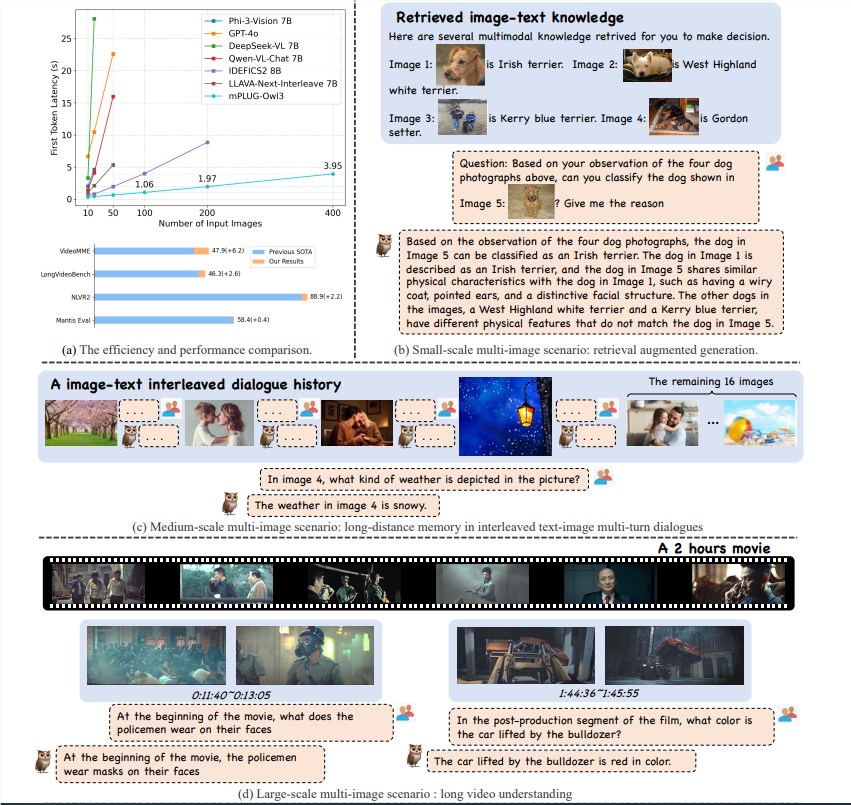

Le modèle mPLUG-Owl3, grâce à son excellente efficacité de raisonnement, a réalisé une percée majeure dans le domaine de la compréhension multimodale. Il a non seulement atteint le niveau SOTA (State of the Art) sur plusieurs benchmarks dans différents contextes (images uniques, multiples images, vidéos), mais il a également réduit de 6 fois la latence du premier jeton, et multiplié par 8 le nombre d'images pouvant être traitées par une seule carte graphique A100, atteignant 400 images.

mPLUG-Owl3 peut comprendre avec précision les connaissances multimodales entrantes et les utiliser pour répondre aux questions. Il peut même vous indiquer sur quelles connaissances il s'appuie pour ses jugements, ainsi que les justifications détaillées.

mPLUG-Owl3 peut comprendre correctement les relations entre les contenus de différents supports et effectuer des raisonnements approfondis. Que ce soit les différences de style ou la reconnaissance des personnages, il les gère facilement.

mPLUG-Owl3 peut visionner et comprendre des vidéos de 2 heures et commencer à répondre aux questions de l'utilisateur en 4 secondes, quelle que soit la partie de la vidéo concernée par la question.

mPLUG-Owl3 utilise un module Hyper Attention léger, qui étend le bloc Transformer pour créer un nouveau module capable d'interagir avec les caractéristiques textuelles et visuelles et de modéliser le texte. Cette conception réduit considérablement le nombre de nouveaux paramètres introduits, ce qui facilite l'entraînement du modèle et améliore son efficacité d'entraînement et d'inférence.

Lors d'expérimentations sur de vastes ensembles de données, mPLUG-Owl3 a obtenu des résultats SOTA sur la plupart des benchmarks multimodaux d'images uniques. Dans les évaluations d'images multiples, il a surpassé les modèles optimisés spécifiquement pour ce type de contexte. Sur LongVideoBench, il a également surpassé les modèles existants, démontrant ses capacités exceptionnelles en matière de compréhension de longues vidéos.

La publication d'Alibaba mPLUG-Owl3 représente non seulement un bond technologique, mais ouvre également de nouvelles possibilités pour les applications des grands modèles multimodaux. Avec l'amélioration constante de la technologie, nous attendons avec impatience que mPLUG-Owl3 nous réserve encore plus de surprises à l'avenir.

Adresse de l'article : https://arxiv.org/pdf/2408.04840

Code : https://github.com/X-PLUG/mPLUG-Owl/tree/main/mPLUG-Owl3

Expérience en ligne : https://huggingface.co/spaces/mPLUG/mPLUG-Owl3