Microsoft a annoncé le lancement de trois nouveaux modèles Phi-3.5, consolidant ainsi sa position de leader dans le développement de l'intelligence artificielle multilingue et multimodale. Ces trois nouveaux modèles sont : Phi-3.5-mini-instruct, Phi-3.5-MoE-instruct et Phi-3.5-vision-instruct, chacun étant conçu pour des scénarios d'application spécifiques.

Le modèle Phi-3.5-mini-instruct est un modèle d'IA léger, avec 380 millions de paramètres, idéal pour les environnements aux capacités de calcul limitées. Il prend en charge une longueur de contexte de 128 k et est spécialement optimisé pour l'exécution d'instructions, ce qui le rend adapté aux tâches telles que la génération de code, la résolution de problèmes mathématiques et le raisonnement logique. Malgré sa petite taille, ce modèle affiche une compétitivité remarquable dans les tâches multilingues et de dialogue multi-tours, surpassant d'autres modèles similaires.

Accès : https://huggingface.co/microsoft/Phi-3.5-mini-instruct

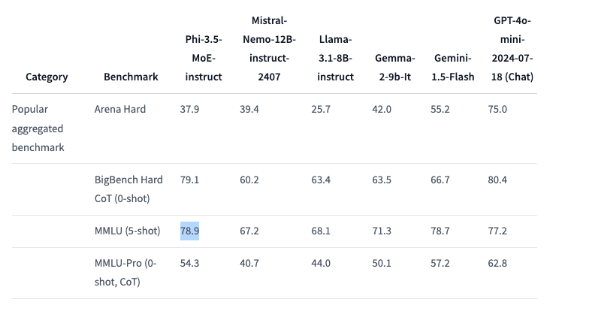

Le modèle Phi-3.5-MoE est un modèle « mélange d'experts », combinant plusieurs types de modèles, chacun se concentrant sur une tâche spécifique. Avec 41,9 milliards de paramètres et une prise en charge d'une longueur de contexte de 128 k, il offre des performances exceptionnelles dans diverses tâches de raisonnement. Ce modèle excelle dans le code, les mathématiques et la compréhension multilingue, surpassant même des modèles plus grands dans certains benchmarks, comme le MMLU (compréhension du langage multitâche à grande échelle) où il dépasse le GPT-4o mini d'OpenAI.

Accès : https://huggingface.co/microsoft/Phi-3.5-MoE-instruct

Le modèle Phi-3.5-vision-instruct est un modèle d'IA multimodale avancé intégrant le traitement du texte et des images. Il est adapté à des tâches telles que la compréhension d'images, la reconnaissance optique de caractères, l'analyse de graphiques et de tableaux, et la synthèse de vidéos. Ce modèle prend également en charge une longueur de contexte de 128 k et peut gérer des tâches visuelles complexes à plusieurs images.

Accès : https://huggingface.co/microsoft/Phi-3.5-vision-instruct

Pour entraîner ces trois modèles, Microsoft a effectué un traitement de données à grande échelle. Le modèle Mini-Instruct a utilisé 3,4 billions de jetons, entraîné pendant 10 jours sur 512 GPU H100-80G ; le modèle Vision-Instruct a utilisé 500 milliards de jetons, entraîné pendant 6 jours ; et le modèle MoE a utilisé 4,9 billions de jetons, entraîné pendant 23 jours.

Il est important de noter que les trois modèles Phi-3.5 sont publiés sous licence MIT open source, permettant aux développeurs d'utiliser, de modifier et de distribuer librement ces logiciels. Cela témoigne du soutien de Microsoft à la communauté open source et permet à un plus grand nombre de développeurs d'intégrer des capacités d'IA de pointe dans leurs applications.

Points clés :

🌟 Microsoft lance trois nouveaux modèles d'IA, destinés respectivement au raisonnement léger, aux experts mixtes et aux tâches multimodales.

📊 Phi-3.5-MoE surpasse GPT-4o mini dans les tests de référence, affichant des performances exceptionnelles.

📜 Les trois modèles sont publiés sous licence MIT open source, permettant aux développeurs de les utiliser et de les modifier librement.