Dans le domaine de l'intelligence artificielle, permettre aux machines de comprendre le monde physique complexe de la même manière que les humains représente un défi majeur. Récemment, une équipe de recherche composée de chercheurs de l'Université du Peuple chinois, de l'Université des postes et télécommunications de Beijing et du Shanghai AI Lab a proposé une technologie révolutionnaire : Ref-AVS, offrant une nouvelle perspective pour résoudre ce problème.

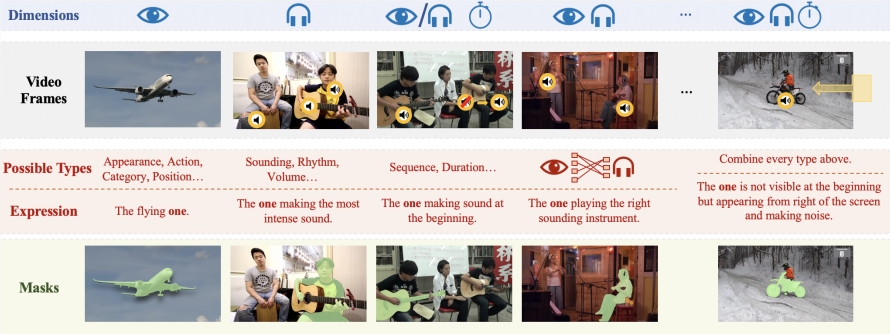

Le cœur de la technologie Ref-AVS réside dans sa méthode unique de fusion multimodale. Elle intègre intelligemment plusieurs types d'informations : la segmentation d'objets vidéo (VOS), la segmentation d'objets vidéo par référence (Ref-VOS) et la segmentation audiovisuelle (AVS). Cette fusion innovante permet au système d'IA non seulement de traiter les objets émettant un son, mais aussi d'identifier les objets importants du contexte qui ne produisent pas de son. Cette avancée permet à l'IA de comprendre plus précisément les instructions données par l'utilisateur en langage naturel et de localiser avec précision des objets spécifiques dans des scènes audiovisuelles complexes.

Pour soutenir la recherche et la validation de la technologie Ref-AVS, l'équipe de recherche a créé un ensemble de données à grande échelle appelé Ref-AVS Bench. Cet ensemble de données contient 40 020 images vidéo, couvrant 6 888 objets et 20 261 expressions référentielles. Chaque image vidéo est accompagnée d'annotations audio et pixelliques détaillées. Cet ensemble de données riche et diversifié fournit une base solide pour la recherche multimodale et ouvre de nouvelles perspectives pour les recherches futures dans ce domaine.

Au cours d'une série d'expériences quantitatives et qualitatives rigoureuses, la technologie Ref-AVS a démontré des performances exceptionnelles. En particulier sur le sous-ensemble Seen, Ref-AVS a surpassé les autres méthodes existantes, démontrant ainsi sa puissante capacité de segmentation. Plus remarquable encore, les résultats des tests sur les sous-ensembles Unseen et Null ont confirmé la remarquable capacité de généralisation de la technologie Ref-AVS et sa robustesse face aux références nulles, ce qui est crucial pour les applications réelles.

Le succès de la technologie Ref-AVS a non seulement suscité un vif intérêt dans le monde académique, mais a également ouvert de nouvelles voies pour les applications pratiques. On peut prévoir que cette technologie jouera un rôle important dans de nombreux domaines, tels que l'analyse vidéo, le traitement d'images médicales, la conduite autonome et la navigation robotique. Par exemple, dans le domaine médical, Ref-AVS pourrait aider les médecins à interpréter plus précisément des images médicales complexes ; dans le domaine de la conduite autonome, elle pourrait améliorer la capacité des véhicules à percevoir leur environnement ; et en robotique, elle pourrait permettre aux robots de mieux comprendre et d'exécuter les instructions verbales des humains.

Les résultats de cette recherche ont été présentés à l'ECCV2024, et l'article et les informations sur le projet sont désormais accessibles au public, offrant aux chercheurs et développeurs du monde entier intéressés par ce domaine de précieuses ressources d'apprentissage et d'exploration. Cette approche d'ouverture et de partage reflète non seulement l'esprit scientifique des équipes de recherche chinoises, mais stimulera également le développement rapide de l'ensemble du domaine de l'IA.

L'apparition de la technologie Ref-AVS marque une avancée significative dans la compréhension multimodale de l'intelligence artificielle. Elle démontre non seulement les capacités d'innovation des équipes de recherche chinoises dans le domaine de l'IA, mais dessine également un tableau plus intelligent et plus naturel de l'avenir de l'interaction homme-machine. Avec l'amélioration et l'application continue de cette technologie, nous pouvons raisonnablement espérer que les systèmes d'IA futurs comprendront et s'adapteront mieux au monde complexe des humains, apportant des changements révolutionnaires à tous les secteurs d'activité.

Adresse de l'article : https://arxiv.org/abs/2407.10957

Page du projet : https://gewu-lab.github.io/Ref-AVS/