Récemment, une équipe de recherche de NVIDIA, en collaboration avec le Georgia Tech, l'UMD et le HKPU, a lancé un nouveau modèle de langage visuel : NVEagle. Il peut comprendre les images et discuter avec vous, ce qui en fait un super assistant capable de voir et de parler.

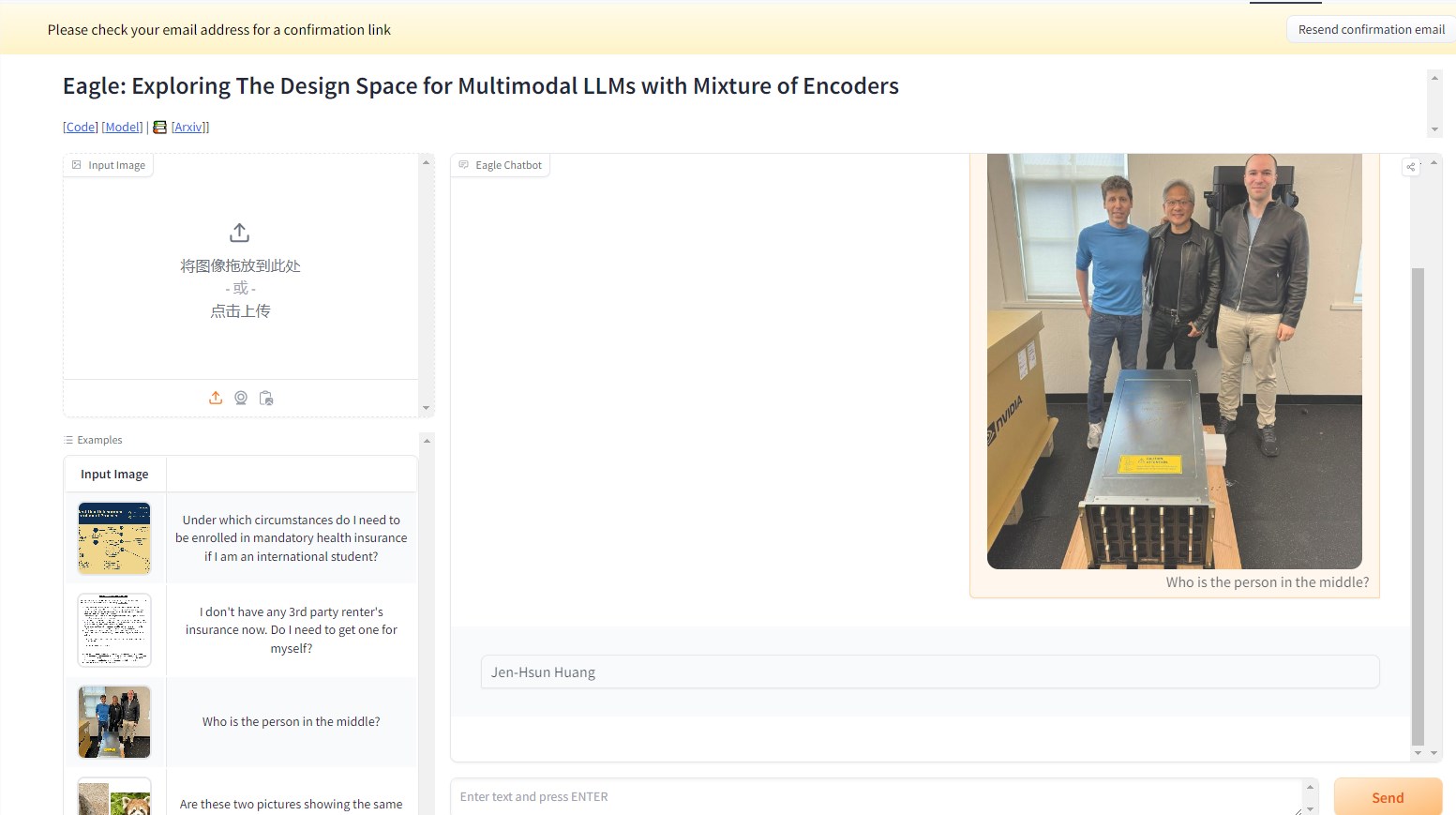

Par exemple, dans l’illustration ci-dessous, en demandant à NVEagle qui est la personne sur l’image, le modèle interprète l’image et répond : Jensen Huang. Une réponse très précise.

Ce grand modèle linguistique multi-modal (MLLM) représente une avancée significative dans la combinaison d’informations visuelles et linguistiques. NVEagle est capable de comprendre des scènes réelles complexes et de fournir des interprétations et des réponses plus pertinentes grâce aux entrées visuelles. Son principe de conception repose sur la conversion des images en marqueurs visuels, combinés ensuite à des intégrations textuelles, améliorant ainsi la compréhension des informations visuelles.

Cependant, la construction d’un modèle aussi puissant présente de nombreux défis, notamment en ce qui concerne l’amélioration des capacités de perception visuelle. Des études montrent que de nombreux modèles existants souffrent d’« hallucinations » lors du traitement d’images haute résolution, c’est-à-dire qu’ils génèrent des sorties inexactes ou dénuées de sens. Ceci est particulièrement visible dans les tâches nécessitant une analyse détaillée, telles que la reconnaissance optique de caractères (ROC) et la compréhension de documents. Pour surmonter ces difficultés, l’équipe de recherche a exploré diverses méthodes, notamment en testant différents encodeurs visuels et stratégies de fusion.

NVEagle est le fruit de ces recherches et se décline en trois versions : Eagle-X5-7B, Eagle-X5-13B et Eagle-X5-13B-Chat. Les versions 7B et 13B sont principalement utilisées pour les tâches de langage visuel générales, tandis que la version 13B-Chat est spécialement optimisée pour l’IA conversationnelle et permet des interactions plus fluides basées sur des entrées visuelles.

L’un des points forts de NVEagle est l’utilisation d’un mécanisme d’expert mixte (MoE), qui permet de sélectionner dynamiquement l’encodeur visuel le plus adapté à chaque tâche, améliorant ainsi considérablement le traitement des informations visuelles complexes. Ce modèle est disponible sur Hugging Face, facilitant son utilisation par les chercheurs et les développeurs.

Lors de divers tests de référence, le modèle Eagle a démontré des performances exceptionnelles. Par exemple, pour la tâche de ROC, le modèle Eagle a obtenu une note moyenne de 85,9 sur OCRBench, surpassant d’autres modèles de pointe tels qu’InternVL et LLaVA-HR. Dans les tests TextVQA, il a obtenu un score de 88,8, affichant également de bonnes performances dans les tâches complexes de questions-réponses visuelles, avec un score de 65,7 au test GQA. De plus, les performances continuent de s’améliorer avec l’ajout d’experts visuels supplémentaires.

La série de modèles NVEagle, grâce à une exploration et une optimisation systématiques, a réussi à résoudre plusieurs défis clés de la perception visuelle, ouvrant de nouvelles perspectives pour le développement des modèles de langage visuel.

Accès au projet : https://top.aibase.com/tool/eagle

Démo : https://huggingface.co/spaces/NVEagle/Eagle-X5-13B-Chat

Points clés :

🌟 NVEagle est un modèle de langage visuel de nouvelle génération développé par NVIDIA, visant à améliorer la compréhension des informations visuelles complexes.

📈 Le modèle comprend trois versions adaptées à différentes tâches, la version 13B-Chat étant spécialement conçue pour l’IA conversationnelle.

🏆 Dans plusieurs tests de référence, le modèle Eagle a surpassé de nombreux modèles de pointe existants, démontrant des performances exceptionnelles.