Récemment, OpenAI a lancé son modèle d'IA très attendu, auparavant connu sous le nom de code « fraise », et officiellement baptisé « o1-preview ».

OpenAI affirme que ce nouveau modèle surpasse les doctorants sur des tâches de référence complexes en physique, chimie et biologie. Cependant, les premiers tests montrent que cet IA est encore loin de remplacer les scientifiques ou les programmeurs humains.

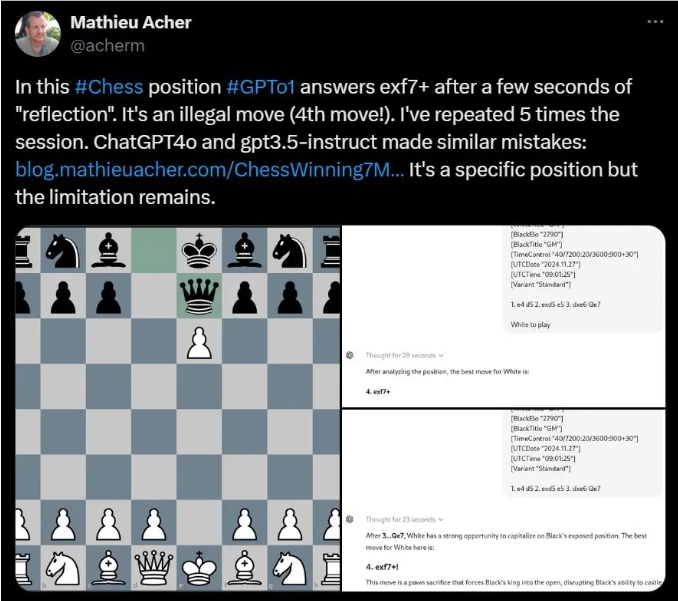

Sur les réseaux sociaux, de nombreux utilisateurs ont partagé leurs interactions avec l'IA « OpenAI o1 », révélant des performances médiocres sur des tâches basiques.

Par exemple, Mathieu Acher, chercheur à l'INSA Rennes, a constaté qu'OpenAI o1 proposait fréquemment des coups illégaux lors de la résolution de certains casse-têtes d'échecs.

De son côté, Colin Fraser, scientifique chez Meta AI, a souligné que face à une énigme simple consistant à faire traverser une rivière à un fermier et à ses moutons, l'IA a abandonné la bonne réponse pour fournir des réponses absurdes et dénuées de logique.

Même sur les énigmes logiques utilisées par OpenAI pour la démonstration, impliquant des fraises, les utilisateurs ont obtenu des réponses différentes. Un utilisateur a constaté un taux d'erreur de 75 % du modèle.

Plus surprenant encore, certains utilisateurs ont signalé que le nouveau modèle commettait des erreurs même pour compter le nombre de fois que la lettre « R » apparaît dans le mot « strawberry ».

Bien qu'OpenAI ait précisé lors de son lancement qu'il s'agissait d'un modèle préliminaire, dépourvu de fonctionnalités telles que la navigation web ou le téléchargement de fichiers, de telles erreurs élémentaires sont surprenantes.

Pour l'améliorer, OpenAI a introduit le processus de « chaîne de pensée » dans le nouveau modèle, ce qui différencie OpenAI o1 du modèle GPT-4o précédent. Cette méthode permet à l'IA de réfléchir à plusieurs reprises avant de fournir une réponse, ce qui allonge son temps de réponse.

Un utilisateur a constaté que le modèle a mis 92 secondes à répondre à une énigme textuelle, mais la réponse était toujours incorrecte.

Noam Brown, chercheur scientifique chez OpenAI, a déclaré que malgré la lenteur actuelle, ils espèrent que les versions futures pourront réfléchir plus longtemps et même apporter de nouvelles perspectives sur des problèmes révolutionnaires.

Cependant, Gary Marcus, célèbre critique de l'IA, se montre sceptique, estimant qu'un temps de traitement plus long ne garantit pas une capacité de raisonnement supérieure. Il souligne que malgré les progrès de l'IA, la recherche et l'expérimentation réelles restent indispensables.

En conclusion, les performances de ce nouveau modèle d'IA d'OpenAI sont décevantes en pratique, ce qui a suscité un débat sur l'avenir du développement de l'IA.

Points clés :

🌟 OpenAI a récemment lancé le nouveau modèle d'IA « fraise », prétendant qu'il rivalise avec les doctorants sur des tâches complexes.

🤖 De nombreux utilisateurs ont constaté que cette IA commettait fréquemment des erreurs sur des tâches basiques, telles que proposer des coups illégaux aux échecs et répondre incorrectement à des énigmes simples.

💬 OpenAI admet que le modèle est encore en développement, mais un temps de réflexion plus long n'améliore pas forcément la capacité de raisonnement, et de nombreux problèmes fondamentaux restent non résolus.