L'équipe de Tongyi Qianwen a annoncé la sortie en open source de la nouvelle série de modèles linguistiques Qwen2.5, trois mois après la sortie de Qwen2. Il s'agit probablement de l'une des plus importantes publications en open source de l'histoire, incluant le modèle linguistique général Qwen2.5, ainsi que les modèles Qwen2.5-Coder et Qwen2.5-Math, spécifiquement conçus pour la programmation et les mathématiques.

La série de modèles Qwen2.5 a été pré-entraînée sur un ensemble de données massif contenant jusqu'à 18 T de jetons. Par rapport à Qwen2, les nouveaux modèles présentent des améliorations significatives en termes d'acquisition de connaissances, de capacités de programmation et de capacités mathématiques. Les modèles prennent en charge le traitement de longs textes, pouvant générer jusqu'à 8 000 jetons, tout en conservant la prise en charge de plus de 29 langues.

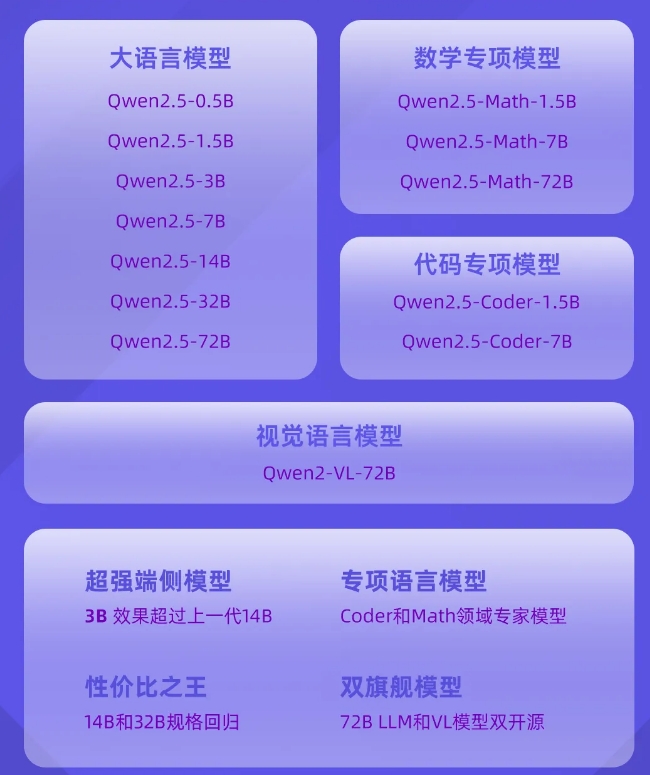

La publication en open source de la série de modèles Qwen2.5 utilise la licence Apache 2.0 et propose des versions de différentes tailles pour répondre aux différents besoins des applications. De plus, l'équipe Tongyi Qianwen a également publié en open source le modèle Qwen2-VL-72B, dont les performances sont comparables à celles de GPT-4.

Les nouveaux modèles présentent des améliorations significatives dans l'exécution d'instructions, la génération de longs textes, la compréhension des données structurées et la génération de sorties structurées. En particulier dans les domaines de la programmation et des mathématiques, les modèles Qwen2.5-Coder et Qwen2.5-Math, entraînés sur des ensembles de données spécialisés, affichent des capacités plus fortes dans ces domaines.

Expérience des modèles de la série Qwen2.5 :

Ensemble Qwen2.5 : https://modelscope.cn/studios/qwen/Qwen2.5