L'Institut de recherche sur l'intelligence artificielle (BAAI) a lancé Infinity-Instruct, un ensemble de données d'instructions de plusieurs millions d'éléments visant à améliorer les performances des modèles linguistiques, notamment dans le domaine du dialogue. Récemment, Infinity-Instruct a subi une nouvelle itération, comprenant l'ensemble de données d'instructions de base Infinity-Instruct-7M et l'ensemble de données d'instructions de dialogue Infinity-Instruct-Gen.

L'ensemble de données d'instructions de base Infinity-Instruct-7M contient plus de 7,44 millions d'éléments couvrant des domaines tels que les mathématiques, le code et les questions-réponses basées sur le bon sens, dans le but d'améliorer les capacités de base des modèles pré-entraînés. Les résultats des tests montrent que les modèles Llama3.1-70B et Mistral-7B-v0.1, affinés à l'aide de cet ensemble de données, se rapprochent des modèles de dialogue officiellement publiés en termes de capacités globales. Mistral-7B surpasse même GPT-3.5, tandis que Llama3.1-70B se rapproche de GPT-4.

L'ensemble de données d'instructions de dialogue Infinity-Instruct-Gen contient quant à lui 1,49 million d'instructions complexes synthétiques, visant à améliorer la robustesse des modèles dans des scénarios de dialogue réels. Après un affinage supplémentaire à l'aide de cet ensemble de données, les performances des modèles peuvent surpasser celles des modèles de dialogue officiels.

L'Institut de recherche sur l'intelligence artificielle a testé Infinity-Instruct sur les classements d'évaluation principaux tels que MTBench, AlpacaEval2 et Arena-Hard. Les résultats montrent que les modèles affinés avec Infinity-Instruct surpassent les modèles officiels en termes de capacités de dialogue.

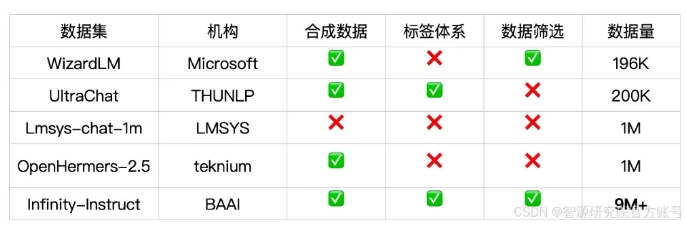

Infinity-Instruct fournit des annotations détaillées pour chaque donnée d'instruction, telles que la langue, le type de capacité, le type de tâche et la source des données, permettant aux utilisateurs de filtrer les sous-ensembles de données en fonction de leurs besoins. L'Institut de recherche sur l'intelligence artificielle a construit un ensemble de données de haute qualité grâce à la sélection de données et à la synthèse d'instructions, afin de combler l'écart entre les modèles de dialogue open source et GPT-4.

Le projet utilise également le framework d'entraînement FlagScale pour réduire les coûts d'affinage, et utilise la suppression de doublons MinHash et la recherche BGE pour éliminer les échantillons en double. Le BAAI prévoit de rendre public le code du processus complet de traitement des données et d'entraînement des modèles à l'avenir, et d'explorer l'extension de la stratégie de données Infinity-Instruct aux phases d'alignement et de pré-entraînement, afin de soutenir les besoins en données du cycle de vie complet des modèles linguistiques.

Lien vers l'ensemble de données :

https://modelscope.cn/datasets/BAAI/Infinity-Instruct