Dans le contexte actuel de la rapide évolution des technologies de synthèse vocale, la falsification vocale est de plus en plus répandue, menaçant la vie privée des utilisateurs et la sécurité publique. Récemment, le laboratoire de sécurité des systèmes intelligents de l'Université de Zhejiang et l'Université Tsinghua ont conjointement publié un nouveau cadre de détection de la falsification vocale, baptisé « SafeEar ».

Ce cadre vise à réaliser une détection efficace des falsifications tout en protégeant la confidentialité du contenu vocal, afin de répondre aux défis posés par la synthèse vocale.

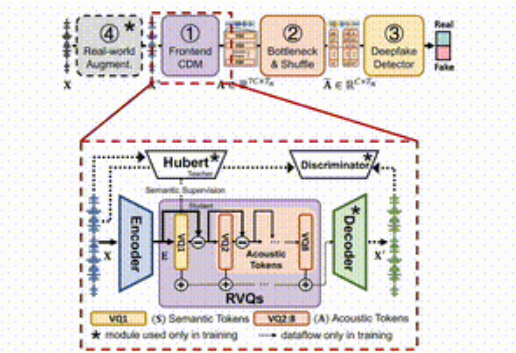

SafeEar repose sur un modèle de découplage basé sur un codec audio neuronal, qui sépare habilement les informations acoustiques et sémantiques de la parole. Cela signifie que SafeEar ne s'appuie que sur les informations acoustiques pour détecter les falsifications, sans avoir besoin d'accéder au contenu audio complet, ce qui permet de prévenir efficacement les fuites de données privées.

Le cadre est divisé en quatre parties principales.

Premièrement, le modèle de découplage frontal extrait les caractéristiques acoustiques cibles à partir du signal vocal d'entrée ; deuxièmement, la couche de goulot d'étranglement et la couche de confusion réduisent la dimension et brouillent les caractéristiques acoustiques, améliorant ainsi la résistance au vol de contenu ; troisièmement, le détecteur de falsification utilise un classificateur Transformer pour déterminer si l'audio a été falsifié ; enfin, le module d'augmentation de l'environnement réel simule différents environnements audio pour améliorer encore les performances de détection du modèle.

Accès au projet : https://github.com/LetterLiGo/SafeEar?tab=readme-ov-file

Après des expériences menées sur plusieurs ensembles de données de référence, l'équipe de recherche a constaté que le taux d'erreur de SafeEar était aussi faible que 2,02 %. Cela signifie qu'il est très efficace pour identifier les audios deepfake ! De plus, SafeEar est capable de protéger le contenu audio de cinq langues, le rendant difficilement analysable par des machines ou des oreilles humaines, avec un taux d'erreur de mots atteignant 93,93 %. Par ailleurs, les tests ont montré que les attaquants ne pouvaient pas restaurer le contenu vocal protégé, ce qui souligne les avantages de cette technologie en matière de protection de la vie privée.

En outre, l'équipe SafeEar a construit un ensemble de données contenant 1,5 million d'enregistrements audio multilingues, couvrant l'anglais, le chinois, l'allemand, le français et l'italien, fournissant ainsi une riche base de données pour la détection et la recherche futures sur la falsification vocale.

Le lancement de SafeEar apporte non seulement de nouvelles solutions au domaine de la détection de la falsification vocale, mais ouvre également la voie à la protection de la vie privée vocale des utilisateurs.

Points clés :

- 🎤 **L'architecture innovante de SafeEar** : capable de détecter les audios deepfake sans divulguer le contenu vocal, protégeant ainsi la vie privée des utilisateurs.

- 🔍 **Mécanisme d'auto-attention multi-têtes** : améliore la capacité d'identification des audios deepfake sans indices sémantiques, avec un taux d'erreur aussi faible que 2,02 %.

- 🔒 **Protection du contenu audio** : protège efficacement les audios de plusieurs langues contre l'analyse, avec un taux d'erreur de mots atteignant 93,93 %.