Dans le monde de l'IA, les données sont comme une mine d'or : plus elles sont abondantes, plus elles brillent. Récemment, LLM360 a lancé un ensemble de données remarquable, TxT360, spécialement conçu pour l'entraînement des grands modèles de langage. Ce mastodonte ne se contente pas de rassembler des données textuelles de haute qualité provenant de tous les secteurs d'activité, il a également subi un processus de déduplication à l'échelle mondiale, aboutissant à un ensemble de 5,7 billions de tokens de qualité : une véritable « boîte à outils des données » !

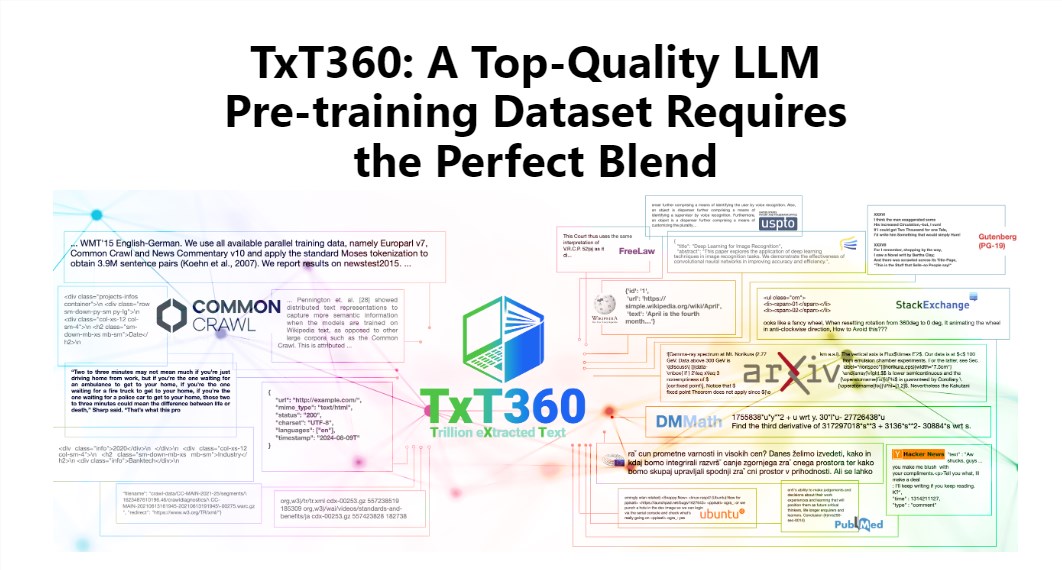

Le charme de TxT360 réside dans son ampleur et sa qualité exceptionnelles, surpassant les ensembles de données existants tels que FineWeb et RedPajama. Cet ensemble de données a extrait l'essence de l'internet à partir de 99 instantanés de Common Crawl, tout en sélectionnant 14 sources de données de haute qualité, telles que des documents juridiques et des encyclopédies, garantissant ainsi la richesse et la fiabilité de son contenu.

Plus impressionnant encore, TxT360 offre aux utilisateurs une « recette d'ajustement des pondérations des données », permettant d'ajuster les pondérations des différentes sources de données en fonction de leurs besoins. C'est comme en cuisine, où l'on peut ajuster les ingrédients à son goût pour un résultat délicieux.

Bien sûr, la technique de déduplication est également un point fort de TxT360. Grâce à des opérations de déduplication complexes, cet ensemble de données résout efficacement les problèmes de redondance et de répétition d'informations lors de l'entraînement, garantissant que chaque token est unique. De plus, l'équipe du projet a intelligemment supprimé les informations d'identification personnelle des documents, telles que les adresses électroniques et les adresses IP, à l'aide d'expressions régulières, assurant ainsi la confidentialité et la sécurité des données.

La conception de TxT360 ne se concentre pas uniquement sur l'ampleur, mais aussi sur la qualité. En combinant les avantages des données web et des sources de données sélectionnées, elle permet aux chercheurs de contrôler précisément l'utilisation et la distribution des données, comme s'ils disposaient d'une télécommande magique pour ajuster les proportions des données.

En termes de résultats d'entraînement, TxT360 n'est pas en reste. Grâce à une simple stratégie de suréchantillonnage, la quantité de données a considérablement augmenté, créant un ensemble de données de plus de 15 000 milliards de tokens. Sur une série d'indicateurs d'évaluation clés, TxT360 surpasse FineWeb, notamment dans les domaines MMLU et NQ, démontrant une capacité d'apprentissage exceptionnelle. L'intégration de données de code (comme Stack V2) rend la courbe d'apprentissage plus stable et améliore sensiblement les performances du modèle.

Plus d'informations : https://huggingface.co/spaces/LLM360/TxT360