Les grands modèles de langage (LLM), tels que la série GPT, tirent parti d'ensembles de données massifs pour démontrer des capacités étonnantes en matière de compréhension du langage, de raisonnement et de planification, atteignant des niveaux comparables à ceux des humains dans diverses tâches complexes. La plupart des recherches se concentrent sur l'amélioration de ces modèles en les entraînant sur des ensembles de données encore plus vastes, dans le but de développer des modèles de base plus puissants.

Cependant, bien que l'entraînement de modèles de base plus puissants soit crucial, les chercheurs estiment que la capacité à permettre aux modèles d'évoluer continuellement pendant la phase d'inférence, c'est-à-dire l'auto-évolution de l'IA, est tout aussi essentielle au développement de l'IA. Contrairement à l'entraînement de modèles à l'aide de données à grande échelle, l'auto-évolution peut nécessiter des données ou des interactions limitées.

Inspirés par la structure colonnaire du cortex cérébral humain, les chercheurs émettent l'hypothèse que les modèles d'IA peuvent développer des capacités cognitives émergentes et construire des modèles de représentation interne grâce à des interactions itératives avec leur environnement.

Pour atteindre cet objectif, les chercheurs proposent que les modèles doivent posséder une mémoire à long terme (MLT) pour stocker et gérer les données d'interaction du monde réel traitées. La MLT permet non seulement de représenter les données individuelles à longue traîne dans les modèles statistiques, mais aussi de favoriser l'auto-évolution en prenant en charge des expériences diverses à travers différents environnements et agents.

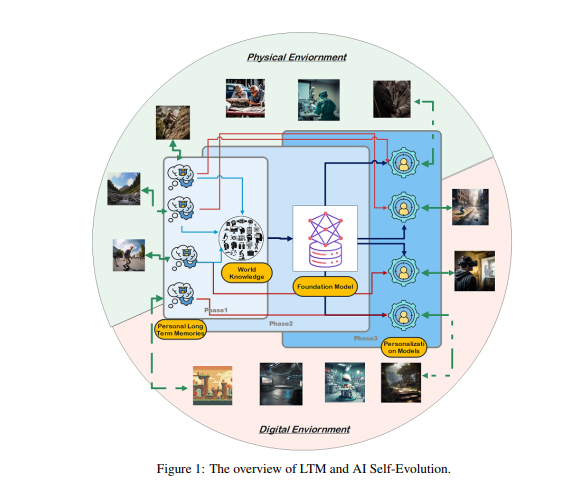

La MLT est la clé de l'auto-évolution de l'IA. De la même manière que les humains apprennent et s'améliorent constamment grâce à leurs expériences personnelles et à leurs interactions avec leur environnement, l'auto-évolution des modèles d'IA repose sur les données MLT accumulées au cours des interactions. Contrairement à l'évolution humaine, l'évolution des modèles pilotée par la MLT ne se limite pas aux interactions du monde réel. Les modèles peuvent interagir avec un environnement physique et recevoir des feedbacks directs, comme les humains, ces feedbacks, une fois traités, améliorant leurs capacités ; c'est un domaine de recherche clé de l'IA incarnée.

D'autre part, les modèles peuvent également interagir dans un environnement virtuel et accumuler des données MLT. Comparé aux interactions du monde réel, cela présente un coût inférieur et une efficacité accrue, permettant ainsi une amélioration plus efficace des capacités.

La construction de la MLT nécessite le raffinement et la structuration des données brutes. Les données brutes désignent l'ensemble de toutes les données non traitées reçues par le modèle par le biais d'interactions avec l'environnement externe ou pendant la phase d'entraînement. Ces données contiennent diverses observations et enregistrements, qui peuvent inclure des schémas précieux et une grande quantité d'informations redondantes ou non pertinentes.

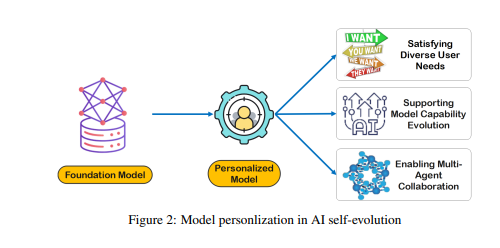

Bien que les données brutes constituent la base de la mémoire et de la cognition du modèle, elles doivent être traitées plus avant pour être utilisées efficacement pour la personnalisation ou l'exécution efficace des tâches. La MLT affine et structure ces données brutes afin que le modèle puisse les utiliser. Ce processus améliore la capacité du modèle à fournir des réponses et des suggestions personnalisées.

La construction de la MLT est confrontée à des défis tels que la rareté des données et la diversité des utilisateurs. Dans les systèmes MLT en constante évolution, la rareté des données est un problème courant, en particulier pour les utilisateurs ayant un historique d'interaction limité ou des activités sporadiques, ce qui rend l'entraînement du modèle difficile. De plus, la diversité des utilisateurs augmente la complexité, exigeant que le modèle s'adapte à la fois aux schémas individuels et généralise efficacement à travers différents groupes d'utilisateurs.

Les chercheurs ont développé un cadre de collaboration multi-agents appelé Omne, qui met en œuvre l'auto-évolution de l'IA basée sur la MLT. Dans ce cadre, chaque agent possède une structure système indépendante, capable d'apprendre et de stocker de manière autonome un modèle environnemental complet, construisant ainsi une compréhension indépendante de l'environnement. Grâce à ce développement collaboratif basé sur la MLT, le système d'IA peut s'adapter en temps réel aux changements de comportement individuel, optimiser la planification et l'exécution des tâches, favorisant ainsi davantage l'auto-évolution personnalisée et efficace de l'IA.

Le cadre Omne a obtenu la première place au benchmark GAIA, démontrant l'énorme potentiel de l'utilisation de la MLT pour l'auto-évolution de l'IA et la résolution de problèmes du monde réel. Les chercheurs sont convaincus que la promotion de la recherche sur la MLT est essentielle au développement continu et aux applications pratiques des technologies de l'IA, en particulier en ce qui concerne l'auto-évolution.

En résumé, la mémoire à long terme est la clé de l'auto-évolution de l'IA, permettant aux modèles d'IA d'apprendre et de s'améliorer à partir de l'expérience, comme les humains. La construction et l'utilisation de la MLT nécessitent de surmonter des défis tels que la rareté des données et la diversité des utilisateurs. Le cadre Omne offre une solution viable pour l'auto-évolution de l'IA basée sur la MLT, et son succès au benchmark GAIA démontre l'énorme potentiel de ce domaine.

Article : https://arxiv.org/pdf/2410.15665