Récemment, une équipe de recherche a publié un framework appelé HelloMeme, capable de transférer de manière extrêmement réaliste les expressions faciales d'une personne sur celles d'une autre personne dans une image.

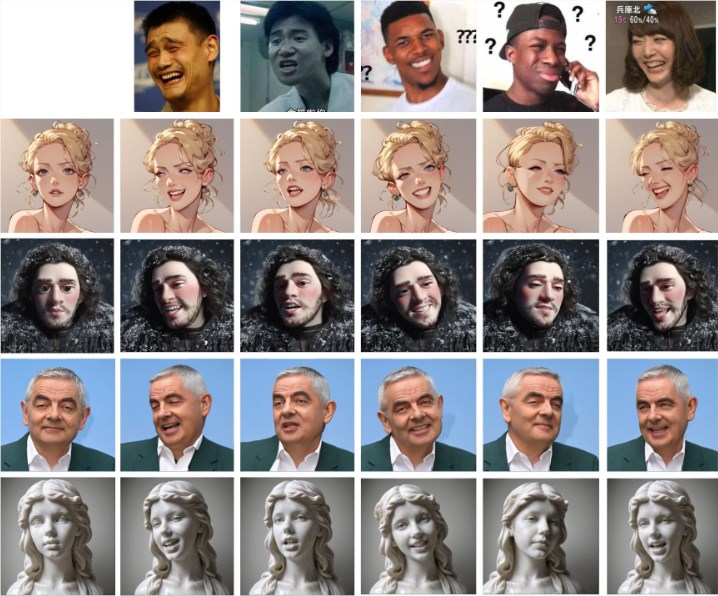

Comme illustré ci-dessous, il suffit de fournir une image d'expression (première ligne) pour transférer les détails de l'expression sur le visage d'autres personnages dans d'autres images.

Le cœur d'HelloMeme réside dans son architecture réseau unique. Ce framework peut extraire les caractéristiques de chaque image d'une vidéo, et les injecter dans le HMControlModule. Grâce à ce traitement, les chercheurs peuvent générer des séquences vidéo fluides. Cependant, dans les premières versions des vidéos générées, un problème de scintillement entre les images affectait l'expérience visuelle globale. Pour résoudre ce problème, l'équipe a introduit le module Animatediff, une innovation qui améliore considérablement la continuité vidéo, mais qui réduit légèrement la fidélité de l'image.

Face à cette contradiction, les chercheurs ont optimisé et ajusté le module Animatediff, réussissant ainsi à améliorer la continuité vidéo tout en maintenant une haute qualité d'image.

De plus, HelloMeme offre un support puissant pour l'édition des expressions faciales. Grâce à la liaison avec ARKit Face Blendshapes, les utilisateurs peuvent facilement contrôler les expressions faciales des personnages dans la vidéo générée. Cette flexibilité permet aux créateurs de générer des vidéos avec des émotions et des expressions spécifiques, enrichissant considérablement l'expressivité du contenu vidéo.

En termes de compatibilité technique, HelloMeme utilise une conception d'adaptateur d'insertion à chaud basée sur SD1.5. Le principal avantage de cette conception est qu'elle n'affecte pas les capacités de généralisation du modèle T2I (texte vers image), permettant l'intégration transparente de tout modèle de stylisation développé sur la base de SD1.5 avec HelloMeme. Cela offre davantage de possibilités créatives.

L'équipe de recherche a constaté que l'introduction du HMReferenceModule améliore considérablement les conditions de fidélité lors de la génération de vidéos, ce qui signifie qu'il est possible de réduire les étapes d'échantillonnage tout en générant des vidéos de haute qualité. Cette découverte améliore non seulement l'efficacité de la génération, mais ouvre également de nouvelles perspectives pour la génération vidéo en temps réel.

Les résultats de comparaison avec d'autres méthodes sont présentés ci-dessous. Il est évident que l'effet de transfert d'expression d'HelloMeme est plus naturel et plus proche de l'expression originale.

Accès au projet : https://songkey.github.io/hellomeme/

https://github.com/HelloVision/ComfyUI_HelloMeme

Points clés :

🌐 HelloMeme, grâce à son architecture réseau unique et au module Animatediff, permet d'améliorer à la fois la fluidité et la qualité d'image de la génération vidéo.

🎭 Le framework prend en charge ARKit Face Blendshapes, permettant aux utilisateurs de contrôler facilement les expressions faciales des personnages et d'enrichir l'expressivité du contenu vidéo.

⚙️ Il utilise une conception d'adaptateur d'insertion à chaud, garantissant la compatibilité avec les autres modèles basés sur SD1.5, offrant ainsi une plus grande flexibilité créative.