Dans le domaine de l'intelligence artificielle, une plus grande échelle semble signifier une plus grande puissance. Pour créer des modèles linguistiques plus performants, les grandes entreprises technologiques multiplient les paramètres de modèles et les données d'entraînement, mais découvrent que les coûts augmentent en conséquence. N'existe-t-il pas une méthode à la fois économique et efficace pour entraîner des modèles linguistiques ?

Des chercheurs de l'Université Harvard et de l'Université Stanford ont récemment publié un article dans lequel ils ont découvert que la précision du modèle d'entraînement était une clé cachée pour déverrouiller le « code secret des coûts » de l'entraînement des modèles linguistiques.

Qu'est-ce que la précision du modèle ? En termes simples, il s'agit du nombre de chiffres utilisés pour les paramètres du modèle et les calculs. Les modèles d'apprentissage profond traditionnels utilisent généralement des nombres à virgule flottante 32 bits (FP32) pour l'entraînement, mais ces dernières années, avec l'évolution du matériel, il est devenu possible d'utiliser des types de nombres de précision inférieure, tels que les nombres à virgule flottante 16 bits (FP16) ou les entiers 8 bits (INT8).

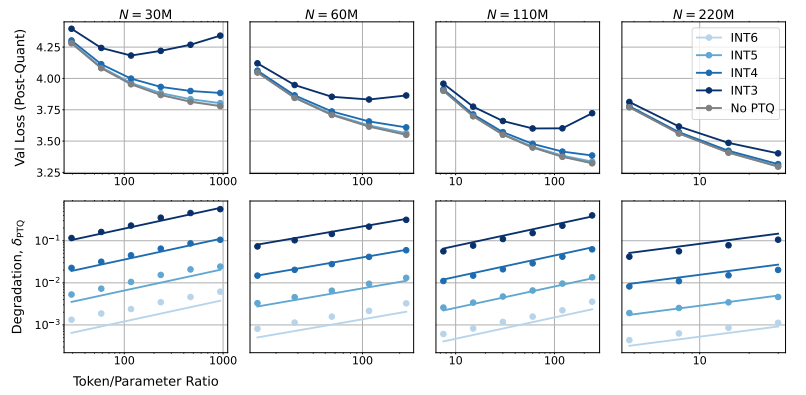

Alors, quel est l'impact de la réduction de la précision du modèle sur les performances du modèle ? C'est la question que cet article tente de résoudre. Les chercheurs, grâce à de nombreuses expériences, ont analysé l'évolution des coûts et des performances de l'entraînement et de l'inférence du modèle à différentes précisions, et ont proposé une toute nouvelle loi d'échelle « sensible à la précision ».

Ils ont constaté que l'utilisation d'une précision inférieure permet de réduire efficacement le « nombre de paramètres effectifs » du modèle, réduisant ainsi la quantité de calculs nécessaires à l'entraînement. Cela signifie qu'avec le même budget de calcul, nous pouvons entraîner des modèles de plus grande envergure, ou, à taille égale, une précision inférieure permet d'économiser d'importantes ressources de calcul.

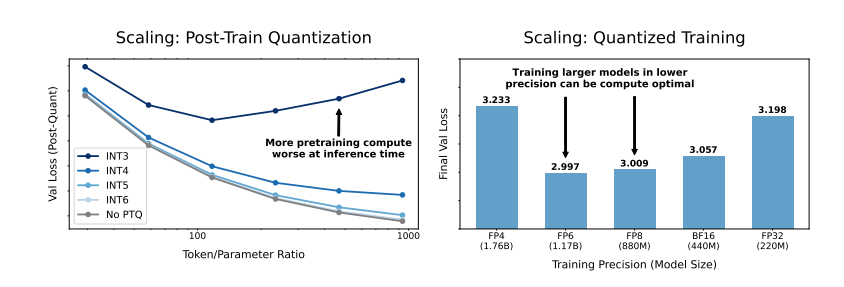

Plus surprenant encore, les chercheurs ont découvert que dans certains cas, l'utilisation d'une précision inférieure pour l'entraînement pouvait améliorer les performances du modèle ! Par exemple, pour les modèles nécessitant une « quantification post-entraînement », l'utilisation d'une précision inférieure lors de l'entraînement rend le modèle plus robuste à la réduction de précision après quantification, améliorant ainsi les performances lors de l'inférence.

Quelle précision devons-nous donc choisir pour entraîner un modèle ? Les chercheurs, en analysant leur loi d'échelle, ont tiré des conclusions intéressantes :

L'entraînement traditionnel à 16 bits n'est peut-être pas le choix optimal. Leurs recherches suggèrent que la précision 7-8 bits pourrait être un choix plus économique et efficace.

Il n'est pas non plus judicieux de viser une précision extrêmement basse (par exemple, 4 bits). En effet, à très faible précision, le nombre de paramètres effectifs du modèle diminue fortement. Pour maintenir les performances, il faut augmenter considérablement la taille du modèle, ce qui entraîne des coûts de calcul plus élevés.

La meilleure précision d'entraînement peut varier en fonction de la taille du modèle. Pour les modèles nécessitant un « sur-entraînement » important, tels que les séries Llama-3 et Gemma-2, l'utilisation d'une précision plus élevée peut être plus économique et efficace.

Cette recherche offre un nouveau point de vue sur la compréhension et l'optimisation de l'entraînement des modèles linguistiques. Elle nous apprend que le choix de la précision n'est pas figé, mais doit être évalué en fonction de la taille du modèle, de la quantité de données d'entraînement et du contexte d'application.

Bien sûr, cette recherche présente certaines limites. Par exemple, les modèles utilisés sont relativement petits, et les résultats expérimentaux ne peuvent pas être directement extrapolés à des modèles de plus grande envergure. De plus, ils ne se sont concentrés que sur la fonction de perte du modèle, sans évaluer les performances du modèle sur des tâches en aval.

Néanmoins, cette recherche est d'une importance considérable. Elle révèle la relation complexe entre la précision du modèle, les performances du modèle et les coûts d'entraînement, et fournit de précieuses informations pour la conception et l'entraînement futurs de modèles linguistiques plus puissants et plus économiques.

Article : https://arxiv.org/pdf/2411.04330