Récemment, une équipe de chercheurs de l'Université Stanford, de l'Université de Washington et de Google DeepMind a développé de nouveaux agents d'intelligence artificielle (IA) capables de simuler avec précision le comportement humain dans des expériences sociales. Selon leurs recherches, cette technique de simulation pourrait fournir une base de laboratoire pour tester des théories en économie, sociologie, organisation et sciences politiques.

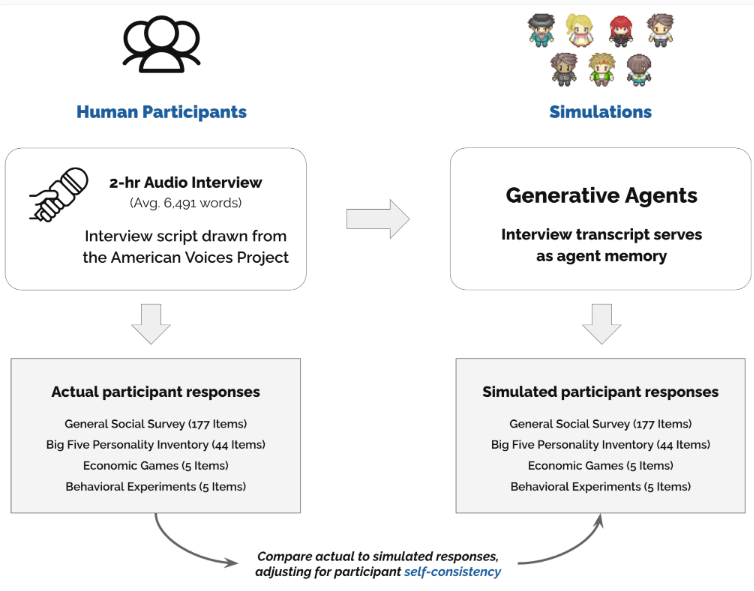

Les chercheurs ont construit ces agents IA en utilisant les données d'entretiens de plus de 1 000 électeurs américains. L'âge, le sexe, le niveau d'éducation et les opinions politiques de ces personnes interrogées représentent la diversité de la société américaine. Les agents IA, en analysant ces enregistrements d'entretiens et en utilisant le modèle GPT-4o, reproduisent les réactions réelles des personnes interrogées lorsque l'utilisateur pose des questions.

Concrètement, l'équipe de recherche a mené des entretiens approfondis de deux heures avec chaque participant, et a utilisé le modèle Whisper d'OpenAI pour transcrire les entretiens en texte. Cette méthode a considérablement amélioré la précision des agents IA. Lors de tests de prédiction du comportement humain, les agents IA basés sur les données d'entretien ont réussi à prédire avec 85 % de précision les réponses des humains dans des enquêtes sociales générales, surpassant nettement les agents IA ne s'appuyant que sur des données démographiques de base.

Les chercheurs ont également mené cinq expériences de sciences sociales. Dans quatre de ces expériences, les résultats produits par les agents IA étaient fortement cohérents avec les réactions des participants humains, avec un coefficient de corrélation de 0,98. Cela montre que la méthode basée sur les entretiens présente une plus grande précision et un meilleur équilibre dans l'analyse des réponses des différents groupes politiques et ethniques.

Pour favoriser la recherche future, l'équipe de recherche a mis en ligne sur GitHub le jeu de données des 1 000 agents IA qu'elle a créés, à la disposition des autres scientifiques. Pour protéger la vie privée des participants, l'équipe a mis en place un système d'accès à deux niveaux.

Les scientifiques peuvent accéder librement aux données de réponse agrégées pour certaines tâches spécifiques, tandis que l'accès aux données de réponse individuelles dans le cadre de recherches ouvertes nécessite des autorisations spéciales. Ce système vise à aider les chercheurs à mieux étudier le comportement humain tout en protégeant la vie privée des participants aux entretiens originaux.

Accès au projet : https://github.com/joonspk-research/genagents

Points clés :

🌟 Les agents IA développés par l'équipe de recherche, basés sur des données d'entretien, peuvent simuler avec précision le comportement humain, améliorant ainsi la précision de la recherche en sciences sociales.

📊 La précision de prédiction des agents IA dans les enquêtes sociales atteint 85 %, surpassant nettement les agents IA ne s'appuyant que sur des données démographiques.

🔍 Le jeu de données est public et accessible aux autres chercheurs via GitHub, favorisant la recherche sur le comportement humain tout en protégeant la vie privée des participants.