L'institut de recherche sur l'IA à but non lucratif Ai2 a récemment publié sa nouvelle série OLMo2, la deuxième génération de sa série de « modèles linguistiques ouverts » (OLMo). La sortie d'OLMo2 offre non seulement un soutien technique puissant à la communauté de l'IA, mais représente également, grâce à son code source entièrement ouvert, les dernières avancées de l'IA open source.

Contrairement à d'autres modèles linguistiques « ouverts » disponibles sur le marché, tels que la série Llama de Meta, OLMo2 répond à la définition stricte de l'Open Source Initiative. Cela signifie que les données d'entraînement, les outils et le code utilisés pour son développement sont publics et accessibles à tous. Selon la définition de l'Open Source Initiative, OLMo2 répond aux critères de l'« IA open source » de l'organisation, critères finalisés en octobre dernier.

Ai2 mentionne sur son blog que toutes les données d'entraînement, le code, les schémas d'entraînement, les méthodes d'évaluation et les points de contrôle intermédiaires d'OLMo2 sont entièrement ouverts. L'objectif est de stimuler l'innovation et la découverte au sein de la communauté open source grâce au partage des ressources. « En partageant ouvertement nos données, nos méthodes et nos découvertes, nous espérons fournir à la communauté open source les ressources nécessaires pour découvrir de nouvelles méthodes et des technologies innovantes », déclare Ai2.

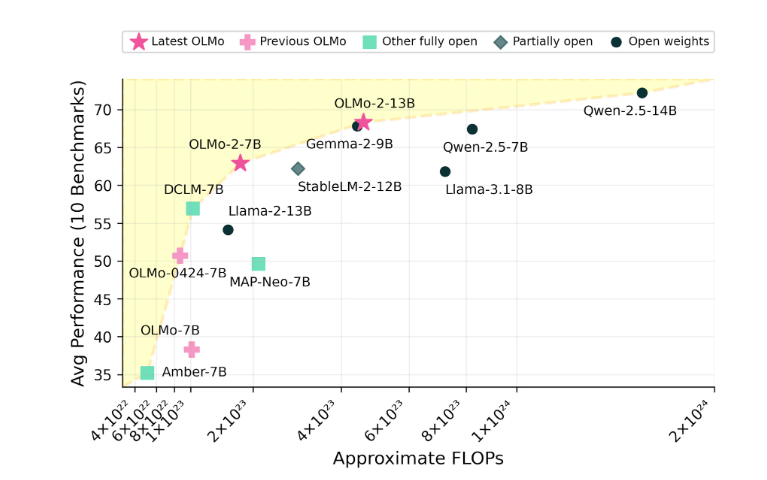

La série OLMo2 comprend deux versions : OLMo7B avec 7 milliards de paramètres et OLMo13B avec 13 milliards de paramètres. Le nombre de paramètres influence directement les performances du modèle, les versions ayant plus de paramètres étant généralement capables de gérer des tâches plus complexes. OLMo2 excelle dans les tâches textuelles courantes, telles que la réponse aux questions, la synthèse de documents et la rédaction de code.

Source : Image générée par IA, fournisseur de services d'autorisation d'images Midjourney

Pour entraîner OLMo2, Ai2 a utilisé un ensemble de données contenant cinq billions de jetons. Un jeton est la plus petite unité dans un modèle linguistique ; un million de jetons équivaut à environ 750 000 mots. Les données d'entraînement incluent du contenu provenant de sites Web de haute qualité, d'articles scientifiques, de forums de questions-réponses et d'exercices de mathématiques synthétiques. Ces données ont été soigneusement sélectionnées pour garantir l'efficacité et la précision du modèle.

Ai2 a toute confiance dans les performances d'OLMo2, affirmant qu'il est désormais en compétition avec des modèles open source tels que Llama 3.1 de Meta en termes de performances. Ai2 souligne qu'OLMo2 7B surpasse même Llama 3.1 8B, faisant de lui l'un des modèles linguistiques entièrement ouverts les plus performants du moment. Tous les modèles OLMo2 et leurs composants peuvent être téléchargés gratuitement sur le site Web d'Ai2 et sont soumis à la licence Apache 2.0, ce qui signifie qu'ils peuvent être utilisés à des fins de recherche et commerciales.