Ces dernières années, la demande d'applications de modèles d'apprentissage automatique pour les tâches de vision et de langage a augmenté de manière significative. Cependant, la plupart de ces modèles nécessitent d'énormes ressources de calcul, ce qui rend leur exécution inefficace sur les appareils personnels. Les petits appareils tels que les ordinateurs portables, les GPU grand public et les appareils mobiles sont particulièrement confrontés à des défis importants lors du traitement des tâches de vision-langage.

Prenons l'exemple de Qwen2-VL : malgré ses performances exceptionnelles, ses exigences matérielles élevées limitent son utilisation dans les applications en temps réel. Le développement de modèles légers capables de fonctionner avec des ressources limitées est donc devenu une nécessité.

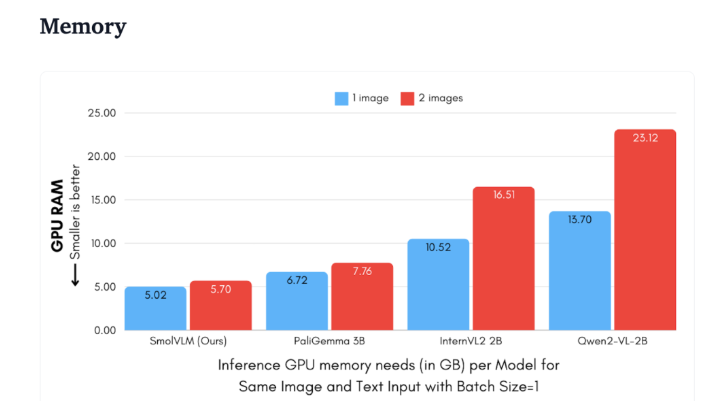

Hugging Face a récemment publié SmolVLM, un modèle de langage visuel de 2 milliards de paramètres spécialement conçu pour l'inférence sur les appareils. SmolVLM surpasse les autres modèles de sa catégorie en termes d'utilisation de la mémoire GPU et de vitesse de génération de jetons. Sa principale caractéristique est sa capacité à fonctionner efficacement sur des appareils modestes, tels que les ordinateurs portables ou les GPU grand public, sans sacrifier les performances. SmolVLM trouve un équilibre idéal entre performances et efficacité, résolvant ainsi un problème que les modèles précédents avaient du mal à surmonter.

Comparé à Qwen2-VL 2B, SmolVLM est 7,5 à 16 fois plus rapide pour générer des jetons, grâce à son architecture optimisée qui permet une inférence légère. Cette efficacité profite non seulement aux utilisateurs finaux, mais améliore également considérablement l'expérience utilisateur.

D'un point de vue technique, SmolVLM possède une architecture optimisée qui permet une inférence efficace sur les appareils. Les utilisateurs peuvent même facilement l'ajuster sur Google Colab, ce qui réduit considérablement le seuil d'expérimentation et de développement.

Grâce à sa faible consommation de mémoire, SmolVLM peut fonctionner sur des appareils qui ne pouvaient auparavant pas supporter des modèles similaires. Lors de tests sur des vidéos YouTube de 50 images par seconde, SmolVLM a obtenu un score remarquable de 27,14 %, surpassant deux modèles plus gourmands en ressources, démontrant ainsi sa grande adaptabilité et sa flexibilité.

SmolVLM représente une étape importante dans le domaine des modèles de langage visuel. Son lancement permet d'exécuter des tâches complexes de vision-langage sur des appareils courants, comblant ainsi une lacune importante dans les outils d'IA actuels.

SmolVLM n'est pas seulement performant en termes de vitesse et d'efficacité, il offre également aux développeurs et aux chercheurs un outil puissant pour le traitement du langage visuel, sans avoir à investir dans du matériel coûteux. Avec la démocratisation croissante de l'IA, des modèles comme SmolVLM rendront les puissantes capacités d'apprentissage automatique plus accessibles.

demo:https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

Points clés :

🌟 SmolVLM est un modèle de langage visuel de 2 milliards de paramètres développé par Hugging Face, spécialement conçu pour l'inférence sur les appareils. Il est performant et ne nécessite pas de matériel haut de gamme.

⚡ Sa vitesse de génération de jetons est 7,5 à 16 fois supérieure à celle des modèles similaires, améliorant considérablement l'expérience utilisateur et l'efficacité des applications.

📊 Lors des tests, SmolVLM a démontré une grande adaptabilité, obtenant de bons scores même sans entraînement sur des données vidéo.