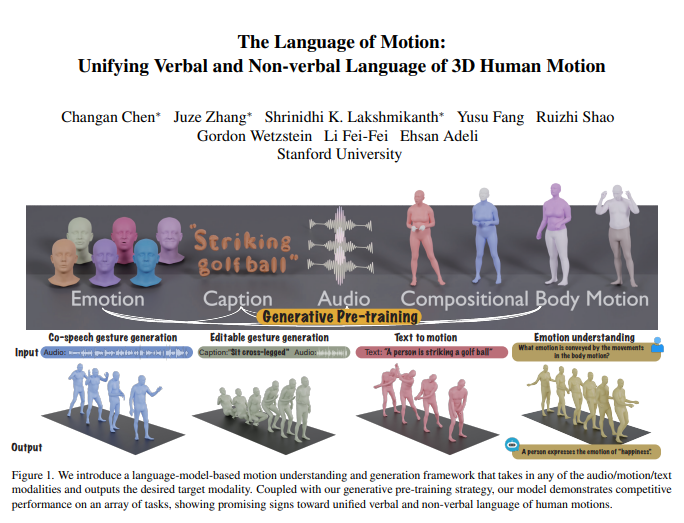

L'équipe de Fei-Fei Li a présenté un nouveau modèle multi-modal capable de comprendre et de générer des actions humaines, et qui, grâce à l'intégration d'un modèle linguistique, permet un traitement unifié du langage oral et non verbal. Cette recherche révolutionnaire permet aux machines non seulement de comprendre les instructions humaines, mais aussi de déchiffrer les émotions véhiculées par les mouvements, pour une interaction homme-machine plus naturelle.

Au cœur de ce modèle se trouve un cadre de modèle linguistique multi-modal capable de recevoir des entrées sous diverses formes : audio, mouvements et texte, et de produire les données modales nécessaires. Grâce à une stratégie de pré-entraînement générative, ce modèle affiche des performances exceptionnelles sur plusieurs tâches. Par exemple, en matière de génération de gestes vocaux coordonnés, il surpasse les technologies existantes et réduit considérablement la quantité de données nécessaires à l'entraînement. De plus, il ouvre de nouveaux champs d'application, tels que la génération de gestes modifiables et la prédiction des émotions à partir des mouvements.

La communication humaine est intrinsèquement multi-modale, impliquant des indices verbaux et non verbaux tels que la voix, les expressions faciales et la posture corporelle. La capacité de ce modèle à comprendre ces comportements multi-modaux est essentielle pour créer des personnages virtuels capables d'une communication naturelle dans des applications telles que les jeux, le cinéma et la réalité virtuelle. Cependant, les modèles de génération de mouvements existants se limitent généralement à des modalités d'entrée spécifiques (voix, texte ou données de mouvement), sans exploiter pleinement la diversité des données disponibles.

Ce modèle utilise un modèle linguistique pour unifier le langage oral et non verbal, pour trois raisons principales :

Les modèles linguistiques connectent naturellement les différentes modalités.

La parole est hautement sémantique, et la modélisation de tâches telles que la réaction à une blague nécessite de solides capacités de raisonnement sémantique.

Les modèles linguistiques acquièrent de puissantes capacités de compréhension sémantique grâce à un pré-entraînement intensif.

Pour atteindre cet objectif, l'équipe de recherche a commencé par diviser le corps en différentes parties (visage, mains, haut du corps, bas du corps) et a marqué individuellement les mouvements de chaque partie. En combinant les marqueurs de texte et de voix, toute entrée modale peut être représentée sous forme d'une série de marqueurs utilisables par le modèle linguistique. Le modèle utilise un processus d'entraînement en deux phases : un pré-entraînement pour aligner les différentes modalités avec les mouvements corporels combinés, ainsi que l'audio et le texte. Ensuite, les tâches en aval sont transformées en instructions, et le modèle est entraîné sur ces instructions pour qu'il puisse suivre diverses instructions de tâches.

Ce modèle a obtenu d'excellents résultats sur le benchmark BEATv2 de génération de gestes vocaux coordonnés, surpassant largement les modèles existants. L'efficacité de la stratégie de pré-entraînement a également été vérifiée, notamment dans les cas de pénurie de données, démontrant une forte capacité de généralisation. Grâce à un entraînement ultérieur sur des tâches voix-mouvement et texte-mouvement, le modèle peut non seulement suivre les invites audio et textuelles, mais aussi réaliser de nouvelles fonctions telles que la prédiction des émotions à partir des données de mouvement.

Sur le plan technique, le modèle utilise des marqueurs spécifiques à la modalité pour traiter les différentes modalités d'entrée. Plus précisément, le modèle entraîne un VQ-VAE de mouvement corporel combiné pour convertir les mouvements du visage, des mains, du haut du corps et du bas du corps en marqueurs discrets. Ces vocabulaires spécifiques à la modalité (audio et texte) sont fusionnés dans un vocabulaire multi-modal unifié. Pendant l'entraînement, les marqueurs mélangés de différentes modalités servent d'entrée, et un modèle linguistique encodeur-décodeur génère la sortie.

Le modèle utilise également un vocabulaire multi-modal pour convertir les données de différentes modalités en un format unifié pour le traitement. Lors de la phase de pré-entraînement, le modèle apprend les correspondances entre les différentes modalités en effectuant des tâches de conversion inter-modalités. Par exemple, le modèle peut apprendre à convertir les mouvements du haut du corps en mouvements du bas du corps, ou l'audio en texte. De plus, le modèle apprend l'évolution temporelle des mouvements en masquant aléatoirement certaines images de mouvement.

Lors de la phase d'entraînement ultérieur, le modèle est affiné à l'aide de données appariées pour effectuer des tâches en aval telles que la génération de gestes vocaux coordonnés ou la génération de texte en mouvement. Pour permettre au modèle de suivre les instructions humaines naturelles, les chercheurs ont créé un modèle de suivi d'instructions multi-tâches qui transforme les tâches telles que l'audio en mouvement, le texte en mouvement et l'émotion en mouvement en instructions. Le modèle est également capable de modifier les gestes, générant des mouvements corporels complets et coordonnés à partir d'invites textuelles et audio.

Enfin, le modèle a débloqué une nouvelle capacité : la prédiction des émotions à partir des mouvements. Ceci est d'une importance capitale pour des domaines tels que la santé mentale ou la psychiatrie. Comparé à d'autres modèles, il prédit plus précisément les émotions exprimées par les mouvements, démontrant une forte capacité de compréhension du langage corporel.

Cette recherche montre que l'unification du langage oral et non verbal des mouvements humains est essentielle pour les applications pratiques, et que les modèles linguistiques offrent un cadre puissant pour y parvenir.

Adresse de l'article : https://arxiv.org/pdf/2412.10523v1