Six mois seulement après le lancement des GB200 et B200, Nvidia lance de nouveaux GPU : les GB300 et B300. Bien que cela puisse sembler une simple mise à niveau, il s'agit en réalité d'une transformation majeure, notamment grâce à une amélioration significative des performances des modèles d'inférence, qui aura un impact profond sur l'ensemble du secteur.

B300/GB300 : un bond gigantesque en matière de performances d'inférence

Le GPU B300 utilise le nœud de processus 4N de TSMC, optimisé pour les puces de calcul. Cela permet au B300 d'atteindre des performances FLOPS 50 % supérieures à celles du B200. Une partie de cette amélioration est due à l'augmentation du TDP, qui atteint 1,4 kW pour le GB300 et 1,2 kW pour le B300 HGX (contre 1,2 kW et 1 kW respectivement pour les GB200 et B200). Le reste de l'amélioration provient d'améliorations architecturales et d'optimisations au niveau du système, telles que la répartition dynamique de la puissance entre le CPU et le GPU.

Outre l'amélioration des FLOPS, la mémoire a été mise à niveau vers la 12-Hi HBM3E, augmentant la capacité HBM de chaque GPU à 288 Go. Cependant, la vitesse des broches reste inchangée, de sorte que la bande passante mémoire de chaque GPU reste de 8 To/s. Il est à noter que Samsung n'a pas participé à la chaîne d'approvisionnement des GB200 ou GB300.

Nvidia a également ajusté ses prix. Cela aura un certain impact sur la marge bénéficiaire des produits Blackwell, mais plus important encore, l'amélioration des performances des B300/GB300 se traduira principalement par une amélioration des modèles d'inférence.

Conçus sur mesure pour les modèles d'inférence

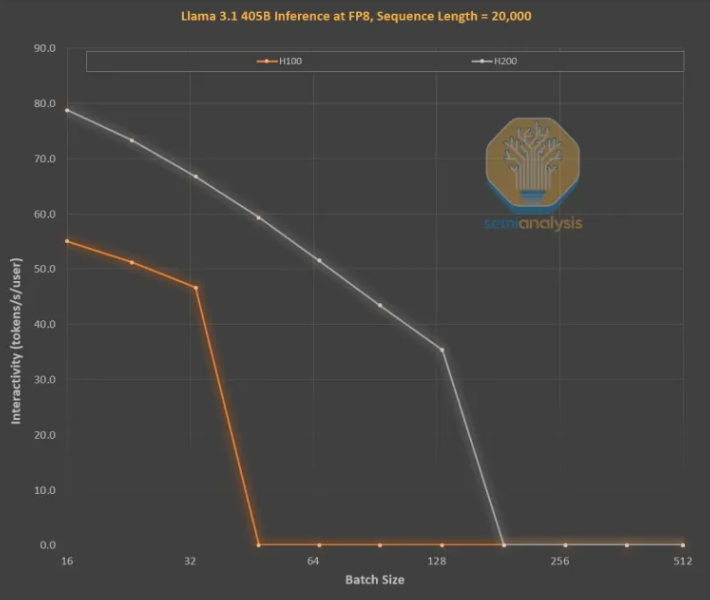

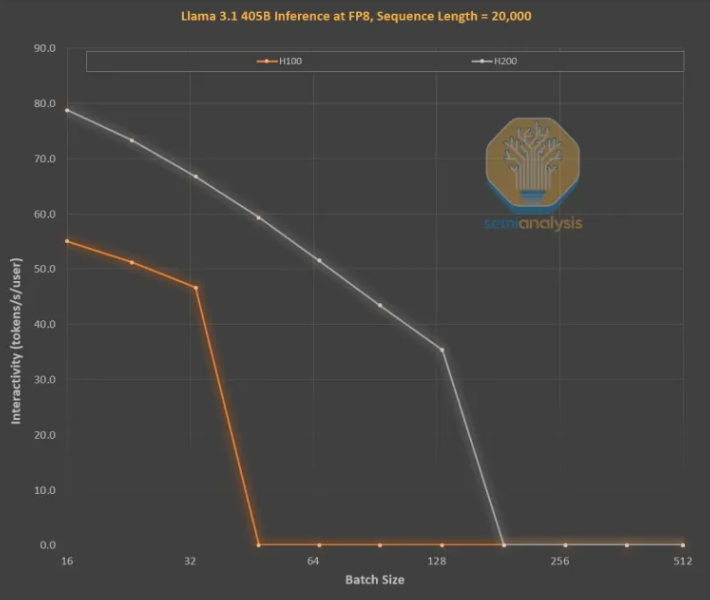

L'amélioration de la mémoire est essentielle pour l'entraînement de l'inférence des LLM de type OpenAI O3, car les longues séquences augmentent le KVCache, limitant ainsi la taille de lot critique et la latence. La mise à niveau de H100 à H200 (principalement l'augmentation de la mémoire) a apporté deux améliorations :

Une bande passante mémoire plus élevée (4,8 To/s pour H200 contre 3,35 To/s pour H100) a amélioré globalement l'interactivité de toutes les tailles de lots comparables de 43 %.

La taille de lot exécutée par H200 étant plus importante que celle de H100, le nombre de jetons générés par seconde a triplé, tandis que le coût a été réduit d'environ 3 fois. Cette différence est principalement due au fait que le KVCache limite la taille de lot totale.

L'augmentation de la capacité de mémoire a un impact considérable sur les performances. La différence de performances et de rentabilité entre les deux GPU est bien supérieure à ce que leurs spécifications suggèrent :

L'expérience utilisateur des modèles d'inférence peut être médiocre en raison d'un temps d'attente important entre la requête et la réponse. Une accélération significative du temps d'inférence améliorerait l'utilisation et la volonté de payer des utilisateurs.

L'amélioration des performances d'un facteur 3 grâce à une mise à niveau de la mémoire intermédiaire est remarquable, dépassant largement la loi de Moore, la loi de Huang ou toute autre vitesse d'amélioration matérielle que nous ayons jamais observée.

Les modèles les plus performants peuvent facturer une prime beaucoup plus élevée que les modèles légèrement moins performants. La marge bénéficiaire des modèles de pointe dépasse 70 %, tandis que celle des modèles open source concurrents est inférieure à 20 %. Les modèles d'inférence ne doivent pas se limiter à une seule chaîne de pensée. La fonctionnalité de recherche peut être étendue pour améliorer les performances, comme cela a été fait dans O1Pro et O3. Cela permet aux modèles plus intelligents de résoudre davantage de problèmes et de générer plus de revenus par GPU.

Bien sûr, Nvidia n'est pas la seule entreprise capable d'augmenter la capacité de mémoire. Les ASIC peuvent également le faire, et en fait, AMD pourrait être mieux placé, car la capacité de mémoire de ses MI300X, MI325X et MI350X est généralement supérieure à celle de Nvidia, avec respectivement 192 Go, 256 Go et 288 Go, mais Nvidia possède une arme secrète : NVLink.

L'importance de NVL72 réside dans sa capacité à permettre à 72 GPU de collaborer sur le même problème, de partager la mémoire et d'obtenir une latence extrêmement faible. Aucun autre accélérateur au monde ne possède une capacité d'échange interconnectée.

Les GB200NVL72 et GB300NVL72 de Nvidia sont essentiels à la réalisation de nombreuses fonctions clés :

Une interactivité accrue, réduisant la latence de chaque chaîne de pensée.

72 GPU peuvent répartir le KVCache, permettant ainsi des chaînes de pensée plus longues (amélioration de l'intelligence).

Une évolutivité de la taille de lot bien meilleure que celle des serveurs 8 GPU typiques, réduisant ainsi les coûts.

Un volume d'échantillons plus important travaillant sur le même problème pour améliorer la précision et les performances du modèle.

Par conséquent, la tokenomique de NVL72 a été améliorée de plus de 10 fois, en particulier pour les longues chaînes d'inférence. L'occupation de la mémoire par le KVCache est préjudiciable à la rentabilité, mais NVL72 est le seul moyen d'étendre la longueur de l'inférence à plus de 100 000 jetons.

GB300 : restructuration de la chaîne d'approvisionnement

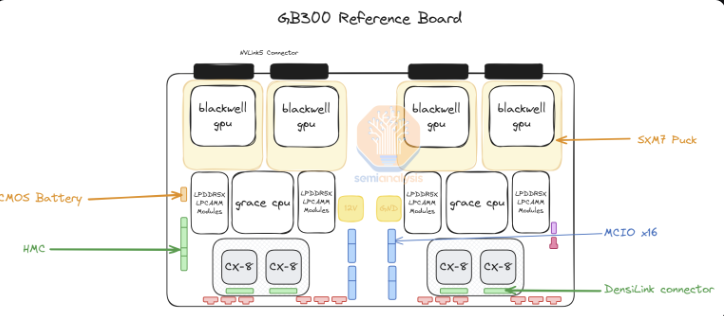

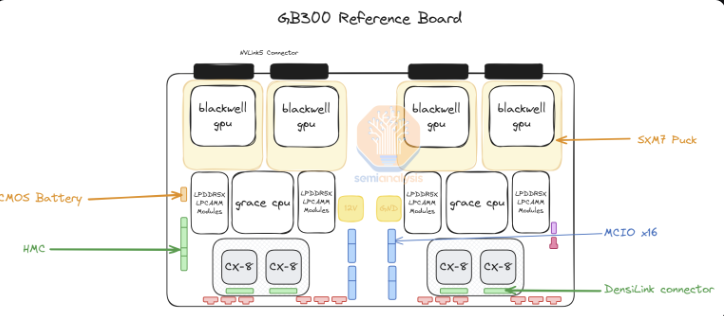

Pour le GB300, Nvidia a apporté des changements importants à sa chaîne d'approvisionnement et à son contenu. Pour le GB200, Nvidia fournissait la carte Bianca complète (incluant le GPU Blackwell, le CPU Grace, 512 Go de LPDDR5X, le contenu VRM), ainsi que le plateau d'échange et la plaque arrière en cuivre.

Pour le GB300, Nvidia ne fournit que le module B300 sur « SXM Puck », le CPU Grace en boîtier BGA et le HMC, qui proviendra de la start-up américaine Axiado, et non d'Aspeed comme pour le GB200. Les clients finaux achèteront désormais directement les composants restants de la carte de calcul, et la mémoire de deuxième niveau utilisera des modules LPCAMM, et non plus de la LPDDR5X soudée. Micron sera le principal fournisseur de ces modules. Le plateau d'échange et la plaque arrière en cuivre restent inchangés, et Nvidia fournit entièrement ces composants.

Le passage au SXM Puck offre aux fabricants d'équipement d'origine (OEM) et aux fabricants de conception originale (ODM) davantage d'opportunités de participer à la conception des plateaux de calcul. Auparavant, seuls Wistron et Foxconn pouvaient fabriquer les cartes de calcul Bianca, tandis que désormais, davantage d'OEM et d'ODM peuvent y participer. Wistron est le plus grand perdant sous forme d'ODM, car il a perdu des parts de marché sur les cartes Bianca. Pour Foxconn, la perte de parts de marché sur les cartes Bianca est compensée par le fait qu'il est le fabricant exclusif des SXM Puck et de leurs logements. Nvidia tente d'intégrer d'autres fournisseurs pour les Puck et les logements, mais aucune autre commande n'a encore été passée.

Un autre changement majeur concerne le contenu VRM. Bien qu'il y ait du contenu VRM sur le SXM Puck, la majeure partie du contenu VRM embarqué sera achetée directement par les hyperscalers/OEM auprès des fournisseurs de VRM. Monolithic Power Systems perdra des parts de marché en raison de ce changement de modèle commercial.

Nvidia propose également le ConnectX-8 NIC 800G sur la plateforme GB300, offrant une bande passante d'extension double sur InfiniBand et Ethernet. Nvidia avait précédemment annulé le ConnectX-8 du GB200 en raison de la complexité des délais de mise sur le marché et de l'abandon de l'activation du PCIe Gen6 sur la carte Bianca.

ConnectX-8 représente une amélioration significative par rapport à ConnectX-7. Il ne possède pas seulement une bande passante deux fois plus élevée, mais aussi 48 canaux PCIe au lieu de 32, permettant des architectures uniques telles que le MGX B300A refroidi par air. De plus, ConnectX-8 possède des capacités SpectrumX, tandis que dans les produits 400G précédents, SpectrumX nécessitait un Bluefield 3 DPU moins efficace.

Impact du GB300 sur les hyperscalers

L'impact de la latence des GB200 et GB300 sur les hyperscalers signifie que de nombreuses commandes à partir du troisième trimestre seront transférées vers les nouveaux GPU plus coûteux de Nvidia. À la semaine dernière, tous les hyperscalers ont décidé d'adopter le GB300. Cela est dû en partie aux performances supérieures du GB300, mais aussi au fait qu'ils peuvent contrôler leur propre destin.

En raison des défis liés aux délais de mise sur le marché et des changements importants au niveau des racks, du refroidissement et de l'alimentation/de la densité, les hyperscalers n'ont pas permis de nombreuses modifications au niveau du serveur pour le GB200. Cela a conduit Meta à abandonner l'espoir d'utiliser des NIC multi-sources de Broadcom et Nvidia, se tournant entièrement vers Nvidia. Dans d'autres cas, comme celui de Google, ils ont abandonné leurs NIC internes pour n'utiliser que celles de Nvidia.

C'est tout simplement incroyable pour des organisations de plusieurs milliers de personnes au sein des hyperscalers, habituées à optimiser tous les coûts, du CPU au réseau, en passant par les vis et les plaques métalliques.

L'exemple le plus frappant est celui d'Amazon, qui a opté pour une configuration très sous-optimale, dont le coût total de possession (TCO) est inférieur à celui de la conception de référence. Amazon, en raison de l'utilisation d'un commutateur PCIe et d'un NIC d'adaptateur de fibre optique élastique 200G moins efficace, nécessite un refroidissement par air, ce qui l'empêche de déployer des racks NVL72 comme Meta, Google, Microsoft, Oracle, X.AI et Coreweave. En raison de son NIC interne, Amazon a dû utiliser NVL36, ce qui a également entraîné un coût plus élevé par GPU en raison d'un contenu de carte mère et de commutateur plus important. En résumé, la configuration d'Amazon n'est pas optimale en raison de ses contraintes de personnalisation.

Avec le GB300, les hyperscalers peuvent désormais personnaliser davantage de composants, tels que les cartes mères et le refroidissement. Cela permet à Amazon de construire ses propres cartes mères personnalisées, refroidies par eau et intégrant des composants auparavant refroidis par air, tels que le commutateur PCIe d'Astera Labs. Avec davantage de composants refroidis par eau et la réalisation finale du HVM sur le NIC K2V6400G au troisième trimestre 2025, cela signifie qu'Amazon peut revenir à l'architecture NVL72 et améliorer considérablement son TCO.

Bien que les hyperscalers doivent concevoir, valider et confirmer davantage de contenu, c'est le principal inconvénient. Cela pourrait facilement devenir la plateforme la plus complexe que les hyperscalers aient jamais dû concevoir (à l'exception du système TPU de Google). Certains hyperscalers pourront concevoir rapidement, mais les équipes plus lentes prendront du retard. Malgré les annulations signalées dans les rapports de marché, nous pensons que Microsoft, en raison de sa vitesse de conception plus lente, est l'un des plus lents à déployer le GB300, et ils achètent encore quelques GB200 au quatrième trimestre.

La différence de prix total payé par le client est importante, car les composants sont extraits de la pile de profit de Nvidia et transférés aux ODM. Les revenus des ODM sont affectés et, surtout, la marge bénéficiaire de Nvidia évoluera tout au long de l'année.

Références : https://semianalysis.com/2024/12/25/nvidias-christmas-present-gb300-b300-reasoning-inference-amazon-memory-supply-chain/