Le 26 décembre 2024, DeepSeek, une start-up chinoise spécialisée dans l'intelligence artificielle, a lancé son dernier modèle de grande taille, DeepSeek-V3. Ce modèle se distingue par son code source ouvert et ses innovations qui le placent en tête des fournisseurs d'IA.

DeepSeek-V3 possède 671 milliards de paramètres et utilise une architecture de mélange d'experts (mixture-of-experts architecture) pour activer des paramètres spécifiques, permettant ainsi un traitement précis et efficace des tâches données. Selon les tests de référence fournis par DeepSeek, ce nouveau modèle surpasse les modèles open source leaders, y compris Llama 3.1-405B de Meta, et se rapproche des performances des modèles propriétaires d'Anthropic et d'OpenAI.

Le lancement de DeepSeek-V3 marque une réduction de l'écart entre l'IA open source et l'IA propriétaire. DeepSeek, initialement une branche du fonds spéculatif quantitatif chinois High-Flyer Capital Management, espère que ces avancées ouvriront la voie à une intelligence artificielle générale (AGI), où les modèles pourront comprendre ou apprendre toute tâche intellectuelle réalisable par un humain.

Les principales caractéristiques de DeepSeek-V3 incluent :

Comme son prédécesseur, DeepSeek-V2, le nouveau modèle repose sur l'architecture de base de l'attention potentielle multi-têtes (MLA) et de DeepSeekMoE, garantissant ainsi un entraînement et une inférence efficaces.

L'entreprise a également introduit deux innovations : une stratégie d'équilibrage de charge sans perte auxiliaire et la prédiction multi-jetons (MTP). Cette dernière permet au modèle de prédire simultanément plusieurs jetons futurs, améliorant ainsi l'efficacité de l'entraînement et multipliant par trois la vitesse d'exécution du modèle, générant 60 jetons par seconde.

Lors de la phase de pré-entraînement, DeepSeek-V3 a été entraîné sur 14,8 T de jetons de haute qualité et diversifiés, et a subi deux phases d'extension de la longueur du contexte. Il a ensuite bénéficié d'un réglage fin supervisé (SFT) et d'un apprentissage par renforcement (RL) pour l'aligner sur les préférences humaines et libérer davantage son potentiel.

Pendant la phase d'entraînement, DeepSeek a utilisé plusieurs optimisations matérielles et algorithmiques, notamment un framework d'entraînement de précision mixte FP8 et l'algorithme DualPipe pour le parallélisme pipeline, réduisant ainsi les coûts d'entraînement. L'ensemble du processus d'entraînement de DeepSeek-V3 aurait été réalisé en 2 788 000 heures GPU H800, soit environ 5,57 millions de dollars, un coût bien inférieur aux centaines de millions de dollars généralement utilisés pour le pré-entraînement des grands modèles linguistiques.

DeepSeek-V3 est devenu l'un des modèles open source les plus performants du marché. De nombreux tests de référence menés par l'entreprise montrent qu'il surpasse GPT-4o propriétaire sur la plupart des benchmarks, à l'exception de SimpleQA et FRAMES, centrés sur l'anglais, où le modèle OpenAI obtient respectivement des scores de 38,2 et 80,5 (contre 24,9 et 73,3 pour DeepSeek-V3). DeepSeek-V3 excelle particulièrement dans les tests de référence en chinois et en mathématiques, obtenant un score de 90,2 au test Math-500, suivi de Qwen avec 80 points.

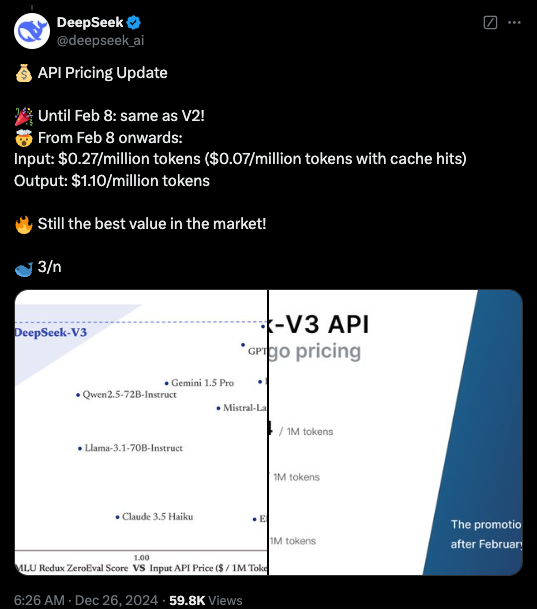

Actuellement, le code de DeepSeek-V3 est disponible sur GitHub sous licence MIT, et le modèle est fourni sous la licence de modèle de l'entreprise. Les entreprises peuvent également tester le nouveau modèle via DeepSeek Chat (une plateforme similaire à ChatGPT) et accéder à l'API pour un usage commercial. DeepSeek proposera l'API au même prix que DeepSeek-V2 jusqu'au 8 février. Par la suite, des frais de 0,27 $ par million de jetons d'entrée (0,07 $ par million de jetons pour les accès en cache) et de 1,10 $ par million de jetons de sortie seront appliqués.

Points clés :

🌟 Lancement de DeepSeek-V3, performances supérieures à Llama et Qwen.

🔧 Utilisation de 671 milliards de paramètres et d'une architecture de mélange d'experts pour une meilleure efficacité.

🚀 Innovations incluant une stratégie d'équilibrage de charge sans perte et une prédiction multi-jetons pour une vitesse accrue.

💼 Réduction significative des coûts d'entraînement, stimulant le développement de l'IA open source.