Pour conclure son année, la société chinoise de technologie Zhipu AI a lancé GLM-Zero-Preview, la première version de son modèle d'inférence GLM-Zero, entraîné à l'aide d'une technique d'apprentissage par renforcement étendu. Ce modèle se concentre sur l'amélioration des capacités de raisonnement de l'intelligence artificielle, excellant particulièrement en logique mathématique, en codage et en résolution de problèmes complexes nécessitant une inférence approfondie. Par rapport aux modèles de base, GLM-Zero-Preview conserve ses capacités de tâches générales tout en améliorant considérablement ses performances sur les tâches expertes. Ses résultats aux évaluations AIME2024, MATH500 et LiveCodeBench sont comparables à ceux du modèle OpenAI o1-preview.

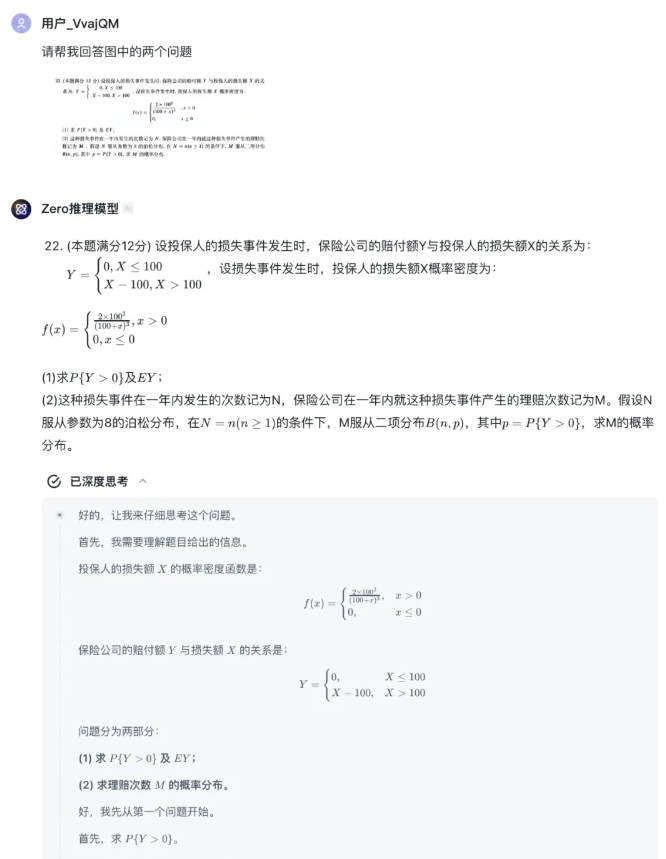

Les utilisateurs peuvent désormais tester gratuitement GLM-Zero-Preview sur la plateforme Zhipu Qingyan, dans l'agent "Modèle d'inférence Zero". Cette plateforme prend en charge le téléchargement de texte et d'images, le modèle fournissant un processus d'inférence complet. Les développeurs peuvent également accéder à ce modèle via l'API de la plateforme ouverte Zhipu.

Bien que GLM-Zero-Preview présente encore un certain écart par rapport au modèle o3 d'OpenAI, Zhipu AI prévoit d'optimiser et d'itérer continuellement sa technique d'apprentissage par renforcement, et s'apprête à lancer la version officielle de GLM-Zero, étendant ainsi sa capacité de réflexion approfondie de la logique mathématique à un plus large éventail de domaines techniques.

En termes de performances, GLM-Zero-Preview démontre l'importance de l'apprentissage par renforcement pour améliorer les capacités d'inférence approfondie des modèles. Avec l'augmentation de la quantité de données d'entraînement, les performances du modèle en matière d'inférence approfondie s'améliorent régulièrement. La loi d'échelle (scaling law) lors de la phase d'inférence a également été vérifiée : plus le nombre de jetons que le modèle peut traiter est important et plus le volume de calcul est élevé, meilleure est la qualité des résultats. GLM-Zero-Preview est capable de prendre des décisions autonomes, de décomposer les problèmes et d'essayer différentes méthodes de résolution, imitant ainsi le processus de pensée et de décision humain.

Dans des cas concrets, GLM-Zero-Preview a démontré sa capacité à identifier les failles logiques et à simuler plusieurs hypothèses en matière de raisonnement logique. En mathématiques, le modèle possède de solides capacités d'induction et de déduction, capable de traiter rapidement des calculs mathématiques complexes et d'atteindre le niveau d'un excellent étudiant en master lors d'un test de mathématiques de niveau 1 du concours d'entrée à l'université de 2025. En programmation, GLM-Zero-Preview maîtrise plusieurs langages de programmation et aide les développeurs à écrire du code rapidement.

Zhipu Qingyan :

https://chatglm.cn/main/gdetail/676411c38945bbc58a905d31?lang=zh

Plateforme ouverte Zhipu :

https://bigmodel.cn/dev/api/normal-model/glm-zero-preview