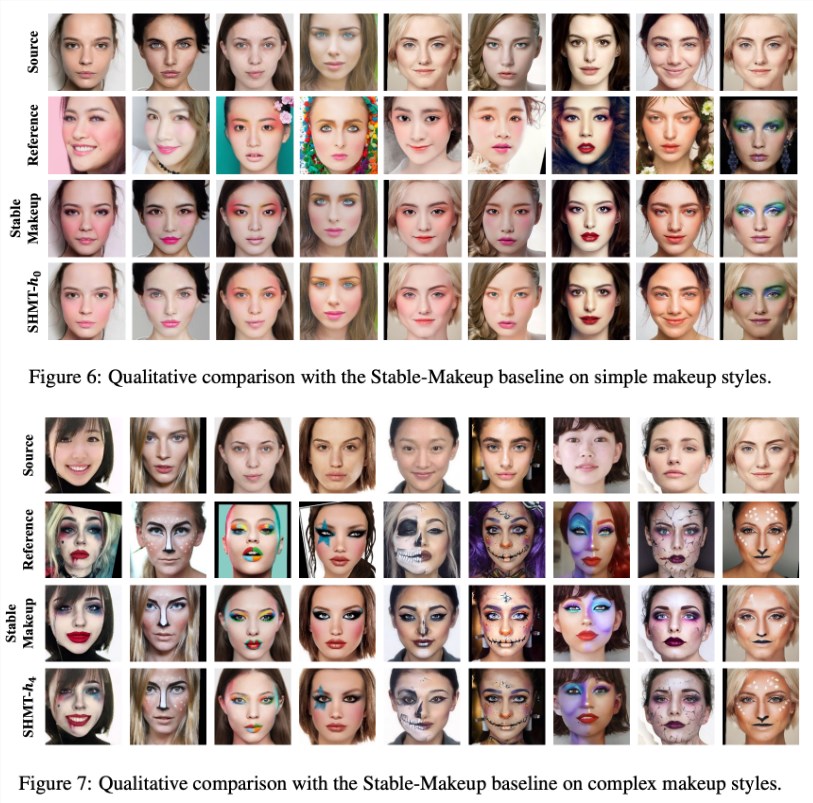

Récemment, l'équipe de recherche du laboratoire de recherche d'Alibaba, le Darmoyuan, a publié une importante avancée scientifique intitulée « SHMT : transfert hiérarchique de maquillage auto-supervisé ». Cet article a été accepté par la conférence académique de premier plan NeurIPS2024. Cette recherche présente une nouvelle technique de transfert d'effets de maquillage, utilisant des modèles de diffusion latente (Latent Diffusion Models) pour générer des images de maquillage avec précision, insufflant une nouvelle vitalité aux applications de maquillage et au traitement d'images.

En termes simples, SHMT est une technique de transfert de maquillage. Avec une image de référence maquillée et une photo d'une personne cible, il est possible de transférer l'effet du maquillage sur le visage de cette personne.

L'équipe a adopté une approche open source pour ce projet, publiant le code d'entraînement, le code de test et les modèles pré-entraînés, permettant ainsi aux chercheurs de mener plus facilement des recherches et des développements.

Lors de la création du modèle, l'équipe recommande aux utilisateurs de créer un environnement conda nommé « ldm » et d'utiliser le fichier d'environnement fourni pour une configuration rapide. De plus, la recherche a utilisé VQ-f4 comme modèle d'auto-encodage pré-entraîné. Les utilisateurs doivent le télécharger et le placer dans le dossier de points de contrôle spécifié pour pouvoir commencer l'inférence.

La préparation des données est essentielle au bon fonctionnement du modèle SHMT. L'équipe de recherche recommande de télécharger le jeu de données de transfert de maquillage fourni par « BeautyGAN » et d'intégrer les différentes images maquillées et non maquillées. La préparation de l'analyse faciale et des données faciales 3D est également cruciale. Les outils et les chemins de données associés sont détaillés dans la recherche pour garantir une préparation efficace des données par les utilisateurs.

Pour l'entraînement et l'inférence du modèle, l'équipe fournit des scripts de ligne de commande détaillés. Les utilisateurs peuvent ajuster les paramètres en fonction de leurs besoins. L'équipe souligne également l'importance de la structure des données et fournit un exemple clair de structure de répertoire pour guider les utilisateurs dans la préparation des données.

Le lancement du modèle SHMT marque le succès de l'application de l'apprentissage auto-supervisé dans le domaine du transfert d'effets de maquillage. Il pourrait à l'avenir trouver une large application dans les secteurs de la beauté, du maquillage et du traitement d'images. Cette recherche met non seulement en évidence le potentiel de la technologie, mais jette également des bases solides pour des recherches plus approfondies dans ce domaine.

Accès au projet : https://github.com/Snowfallingplum/SHMT

Points clés :

1. 🎓 Le modèle SHMT utilise des modèles de diffusion latente pour transférer les effets de maquillage et a été accepté par NeurIPS2024.

2. 🔧 L'équipe fournit le code source complet et les modèles pré-entraînés pour faciliter l'application et l'amélioration par les chercheurs.

3. 📂 La préparation des données et l'ajustement des paramètres sont essentiels. La recherche fournit des instructions détaillées sur les procédures et la structure des répertoires.