ByteDance a récemment publié LatentSync, un nouveau framework de synchronisation labiale qui vise à réaliser une synchronisation labiale plus précise en utilisant un modèle de diffusion latent conditionnel à l'audio. Ce framework est basé sur Stable Diffusion et optimisé pour la cohérence temporelle.

Contrairement aux méthodes précédentes basées sur la diffusion de l'espace pixel ou la génération en deux étapes, LatentSync adopte une approche de bout en bout, sans représentation de mouvement intermédiaire, permettant de modéliser directement la relation complexe entre l'audio et la vidéo.

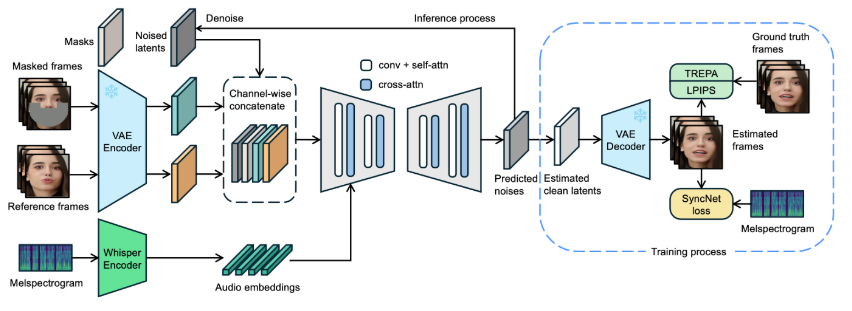

Dans le cadre de LatentSync, Whisper est d'abord utilisé pour convertir le spectrogramme audio en plongement audio, qui est ensuite intégré au modèle U-Net via une couche d'attention croisée. Le framework utilise la concaténation au niveau des canaux de l'image de référence, de l'image masquée et de la variable latente bruitée comme entrée du U-Net.

Pendant l'entraînement, une méthode en une seule étape est utilisée pour estimer la variable latente propre à partir du bruit prédit, puis décodée pour générer l'image propre. Simultanément, le modèle introduit le mécanisme Temporal REPresentation Alignment (TREPA) pour améliorer la cohérence temporelle, garantissant que la vidéo générée est à la fois précise en termes de synchronisation labiale et cohérente dans le temps.

Pour illustrer l'efficacité de cette technologie, le projet fournit une série de vidéos d'exemple montrant à la fois la vidéo originale et la vidéo traitée avec la synchronisation labiale. Ces exemples permettent aux utilisateurs de constater visuellement les progrès significatifs de LatentSync en matière de synchronisation labiale vidéo.

Vidéo originale :

Vidéo de sortie :

De plus, le projet prévoit de rendre publique le code d'inférence et les points de contrôle, afin de faciliter l'entraînement et les tests des utilisateurs. Pour les utilisateurs souhaitant essayer l'inférence, il suffit de télécharger les fichiers de poids du modèle nécessaires. Le processus complet de traitement des données est également conçu, couvrant toutes les étapes, du traitement des fichiers vidéo à l'alignement du visage, pour garantir une prise en main facile pour les utilisateurs.

Accès au projet : https://github.com/bytedance/LatentSync

Points clés :

🌟 LatentSync est un framework de synchronisation labiale de bout en bout basé sur un modèle de diffusion latent conditionnel à l'audio, sans représentation de mouvement intermédiaire.

🎤 Ce framework utilise Whisper pour convertir le spectrogramme audio en plongement, améliorant ainsi la précision et la cohérence temporelle du modèle lors de la synchronisation labiale.

📹 Le projet fournit une série de vidéos d'exemple et prévoit de rendre public le code et le processus de traitement des données, facilitant ainsi l'utilisation et l'entraînement pour les utilisateurs.