Mistral vient d'annoncer le lancement de son dernier modèle de codage open source : Codestral25.01, une mise à niveau de son populaire modèle de codage Codestral. Cette version, optimisée au niveau de son architecture, offre des performances considérablement améliorées, faisant de lui le « leader évident du codage intensif », avec une vitesse deux fois supérieure à la version précédente.

Similaire au Codestral original, Codestral25.01 reste axé sur les opérations à faible latence et haute fréquence, prenant en charge la correction de code, la génération de tests et les tâches de remplissage intermédiaire. Mistral affirme que cette version est particulièrement adaptée aux entreprises nécessitant davantage de données et de résidence de modèles. Les tests de référence montrent que Codestral25.01 a dépassé les attentes lors des tests de codage Python, obtenant un score de 86,6 % au test HumanEval, surpassant largement la version précédente, Codellama70B Instruct et DeepSeek Coder33B Instruct.

Les développeurs peuvent accéder au modèle via le plugin Mistral IDE et l'outil de déploiement local Continue. Mistral propose également un accès via les API Google Vertex AI et Mistral la Plateforme. Le modèle est actuellement disponible en préversion sur Azure AI Foundry et sera bientôt disponible sur la plateforme Amazon Bedrock.

Depuis son lancement l'année dernière, Codestral de Mistral est devenu un leader parmi les modèles open source axés sur le code. La première version de Codestral, un modèle à 22 milliards de paramètres, prend en charge jusqu'à 80 langages et surpasse de nombreuses solutions concurrentes en termes de performances de codage. Par la suite, Mistral a lancé Codestral-Mamba, un modèle de génération de code basé sur l'architecture Mamba, capable de gérer des chaînes de code plus longues et de répondre à des demandes d'entrée plus importantes.

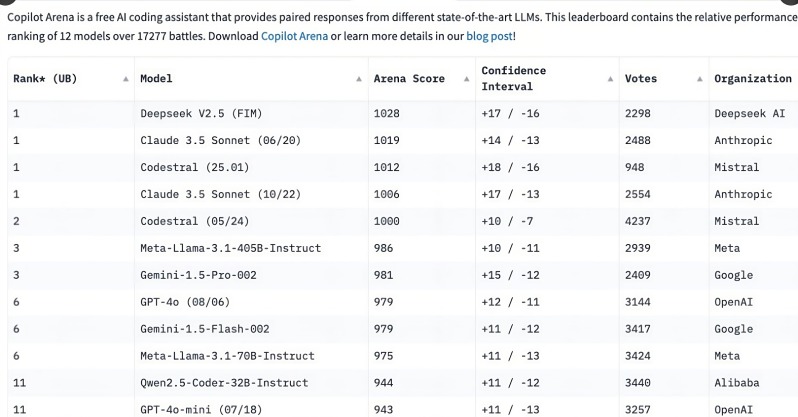

Le lancement de Codestral25.01 a suscité un vif intérêt de la part des développeurs, se classant parmi les premiers du classement C o pilot Arena quelques heures seulement après sa sortie. Cette tendance montre que les modèles de codage spécialisés deviennent rapidement les préférés des développeurs, notamment dans le domaine des tâches de codage, la demande de modèles de codage spécialisés étant de plus en plus importante par rapport aux modèles polyvalents.

Bien que des modèles polyvalents tels que o3 d'OpenAI et Claude d'Anthropic puissent également coder, les modèles de codage spécialement optimisés offrent généralement des performances supérieures. Au cours de l'année écoulée, plusieurs entreprises ont publié des modèles spécialisés pour le codage, tels que Qwen2.5-Coder d'Alibaba et le DeepSeek Coder chinois, ce dernier étant le premier à surpasser GPT-4 Turbo. Microsoft a également lancé GRIN-MoE, un modèle basé sur un mélange d'experts (MOE), capable non seulement de coder, mais aussi de résoudre des problèmes mathématiques.

Bien que les développeurs débattent encore du choix entre les modèles polyvalents et les modèles spécialisés, la rapide ascension des modèles de codage met en évidence l'énorme besoin d'outils de codage efficaces et précis. Grâce à son avantage d'être entraîné spécifiquement pour les tâches de codage, Codestral25.01 occupera sans aucun doute une place de choix dans le domaine du codage à venir.