Avec le développement rapide de la technologie vidéo, la vidéo est devenue un outil essentiel pour la recherche d'informations et la compréhension de concepts complexes. Combinant données visuelles, temporelles et contextuelles, la vidéo offre une représentation multimodale dépassant les images statiques et le texte. Aujourd'hui, avec la popularisation des plateformes de partage vidéo et l'émergence d'un grand nombre de vidéos éducatives et informatives, l'utilisation de la vidéo comme source de connaissance offre des opportunités sans précédent pour répondre aux requêtes nécessitant un contexte détaillé, une compréhension spatiale et une démonstration de processus.

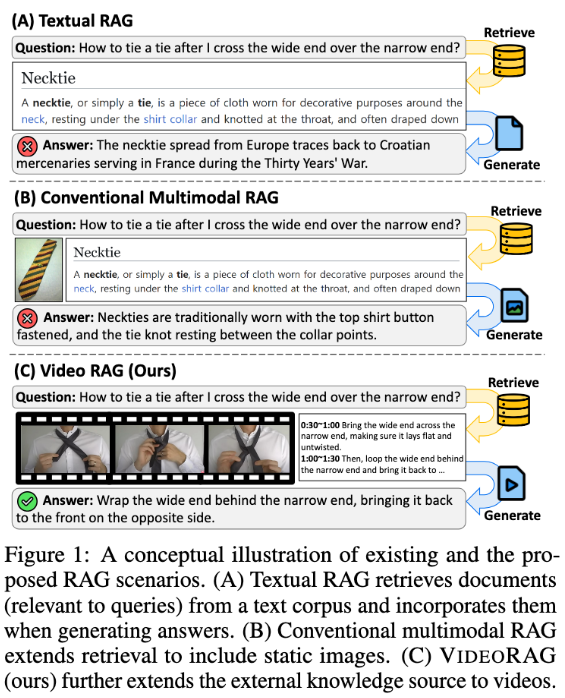

Cependant, les systèmes de génération augmentée par la recherche (RAG) existants négligent souvent le potentiel complet des données vidéo. Ces systèmes s'appuient généralement sur des informations textuelles, utilisant occasionnellement des images statiques pour étayer les réponses aux requêtes, mais ils ne parviennent pas à capturer la dynamique visuelle et les indices multimodaux contenus dans la vidéo, pourtant cruciaux pour les tâches complexes. Les méthodes traditionnelles, soit pré-définissent les vidéos pertinentes pour la requête sans recherche, soit convertissent la vidéo en format texte, perdant ainsi le contexte visuel important et la dynamique temporelle, limitant ainsi la capacité à fournir des réponses précises et riches en informations.

Pour résoudre ces problèmes, une équipe de recherche du Korea Advanced Institute of Science and Technology (KAIST) et de DeepAuto.ai propose un nouveau framework : VideoRAG. Ce framework permet de rechercher dynamiquement les vidéos pertinentes pour une requête et d'intégrer les informations visuelles et textuelles dans le processus de génération. VideoRAG utilise des grands modèles linguistiques vidéo (LVLMs) de pointe pour une intégration transparente des données multimodales, garantissant la cohérence des vidéos récupérées avec le contexte de la requête de l'utilisateur et préservant la richesse temporelle du contenu vidéo.

Le processus de VideoRAG se divise en deux phases principales : la recherche et la génération. Dans la phase de recherche, le framework identifie les vidéos similaires à la requête en fonction de leurs caractéristiques visuelles et textuelles.

Dans la phase de génération, la reconnaissance automatique de la parole (ASR) est utilisée pour générer des données textuelles auxiliaires pour les vidéos sans sous-titres, garantissant ainsi que toutes les vidéos récupérées contribuent efficacement à la génération de la réponse. Les vidéos récupérées sont ensuite introduites dans le module de génération, intégrant des données multimodales telles que les images vidéo, les sous-titres et le texte de la requête. Le traitement par les LVLMs permet de générer des réponses longues, riches, précises et contextuellement appropriées.

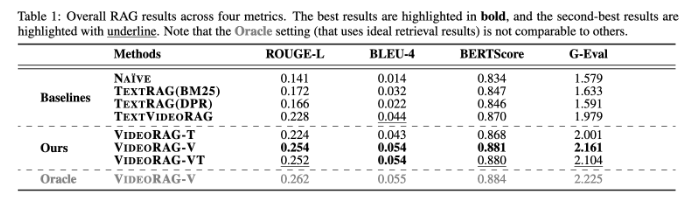

VideoRAG a été testé de manière approfondie sur des ensembles de données tels que WikiHowQA et HowTo100M, les résultats montrant une qualité de réponse nettement supérieure aux méthodes traditionnelles. Ce nouveau framework améliore non seulement les capacités des systèmes de génération augmentée par la recherche, mais établit également une nouvelle norme pour les futurs systèmes de recherche multimodale.

Article : https://arxiv.org/abs/2501.05874

Points clés :

📹 ** Nouveau framework :** VideoRAG recherche dynamiquement les vidéos pertinentes et fusionne les informations visuelles et textuelles pour améliorer les résultats de la génération.

🔍 ** Validation expérimentale :** Testé sur plusieurs ensembles de données, il montre une qualité de réponse nettement supérieure aux méthodes RAG traditionnelles.

🌟 ** Innovation technologique :** Grâce aux grands modèles linguistiques vidéo, VideoRAG ouvre une nouvelle ère pour l'intégration des données multimodales.