Le 20 janvier 2025, DeepSeek a annoncé le lancement de son premier modèle d'inférence entraîné par apprentissage par renforcement (RL), DeepSeek-R1, qui a atteint des performances comparables à celles d'OpenAI-o1-1217 dans plusieurs benchmarks d'inférence. DeepSeek-R1 est basé sur le modèle DeepSeek-V3-Base et utilise un entraînement en plusieurs étapes et des données de démarrage à froid pour améliorer ses capacités d'inférence.

Les chercheurs de DeepSeek ont d'abord développé DeepSeek-R1-Zero, un modèle entièrement entraîné par apprentissage par renforcement à grande échelle, sans étape de pré-réglage de réglage fin supervisé. DeepSeek-R1-Zero a démontré des performances exceptionnelles dans les benchmarks d'inférence, par exemple, dans l'examen AIME2024, son score pass@1 est passé de 15,6 % à 71,0 %.Cependant, DeepSeek-R1-Zero présentait également certains problèmes, tels qu'une mauvaise lisibilité et un mélange de langues.

Pour résoudre ces problèmes et améliorer encore les performances d'inférence, l'équipe DeepSeek a développé DeepSeek-R1. DeepSeek-R1 introduit un entraînement en plusieurs étapes et des données de démarrage à froid avant l'apprentissage par renforcement. Plus précisément, les chercheurs ont d'abord collecté des milliers de paires de données de démarrage à froid pour affiner le modèle DeepSeek-V3-Base. Ensuite, ils ont effectué un apprentissage par renforcement orienté inférence, comme pour l'entraînement de DeepSeek-R1-Zero. Lorsque le processus d'apprentissage par renforcement était proche de la convergence, ils ont créé de nouvelles données de réglage fin supervisé en effectuant un échantillonnage par rejet sur les points de contrôle de l'apprentissage par renforcement, et les ont combinées avec les données supervisées de DeepSeek-V3 dans des domaines tels que l'écriture, la Q&R factuelle et la métacognition, puis ont réentraîné le modèle DeepSeek-V3-Base. Enfin, un apprentissage par renforcement supplémentaire a été effectué sur le point de contrôle finement réglé en utilisant des invites de tous les scénarios.

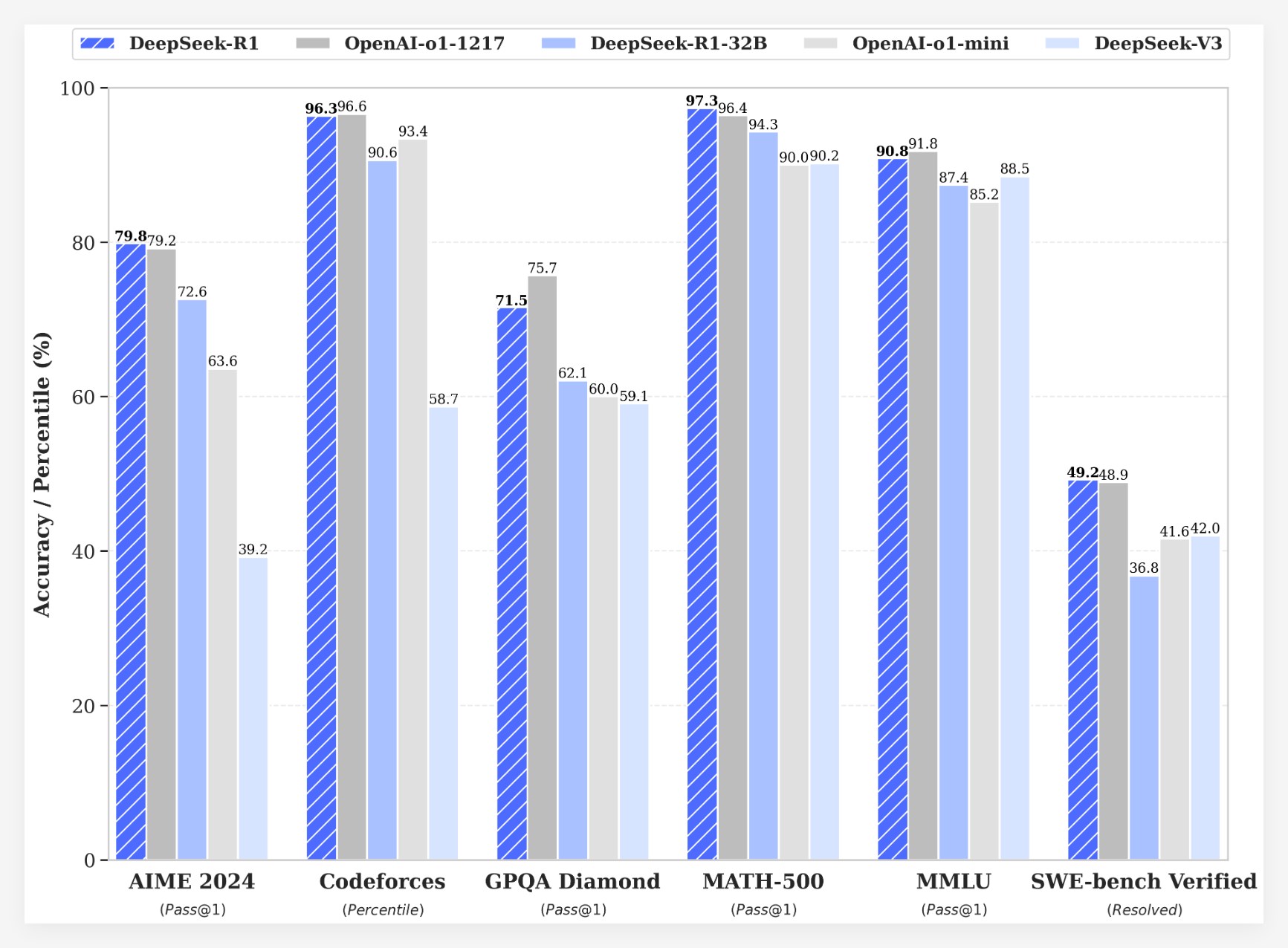

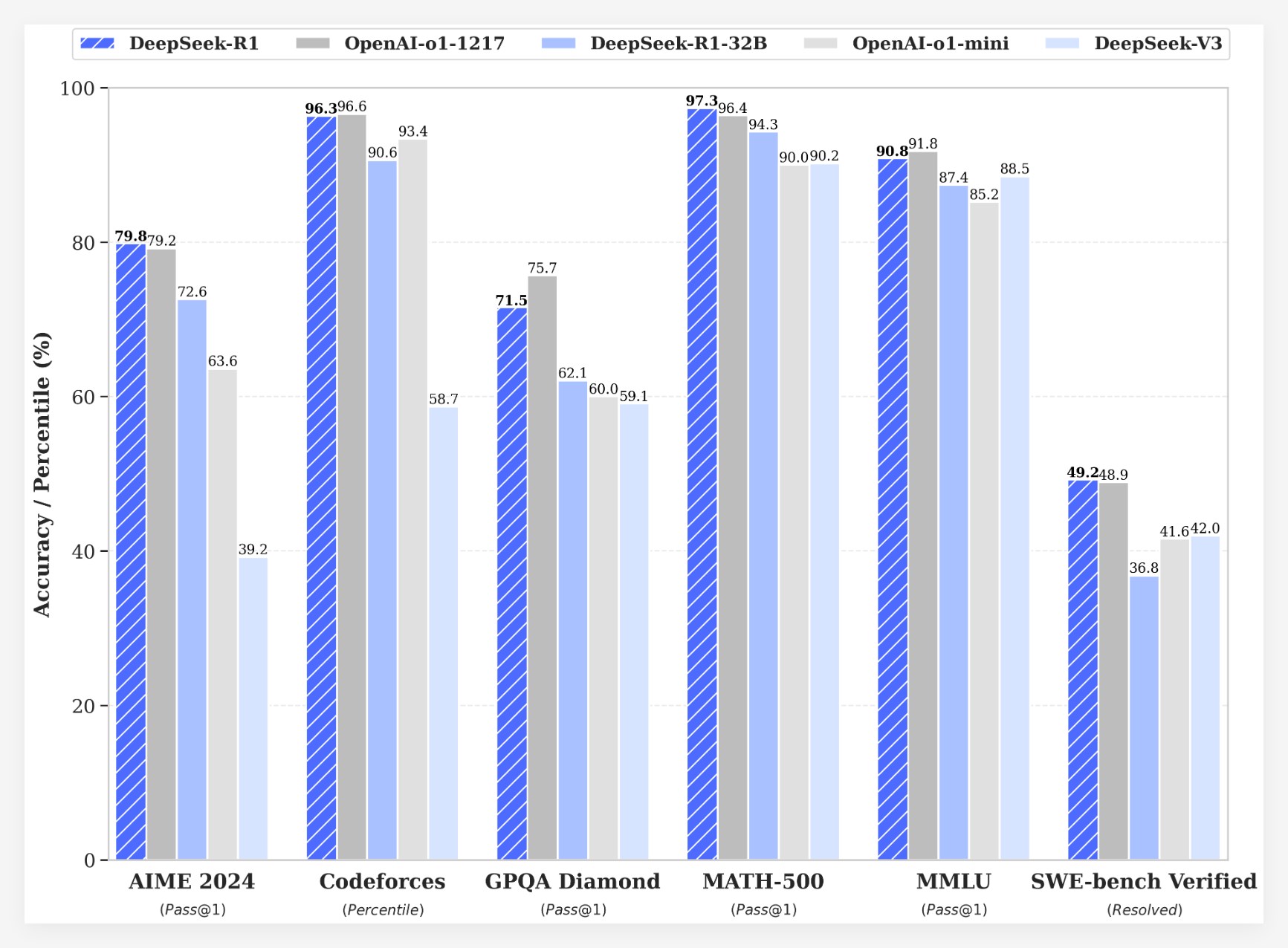

DeepSeek-R1 a obtenu des résultats remarquables dans plusieurs benchmarks :

• Dans l'examen AIME2024, le score pass@1 de DeepSeek-R1 a atteint 79,8 %, légèrement supérieur à celui d'OpenAI-o1-1217.

• Dans l'examen MATH-500, le score pass@1 de DeepSeek-R1 a atteint 97,3 %, au même niveau que celui d'OpenAI-o1-1217.

• Dans les tâches de concours de codage, DeepSeek-R1 a obtenu un classement Elo de 2029 sur Codeforces, dépassant 96,3 % des participants humains.

• Dans les benchmarks de connaissances (tels que MMLU, MMLU-Pro et GPQA Diamond), DeepSeek-R1 a obtenu des scores de 90,8 %, 84,0 % et 71,5 % respectivement, nettement supérieurs à ceux de DeepSeek-V3.

• DeepSeek-R1 a également excellé dans d'autres tâches (telles que la rédaction créative, la Q&R générale, l'édition, la synthèse, etc.).

De plus, DeepSeek a exploré la distillation des capacités d'inférence de DeepSeek-R1 dans des modèles plus petits. Les recherches ont révélé que la distillation directe de DeepSeek-R1 était plus efficace que l'application de l'apprentissage par renforcement sur des modèles plus petits. Cela indique que les schémas d'inférence découverts par les grands modèles de base sont essentiels pour améliorer les capacités d'inférence.DeepSeek a open-sourcé DeepSeek-R1-Zero, DeepSeek-R1 et six modèles denses (1,5 B, 7 B, 8 B, 14 B, 32 B, 70 B) distillés à partir de DeepSeek-R1 basés sur Qwen et Llama. Le lancement de DeepSeek-R1 marque une avancée significative de l'apprentissage par renforcement dans l'amélioration des capacités d'inférence des grands modèles de langage.

Avantages en termes de coûts

En termes de coûts, DeepSeek-R1 offre une stratégie de tarification extrêmement compétitive. L'accès à l'API est tarifé à 0,14 $ par million de jetons d'entrée (accès au cache) et 0,55 $ (accès au cache manquant), et les jetons de sortie coûtent 2,19 $ par million. Cette stratégie de tarification est plus attrayante que celle des produits concurrents et a été qualifiée de « changeur de jeu » par les utilisateurs. Le site Web officiel et l'API sont désormais en ligne ! Visitez https://chat.deepseek.com pour découvrir DeepThink !

Retour d'information de la communauté et perspectives d'avenir

La sortie de DeepSeek-R1 a suscité de vives discussions au sein de la communauté. De nombreux utilisateurs ont salué la nature open source du modèle et ses avantages en termes de coûts, estimant qu'il offrait aux développeurs plus de choix et de liberté. Cependant, certains utilisateurs ont également soulevé des questions concernant la taille de la fenêtre contextuelle du modèle, souhaitant une amélioration dans les versions futures.

L'équipe DeepSeek a déclaré qu'elle continuerait à s'efforcer d'améliorer les performances et l'expérience utilisateur du modèle, et prévoit de lancer de nouvelles fonctionnalités à l'avenir, notamment l'analyse de données avancée, afin de répondre aux attentes des utilisateurs en matière d'AGI (intelligence artificielle générale).