Hugging Face a lancé un modèle d'IA remarquable : SmolVLM. Ce modèle de langage visuel est si compact qu'il peut fonctionner sur des appareils mobiles et autres petits dispositifs, surpassant les performances de ses prédécesseurs qui nécessitaient de grands centres de données.

Le modèle SmolVLM-256M nécessite moins de 1 Go de mémoire GPU, tout en surpassant son prédécesseur, Idefics80B, 300 fois plus volumineux. Ceci représente une avancée majeure pour le déploiement d'une IA pratique.

Selon Andrés Mallafioti, ingénieur de recherche en apprentissage automatique chez Hugging Face, SmolVLM permet aux entreprises de réduire considérablement leurs coûts de calcul. « Idefics80B, lancé en août 2023, était le premier modèle de langage vidéo open source. SmolVLM représente une réduction de volume de 300 fois, tout en améliorant les performances », a déclaré Mallafioti dans une interview accordée au Journal des Entrepreneurs.

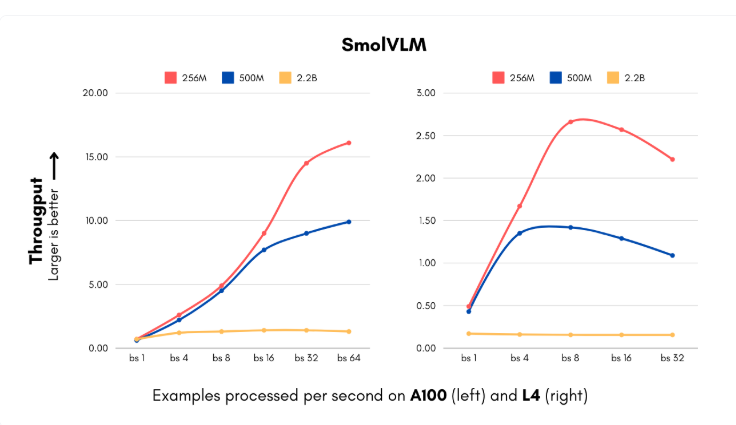

Le lancement de SmolVLM intervient à un moment crucial où les entreprises sont confrontées à des coûts de calcul élevés pour la mise en œuvre de systèmes d'intelligence artificielle. Ce nouveau modèle, disponible en deux tailles (256M et 500M de paramètres), traite les images et comprend le contenu visuel à une vitesse inégalée. La version la plus petite peut traiter jusqu'à 16 instances par seconde, avec seulement 15 Go de mémoire, ce qui est idéal pour les entreprises qui traitent de grandes quantités de données visuelles. Pour une entreprise de taille moyenne traitant 1 million d'images par mois, cela représente des économies de coûts de calcul annuelles considérables.

De plus, IBM a collaboré avec Hugging Face pour intégrer le modèle 256M dans son logiciel de traitement de documents, Docling. Même si IBM dispose de ressources informatiques importantes, l'utilisation d'un modèle plus petit lui permet de traiter efficacement des millions de documents à moindre coût.

L'équipe Hugging Face a réussi à réduire la taille du modèle sans perte de performance grâce à des innovations techniques dans le traitement visuel et les composants linguistiques. Ils ont remplacé l'encodeur visuel initial de 400 millions de paramètres par une version de 93 millions de paramètres et ont mis en œuvre une technique de compression de jetons plus agressive. Ces innovations permettent aux petites entreprises et aux startups de lancer des produits de vision par ordinateur complexes en peu de temps, avec une réduction significative des coûts d'infrastructure.

L'ensemble de données d'entraînement de SmolVLM comprend 170 millions d'exemples, dont près de la moitié sont utilisés pour le traitement de documents et l'annotation d'images. Ces avancées réduisent non seulement les coûts, mais offrent également de nouvelles possibilités d'application aux entreprises, améliorant considérablement leurs capacités de recherche visuelle.

Cette avancée de Hugging Face remet en question la vision traditionnelle de la relation entre la taille du modèle et ses performances. SmolVLM démontre que des architectures petites et efficaces peuvent également offrir d'excellentes performances. L'avenir de l'IA ne consistera peut-être plus à rechercher des modèles toujours plus grands, mais plutôt des systèmes plus flexibles et efficaces.

Modèle : https://huggingface.co/blog/smolervlm

Points clés :

🌟 Le modèle SmolVLM de Hugging Face fonctionne sur les téléphones portables et surpasse le modèle Idefics80B, 300 fois plus grand.

💰 SmolVLM permet aux entreprises de réduire considérablement leurs coûts de calcul, avec une vitesse de traitement de 16 instances par seconde.

🚀 Les innovations techniques de ce modèle permettent aux petites entreprises et aux startups de lancer rapidement des produits de vision par ordinateur complexes.