Selon un message officiel publié sur le compte public WeChat de l'équipe de Doubao, le modèle expérimental de génération vidéo "VideoWorld", proposé par l'équipe de Doubao et développé conjointement par l'Université des transports de Beijing et l'Université des sciences et technologies de Chine, a été officiellement mis en open source.

Le point fort principal de ce modèle réside dans le fait qu'il ne repose plus sur les modèles linguistiques traditionnels, mais qu'il peut comprendre et appréhender le monde uniquement à partir d'informations visuelles. Cette recherche révolutionnaire s'inspire de l'idée de la professeure Fei-Fei Li, mentionnée dans une conférence TED, selon laquelle « les jeunes enfants peuvent comprendre le monde réel sans recourir au langage ».

"VideoWorld" réalise des capacités complexes de raisonnement, de planification et de prise de décision grâce à l'analyse et au traitement d'un grand nombre de données vidéo. Les expériences de l'équipe de recherche montrent que le modèle, avec seulement 300 millions de paramètres, a obtenu des résultats remarquables. Contrairement aux modèles existants qui dépendent du langage ou des données étiquetées, VideoWorld est capable d'apprendre de manière autonome, offrant une approche d'apprentissage particulièrement intuitive pour des tâches complexes comme l'origami ou le nouage d'une cravate.

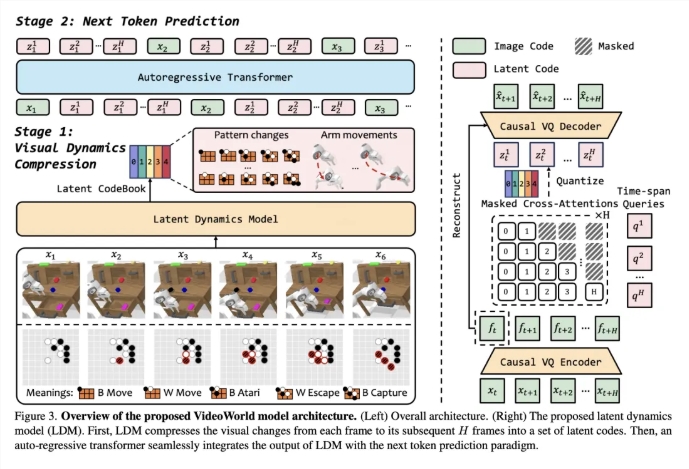

Pour valider l'efficacité du modèle, l'équipe de recherche a mis en place deux environnements expérimentaux : un jeu de Go et une simulation de contrôle robotique. Le jeu de Go, en tant que jeu hautement stratégique, permet d'évaluer efficacement les capacités d'apprentissage des règles et de raisonnement du modèle, tandis que les tâches robotiques testent ses performances en matière de contrôle et de planification. Durant la phase d'entraînement, le modèle établit progressivement une capacité de prédiction des images futures en observant de nombreuses démonstrations vidéo.

Afin d'améliorer l'efficacité de l'apprentissage vidéo, l'équipe a introduit un modèle dynamique latent (LDM), visant à compresser les variations visuelles entre les images vidéo afin d'extraire les informations clés. Cette méthode non seulement réduit les informations redondantes, mais améliore également l'efficacité d'apprentissage des connaissances complexes par le modèle. Grâce à cette innovation, VideoWorld a démontré d'excellentes capacités dans les jeux de Go et les tâches robotiques, atteignant même le niveau d'un joueur professionnel de Go 5 dan.

Lien de l'article : https://arxiv.org/abs/2501.09781

Lien du code : https://github.com/bytedance/VideoWorld

Page du projet : https://maverickren.github.io/VideoWorld.github.io

Points clés :

🌟 Le modèle "VideoWorld" permet l'apprentissage des connaissances uniquement à partir d'informations visuelles, sans recourir aux modèles linguistiques.

🤖 Le modèle démontre des capacités exceptionnelles de raisonnement et de planification dans les jeux de Go et les tâches de simulation robotique.

🔓 Le code et le modèle de ce projet sont open source. Nous invitons tous les acteurs à participer, à l'expérimenter et à échanger.