Le lancement récent du projet VLM-R1 a apporté un nouvel espoir dans ce domaine. Ce projet, qui représente la migration réussie de la méthode R1 de l'équipe DeepSeek aux modèles linguistiques visuels, marque une nouvelle ère pour la compréhension du contenu visuel par l'IA.

VLM-R1 s'inspire de la méthode R1 open-source de DeepSeek de l'année dernière, méthode qui utilise la technique d'apprentissage par renforcement GRPO (Generative Reward Processing Optimization) et a obtenu d'excellents résultats dans le traitement de texte pur. Aujourd'hui, l'équipe VLM-R1 a réussi à appliquer cette méthode aux modèles linguistiques visuels, ouvrant de nouvelles perspectives pour la recherche en IA multimodale.

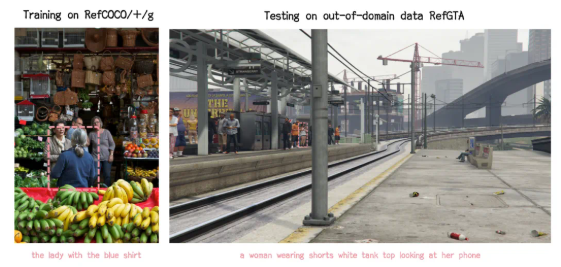

Les résultats de validation du projet VLM-R1 sont impressionnants. Premièrement, la méthode R1 a démontré une stabilité remarquable dans des scénarios complexes, ce qui est crucial pour les applications réelles. Deuxièmement, le modèle a fait preuve d'une excellente capacité de généralisation. Dans les expériences comparatives, les modèles SFT (Supervised Fine-Tuning) traditionnels ont vu leurs performances diminuer avec l'augmentation du nombre d'étapes d'entraînement sur des données de test hors domaine, tandis que le modèle R1 a continué à s'améliorer pendant l'entraînement. Cela indique que la méthode R1 permet au modèle de réellement comprendre le contenu visuel, et non pas simplement de se fier à la mémorisation.

De plus, VLM-R1 est très facile à utiliser. L'équipe a fourni aux développeurs un processus complet d'entraînement et d'évaluation, leur permettant de se familiariser rapidement avec le système. Dans un cas d'utilisation concret, le modèle a été chargé de trouver l'aliment le plus riche en protéines sur une image de repas copieux. Il a non seulement donné la bonne réponse, mais a également correctement identifié et encadré la galette aux œufs, l'aliment le plus riche en protéines sur l'image, démontrant ainsi ses capacités exceptionnelles de compréhension et de raisonnement visuel.

Le succès de VLM-R1 prouve non seulement la polyvalence de la méthode R1, mais offre également de nouvelles pistes pour l'entraînement des modèles multimodaux, annonçant une nouvelle tendance dans l'entraînement des modèles linguistiques visuels. Plus encourageant encore, ce projet est entièrement open-source, et les développeurs intéressés peuvent trouver les informations pertinentes sur GitHub.

En résumé, l'arrivée de VLM-R1 a insufflé une nouvelle dynamique à la recherche sur les modèles linguistiques visuels. Nous espérons que de nombreux développeurs participeront à ce projet pour faire progresser la technologie de l'IA multimodale.