La start-up japonaise d'intelligence artificielle Sakana AI a annoncé le lancement d'« AI CUDA Engineer », un système d'agent intelligent innovant conçu pour automatiser la production de noyaux CUDA hautement optimisés, améliorant ainsi considérablement l'efficacité des opérations d'apprentissage automatique. Selon les dernières nouvelles sur la plateforme X, ce système, basé sur une technologie d'optimisation de code pilotée par un grand modèle linguistique (LLM) évolutif, accélère la vitesse d'exécution des opérations PyTorch courantes de 10 à 100 fois, marquant une percée majeure de l'IA dans le domaine de l'optimisation des performances des GPU.

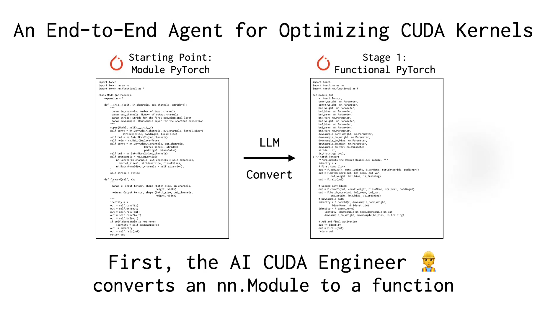

Sakana AI explique que les noyaux CUDA, étant au cœur du calcul GPU, nécessitent généralement des connaissances approfondies et un niveau de compétence élevé pour être écrits et optimisés manuellement. Les frameworks existants comme PyTorch, bien que faciles à utiliser, sont souvent inférieurs en termes de performances aux noyaux optimisés manuellement. « AI CUDA Engineer » résout ce problème grâce à un processus intelligent : il convertit automatiquement le code PyTorch en noyaux CUDA efficaces et optimise les performances à l'aide d'algorithmes évolutifs, pouvant même fusionner plusieurs noyaux pour améliorer encore l'efficacité d'exécution.

L'utilisateur X @shao__meng a comparé cette technologie à « l'ajout d'une boîte de vitesses automatique au développement de l'IA », permettant à un code ordinaire de « devenir automatiquement des performances de niveau course ». Un autre utilisateur, @FinanceYF5, a également souligné dans son message que le lancement de ce système démontre le potentiel de l'auto-optimisation de l'IA, susceptible de révolutionner l'efficacité future de l'utilisation des ressources informatiques.

Sakana AI s'est déjà fait remarquer dans le secteur grâce à des projets tels que « AI Scientist ». Le lancement d'« AI CUDA Engineer » met en évidence son ambition dans le domaine de l'automatisation de l'IA. La société affirme avoir généré et validé plus de 17 000 noyaux CUDA, couvrant diverses opérations PyTorch, et que les ensembles de données publics fourniront une ressource précieuse aux chercheurs et aux développeurs. Les experts du secteur estiment que cette technologie non seulement abaisse le seuil d'accès à la programmation GPU haute performance, mais pourrait également permettre aux modèles d'intelligence artificielle d'atteindre de nouveaux sommets en termes d'efficacité d'entraînement et de déploiement.

Référence : https://x.com/FinanceYF5/status/1892856847780237318