La société chinoise d'intelligence artificielle DeepSeek a annoncé le lancement de DeepGEMM, une bibliothèque open source prenant en charge la multiplication matricielle générale (GEMM) FP8, lors du troisième jour de sa « semaine open source ». Cet outil est spécialement conçu pour les calculs matriciels intensifs et les opérations matricielles d'experts mixtes (MoE), offrant un support puissant à l'entraînement et à l'inférence des modèles DeepSeek V3 et R1. L'annonce officielle, diffusée sur la plateforme X, a rapidement suscité un vif intérêt au sein de la communauté technique.

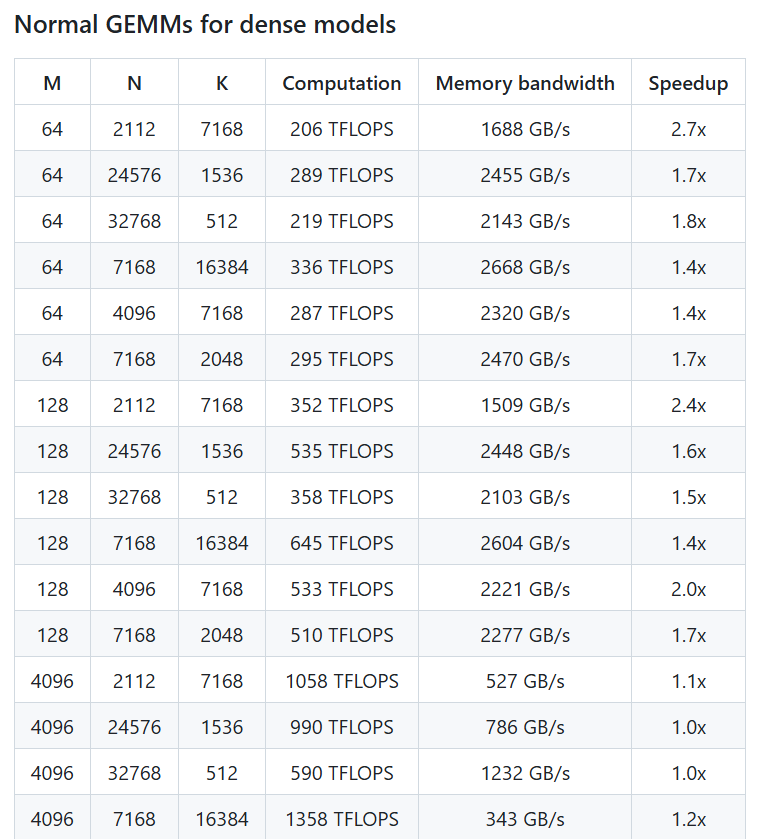

Selon un message publié par le compte officiel DeepSeek, DeepGEMM peut atteindre des performances de calcul FP8 allant jusqu'à 1350 + TFLOPS sur les GPU NVIDIA Hopper. Sa logique principale ne compte qu'environ 300 lignes de code, mais elle surpasse les noyaux optimisés par des experts sur la plupart des tailles de matrices, démontrant une efficacité et une simplicité exceptionnelles. Cette bibliothèque ne nécessite aucune dépendance complexe, utilise une technique de compilation juste-à-temps (Just-In-Time), prend en charge la disposition dense et deux dispositions MoE, et est conçue avec une « propreté digne d'un tutoriel », facilitant ainsi l'apprentissage et l'utilisation par les développeurs.

L'utilisateur X @TechBitDaily a commenté : « La sortie de DeepGEMM est un point culminant de la semaine open source de DeepSeek, ses performances FP8 et sa conception simple sont impressionnantes. » Un autre utilisateur, @AIObserverCN, a souligné que cette bibliothèque présente des avantages significatifs pour l'entraînement efficace des modèles MoE, et pourrait stimuler l'innovation au sein de la communauté IA sur l'architecture Hopper.

Dans le cadre de sa semaine open source, le lancement de DeepGEMM confirme l'engagement de DeepSeek en faveur de la transparence des technologies IA et de la collaboration communautaire. Au cours des deux premiers jours, la société avait déjà publié les outils FlashMLA et DeepEP, axés respectivement sur l'architecture des modèles linguistiques rapides et la communication parallèle des experts. La présentation de DeepGEMM démontre une fois de plus ses compétences techniques en matière de construction d'infrastructures IA. Les experts du secteur estiment que cette bibliothèque améliorera non seulement les performances des modèles DeepSeek, mais offrira également aux développeurs du monde entier un outil de calcul matriciel efficace et facile à utiliser, avec des perspectives d'application prometteuses. Les utilisateurs peuvent désormais obtenir DeepGEMM sur GitHub et explorer son potentiel dans l'entraînement et l'inférence IA.

Adresse du projet : https://github.com/deepseek-ai/DeepGEMM