Dans le contexte du développement rapide de l'intelligence artificielle (IA), l'équipe DeepSeek a lancé son nouveau système d'inférence DeepSeek-V3/R1. Ce système vise à stimuler le développement efficace de l'AGI (Intelligence Artificielle Générale) grâce à un débit plus élevé et une latence plus faible. Pour atteindre cet objectif, DeepSeek utilise la technique de parallélisme d'experts inter-nœuds (Expert Parallelism, EP), améliorant considérablement l'efficacité de calcul du GPU, augmentant la taille des lots tout en réduisant la latence.

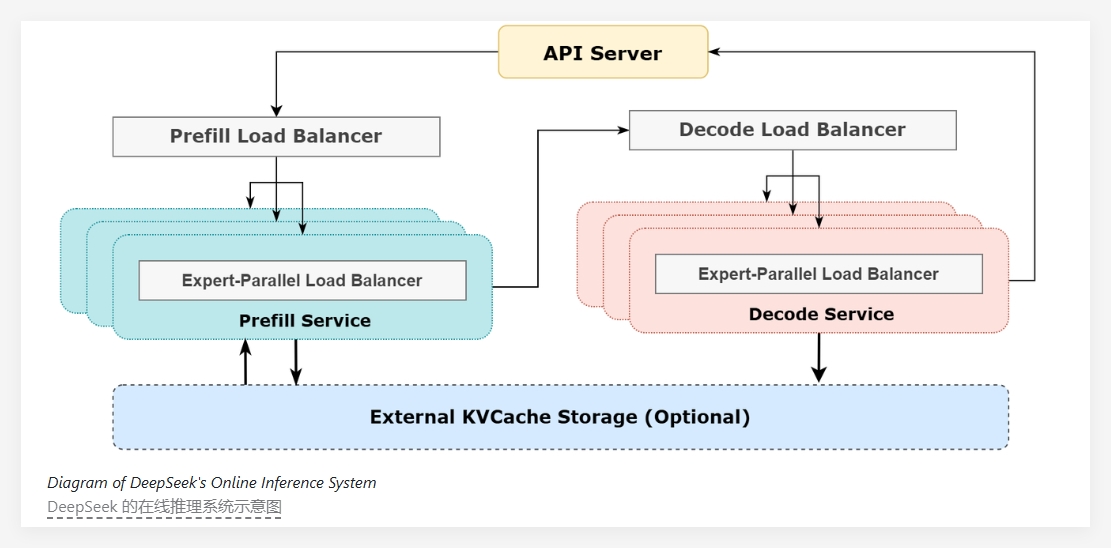

Le cœur de DeepSeek-V3/R1 réside dans son extrême sparsité : chaque couche du modèle n'active que 8 experts sur 256. Cela nécessite des tailles de lots très importantes pour garantir que chaque expert dispose de suffisamment de capacité de traitement. L'architecture du système utilise une méthode de désagrégation préremplissage-décodage (prefill-decode disaggregation), employant des stratégies de parallélisation différentes aux étapes de préremplissage et de décodage.

Au stade du préremplissage, le système utilise une stratégie de chevauchement à double lot pour masquer les coûts de communication. Cela signifie que les coûts de communication d'un lot sont masqués par le processus de calcul d'un autre lot, améliorant ainsi le débit global. Lors de la phase de décodage, pour résoudre le problème du déséquilibre temporel entre les différentes phases d'exécution, DeepSeek utilise un pipeline à cinq niveaux, permettant un chevauchement transparent entre la communication et le calcul.

Pour faire face aux problèmes de charge inégale liés au parallélisme à grande échelle, l'équipe DeepSeek a mis en place plusieurs équilibreurs de charge. Ces équilibreurs de charge visent à équilibrer la charge de calcul et de communication entre tous les GPU, évitant qu'un seul GPU ne devienne un goulot d'étranglement en raison d'une surcharge de calcul, et assurant ainsi une utilisation efficace des ressources.

En termes de performances du service, le service d'inférence DeepSeek-V3/R1 fonctionne sur un GPU H800, utilisant la même multiplication matricielle et le même format de transfert que le processus d'entraînement. Selon les dernières données statistiques, le système a traité 608 milliards de jetons d'entrée au cours des dernières 24 heures, avec un taux d'occupation maximal des nœuds de 278 et un taux d'occupation moyen quotidien de 226,75. Les performances globales du service sont donc bonnes.

Le système d'inférence DeepSeek-V3/R1, grâce à une conception d'architecture efficace et à une gestion intelligente de la charge, améliore non seulement les performances d'inférence des modèles d'IA, mais fournit également une infrastructure solide pour les futures recherches et applications de l'AGI.

Projet : https://github.com/deepseek-ai/open-infra-index/blob/main/202502OpenSourceWeek/day_6_one_more_thing_deepseekV3R1_inference_system_overview.md

Points clés :

🌟 Le système d'inférence DeepSeek-V3/R1, grâce à la technique de parallélisme d'experts inter-nœuds, permet un débit plus élevé et une latence plus faible.

📊 L'utilisation d'une stratégie de chevauchement à double lot et d'un pipeline à cinq niveaux améliore l'efficacité du calcul et optimise le processus de communication.

🔄 La mise en place de plusieurs équilibreurs de charge garantit une utilisation efficace des ressources des GPU et évite les goulots d'étranglement.