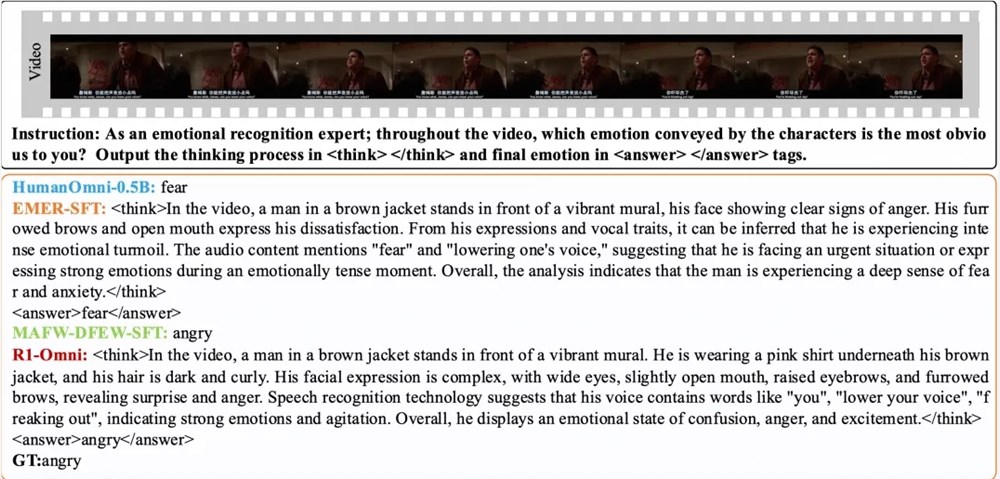

Le 11 mars, l'équipe du laboratoire Tongyi a annoncé la publication en open source du modèle R1-Omni, marquant une nouvelle avancée dans le développement des modèles multimodaux. Ce modèle combine l'apprentissage par renforcement et une méthode de récompense vérifiable (RLVR), axée sur l'amélioration des capacités de raisonnement et des performances de généralisation dans les tâches d'identification des émotions multimodales.

L'entraînement de R1-Omni se déroule en deux phases. Dans la phase de démarrage à froid, l'équipe utilise un ensemble de données combinées comprenant 580 vidéos provenant des ensembles de données EMER (Explainable Multimodal Emotion Reasoning) et HumanOmni pour l'ajustement fin. Cette phase vise à établir les capacités de raisonnement de base du modèle, en s'assurant qu'il possède une certaine capacité d'identification des émotions multimodales avant d'entrer dans la phase RLVR, garantissant ainsi la fluidité, l'efficacité et la stabilité de l'entraînement ultérieur.

Ensuite, dans la phase RLVR, le modèle est optimisé davantage grâce à l'apprentissage par renforcement et à un mécanisme de récompense vérifiable. Cette phase repose sur le modèle de politique et la fonction de récompense. Le modèle de politique traite les données d'entrée multimodales constituées d'images vidéo et de flux audio, générant des réponses candidates avec un processus de raisonnement détaillé, montrant comment le modèle intègre les informations visuelles et auditives pour parvenir à une prédiction. La fonction de récompense, inspirée de DeepSeek R1, est divisée en une récompense de précision et une récompense de format, formant ensemble la récompense finale, encourageant ainsi le modèle à générer des prédictions correctes tout en garantissant une sortie structurée et conforme au format prédéfini.

Les résultats expérimentaux montrent que R1-Omni surpasse le modèle de base d'origine de plus de 35 % en moyenne sur les ensembles de test de même distribution DFEW et MAFW, et surpasse le modèle d'ajustement fin supervisé (SFT) de plus de 10 % en termes de taux de rappel moyen non pondéré (UAR). Sur l'ensemble de test de distribution différente RAVDESS, son taux de rappel moyen pondéré (WAR) et son UAR sont améliorés de plus de 13 %, démontrant une capacité de généralisation exceptionnelle. De plus, R1-Omni présente un avantage significatif en termes de transparence. Grâce à la méthode RLVR, le rôle des informations audio et vidéo dans le modèle devient plus clair, permettant de montrer clairement le rôle crucial de chaque information modale dans le jugement d'émotions spécifiques, fournissant ainsi une référence importante pour la compréhension du processus décisionnel du modèle et les recherches futures.

Article :

https://arxiv.org/abs/2503.05379

Github :

https://github.com/HumanMLLM/R1-Omni

Modèle :

https://www.modelscope.cn/models/iic/R1-Omni-0.5B