Dans le domaine de l'intelligence artificielle, l'équipe du laboratoire Alibaba Tongyi a récemment annoncé la publication en open source de son dernier modèle multimodal : R1-Omni. Ce modèle, combinant l'apprentissage par renforcement et la méthode de récompense vérifiable (RLVR), a démontré des capacités exceptionnelles dans le traitement de l'information audio et vidéo. Le point fort de R1-Omni réside dans sa transparence, permettant une compréhension plus claire du rôle de chaque modalité dans le processus décisionnel, notamment dans des tâches telles que la reconnaissance des émotions.

Avec le lancement de DeepSeek R1, le potentiel de l'apprentissage par renforcement dans les grands modèles est de plus en plus exploré. La méthode RLVR apporte de nouvelles pistes d'optimisation pour les tâches multimodales, permettant de traiter efficacement des tâches complexes telles que le raisonnement géométrique et le comptage visuel. Bien que les recherches se concentrent actuellement sur la combinaison d'images et de texte, les dernières explorations du laboratoire Tongyi étendent ce domaine en combinant RLVR avec un modèle multimodal vidéo, démontrant ainsi le vaste potentiel d'application de cette technologie.

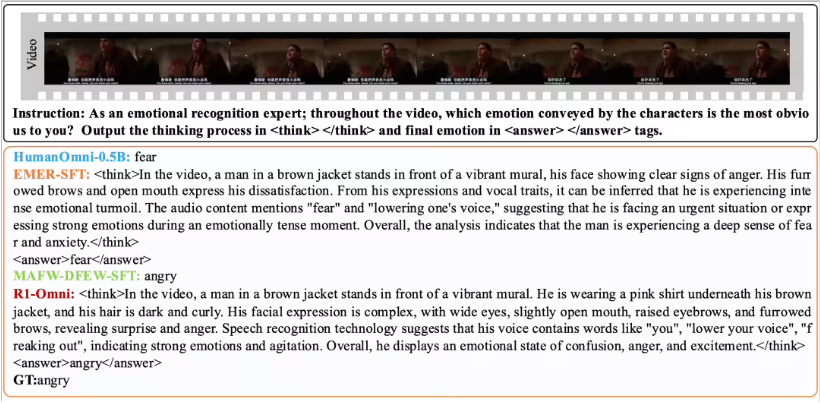

Grâce à la méthode RLVR, R1-Omni rend l'influence des informations audio et vidéo plus intuitive. Par exemple, dans les tâches de reconnaissance des émotions, le modèle peut clairement montrer quels signaux audio et vidéo ont joué un rôle crucial dans le jugement émotionnel. Cette transparence améliore non seulement la fiabilité du modèle, mais offre également aux chercheurs et aux développeurs une meilleure compréhension.

En termes de validation des performances, l'équipe du laboratoire Tongyi a comparé R1-Omni au modèle HumanOmni-0.5B original. Les résultats montrent une amélioration significative des performances de R1-Omni sur les ensembles de données DFEW et MAFW, avec une augmentation moyenne de plus de 35 %. De plus, par rapport aux modèles d'ajustement fin supervisé (SFT) traditionnels, R1-Omni a également amélioré l'apprentissage non supervisé (UAR) de plus de 10 %. Sur différents ensembles de tests de distribution (tels que RAVDESS), R1-Omni a démontré une excellente capacité de généralisation, avec une amélioration du WAR et de l'UAR de plus de 13 %. Ces résultats prouvent non seulement l'avantage de RLVR pour améliorer les capacités de raisonnement, mais offrent également de nouvelles pistes et orientations pour les futures recherches sur les modèles multimodaux.

La publication en open source de R1-Omni facilitera le travail de nombreux chercheurs et développeurs. Nous espérons que ce modèle permettra de nombreuses innovations et avancées dans les applications futures.