Lors d'une conférence de presse, Sundar Pichai, PDG de Google, a annoncé la publication en open source de Gemma-3, son dernier grand modèle multimodal. Ce modèle, caractérisé par son faible coût et ses hautes performances, a suscité un vif intérêt.

Gemma-3 est disponible en quatre tailles de paramètres : 1 milliard, 4 milliards, 12 milliards et 27 milliards de paramètres. De manière surprenante, le modèle le plus grand (27 milliards de paramètres) ne nécessite qu'une seule carte graphique H100 pour une inférence efficace, alors que des modèles similaires exigent souvent dix fois plus de puissance de calcul. Cela fait de Gemma-3 l'un des modèles hautes performances ayant les exigences de calcul les plus faibles à ce jour.

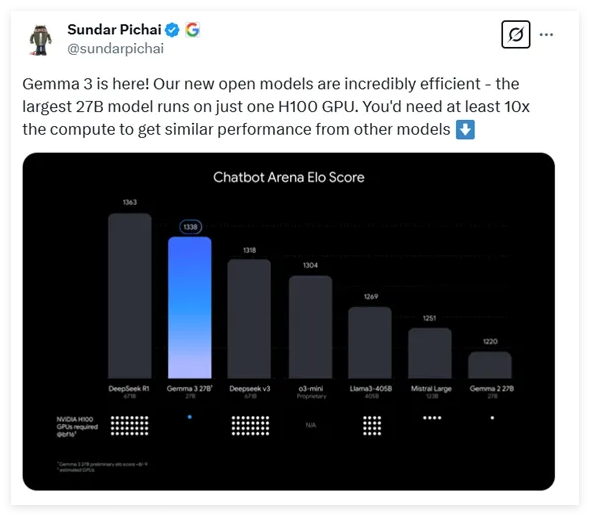

Selon les derniers résultats de tests, Gemma-3 affiche d'excellentes performances dans les comparaisons de modèles de dialogue, se classant juste derrière le célèbre modèle DeepSeek et surpassant plusieurs modèles populaires tels que o3-mini d'OpenAI et Llama3.

L'architecture de Gemma-3, publiée cette fois-ci, reprend le design du transformateur de décodeur universel des deux générations précédentes, mais intègre de nombreuses innovations et optimisations. Pour résoudre les problèmes de mémoire liés aux longs contextes, Gemma-3 utilise une architecture alternant les couches d'auto-attention locales et globales, réduisant ainsi considérablement l'occupation mémoire.

En termes de capacité de traitement du contexte, Gemma-3 prend en charge une longueur de contexte étendue à 128 000 jetons, offrant une meilleure prise en charge du traitement de longs textes. De plus, Gemma-3 possède des capacités multimodales, capable de traiter simultanément du texte et des images, et intègre un encodeur visuel basé sur VisionTransformer, réduisant efficacement le coût de calcul du traitement d'images.

Pendant l'entraînement, Gemma-3 a utilisé un budget de jetons plus important, notamment 14 T de jetons pour le modèle à 27 milliards de paramètres, et a intégré des données multilingues pour améliorer ses capacités de traitement du langage, prenant en charge 140 langues, dont 35 directement utilisables.

Gemma-3 a utilisé une technique avancée de distillation de connaissances. En phase finale d'entraînement, l'apprentissage par renforcement a permis d'optimiser les performances du modèle, notamment en termes d'aide, de raisonnement et de capacités multilingues.

Les évaluations montrent que Gemma-3 excelle dans les tâches multimodales et que sa capacité de traitement de longs textes est impressionnante, atteignant un taux de précision de 66 %. De plus, Gemma-3 se classe parmi les meilleurs dans l'évaluation des capacités de dialogue, démontrant ses capacités globales dans diverses tâches.

Adresse : https://huggingface.co/collections/google/gemma-3-release-67c6c6f89c4f76621268bb6d

Points clés :

🔍 Gemma-3 est le dernier grand modèle multimodal open source de Google, avec un nombre de paramètres allant de 1 milliard à 27 milliards, et une réduction de 10 fois des besoins en puissance de calcul.

💡 Le modèle utilise une conception architecturale innovante pour traiter efficacement les longs contextes et les données multimodales, prenant en charge le traitement simultané de texte et d'images.

🌐 Gemma-3 prend en charge le traitement de 140 langues. Après optimisation de l'entraînement, il excelle dans plusieurs tâches, démontrant de puissantes capacités globales.